| |

|

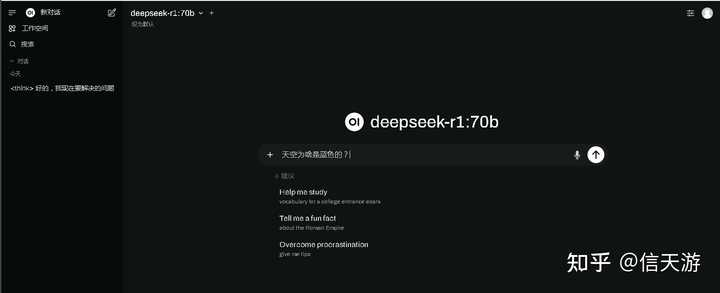

| 知识库 -> 数码 -> 有必要自己将deepseek部署到本地吗? -> 正文阅读 |

|

|

[数码]有必要自己将deepseek部署到本地吗? |

| [收藏本文] 【下载本文】 |

|

想替自己完成一些统计汇总和类预测的工作,是不是有点大材小用了? |

|

直接说结论:有必要 举几个例子: 金融行业:处理敏感的客户数据,需满足合规要求。医疗行业:分析患者病历,确保数据隐私。制造业:实时监控生产线,需要低延迟响应。科研机构:进行定制化模型研究和开发。如果您的业务对数据隐私、定制化需求、实时性或长期成本控制有较高要求,且具备相应的技术能力和硬件资源,那么自行部署DeepSeek到本地是一个值得考虑的选择。顺带教大家如何在10分钟内零基础地完全本地化部署DeepSeek-R1模型。 |

|

|

1.为什么要自己部署DeepSeek? 最近DeepSeek非常火爆!它不仅能撰写文案和进行研究,还能联网实时回答问题,堪称智能助理界的“小钢炮”! 不过,官网常常出现以下问题: 1.高峰期排队让人怀疑人生 2.服务器时常不稳定 3.想用时总是无法使用 因此,今天我来教大家一个技巧:将DeepSeek安装到自己的电脑上!这样你就可以随时使用,再也不用看服务器的脸色! 2.选择适合你的DeepSeek版本 首先,咱们得挑选一个适合自己电脑的版本。 三个版本,总有一款适合你: 1. 小巧版(1.5B) 特点:轻便灵活,适合文字处理 对电脑要求低,笔记本也能轻松运行 完全满足日常办公需求 2. 标准版(7B) 特点:智商在线,能处理复杂任务 需较好电脑配置(16G内存起步) 推荐首选,性价比最高! 3. 加强版(8B) 特点:超强性能,但对配置要求高 建议有高配电脑的用户选择 普通用户慎入,以免电脑崩溃... 别急着往下冲,先检查下你的电脑配置! |

|

|

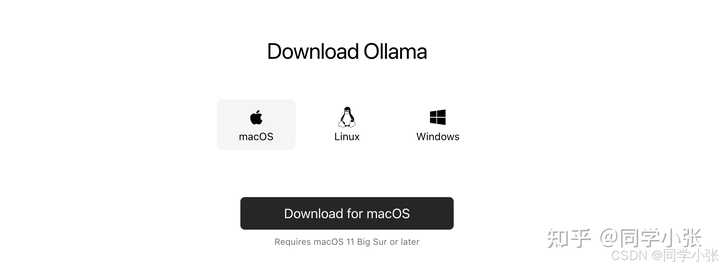

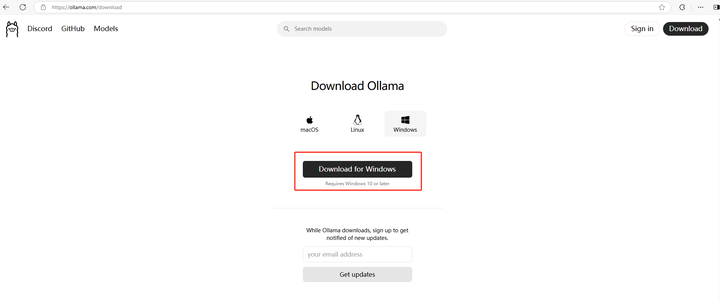

Windows用户:内存:最少8GB(建议16GB)显卡:要有NVIDIA显卡(GTX 1060以上)CPU:i5处理器或同等级别 Mac用户:内存:8GB起步芯片:M1或更新款系统:最新版macOS 3.DeepSeek学习资源 官方文档:https://docs.deepseek.com/ 包含模型架构、API 接口说明、部署指南、微调教程等 GitHub示例仓库:deepseek-ai/examples 官方代码库(模型、工具链、示例项目) API 文档:https://chat.deepseek.com/503/ 详细接口参数说明与调用示例 模型下载:https://huggingface.co/deepseek-ai 各版本模型权重与配置文件 开始部署本地化: 第一步:安装Ollama管理工具,视其为DeepSeek的“管家”,负责全面管理。 去Ollama官网下载安装包(https://ollama.com/) |

|

|

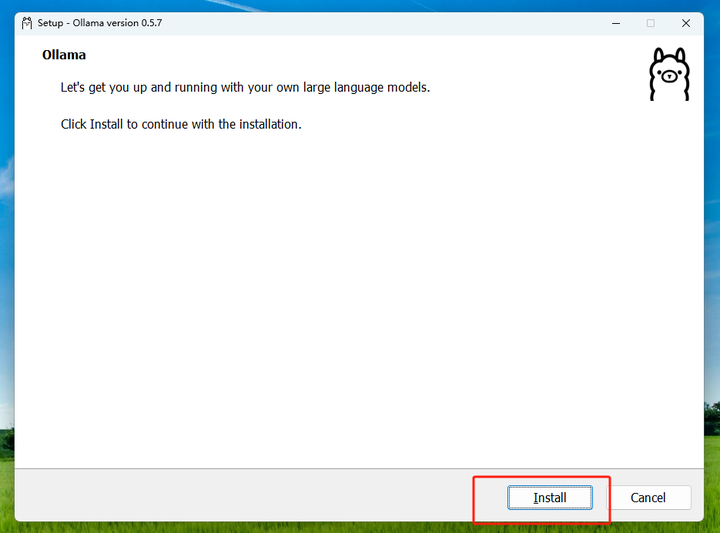

点击Downlod |

|

|

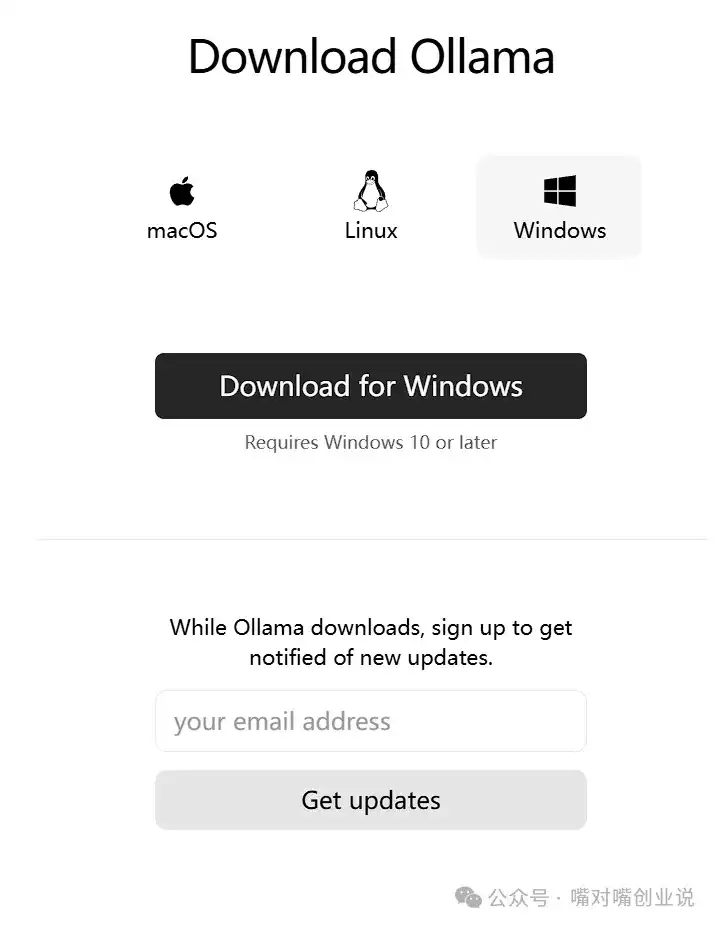

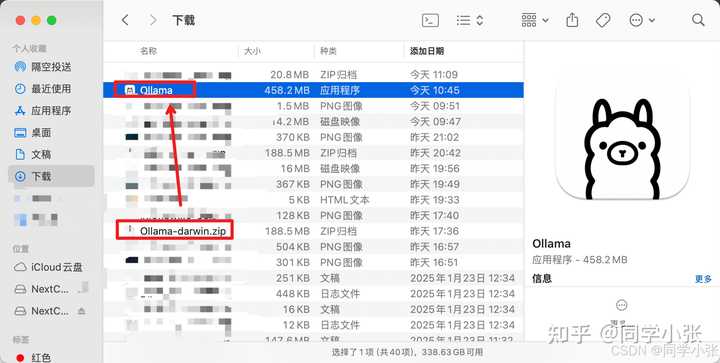

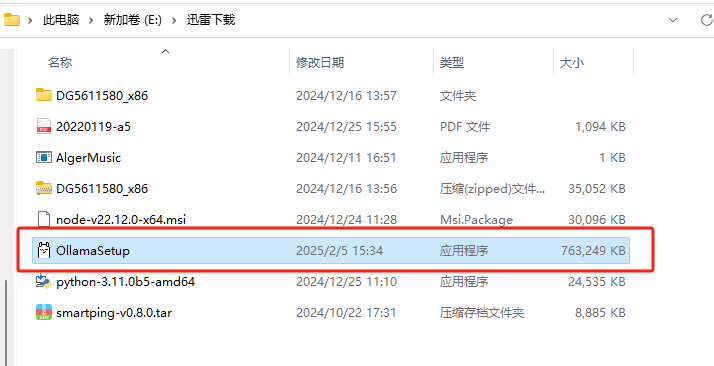

Windows用户,点击 Download for Windows Mac用户,点击 Download for Mac 文件下载完成后: |

|

|

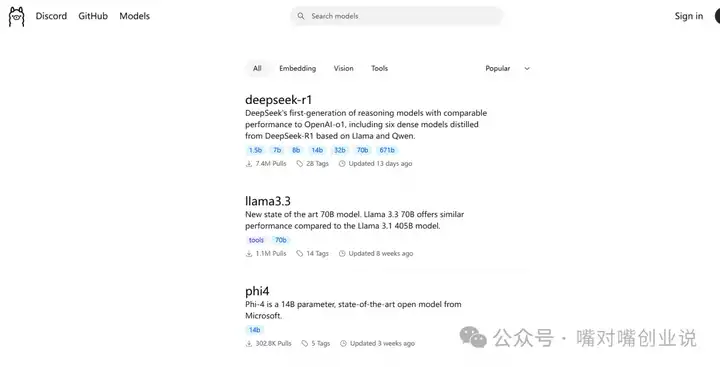

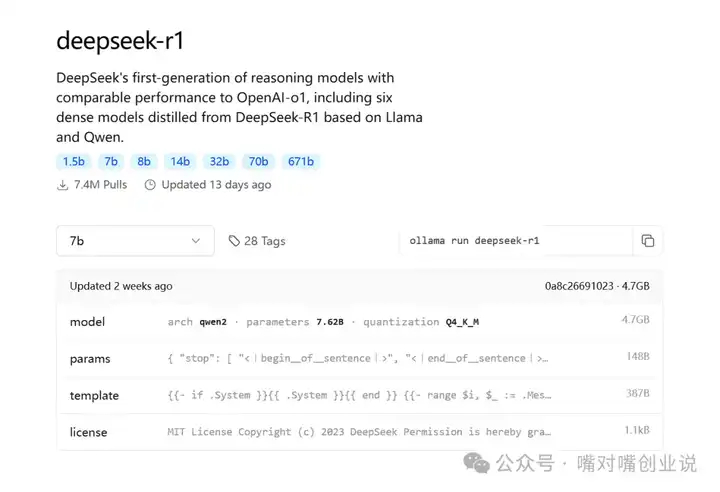

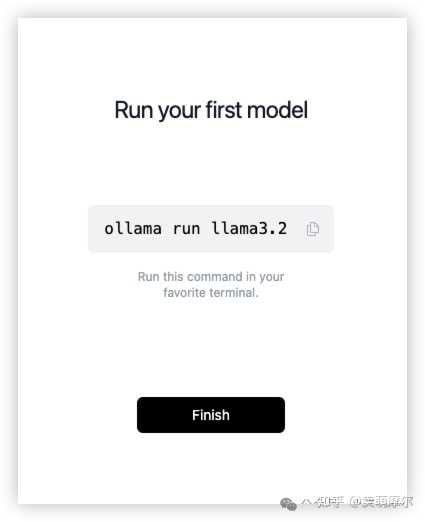

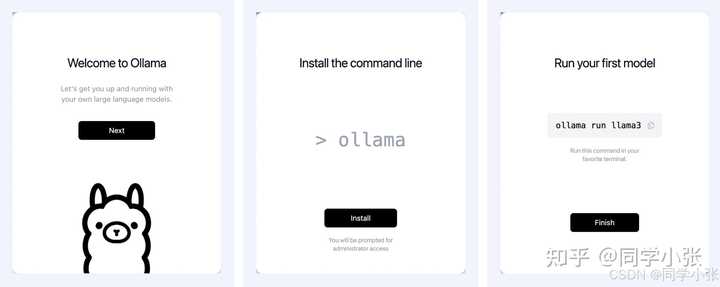

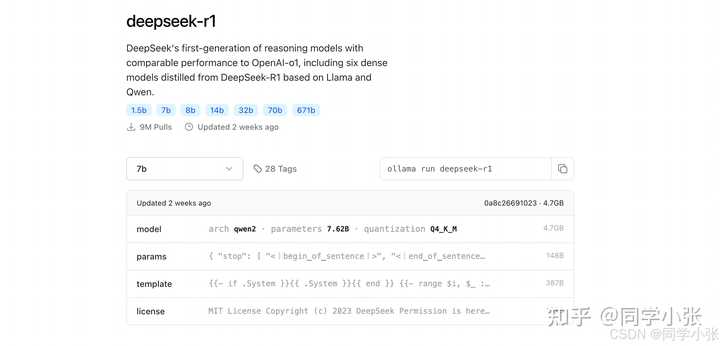

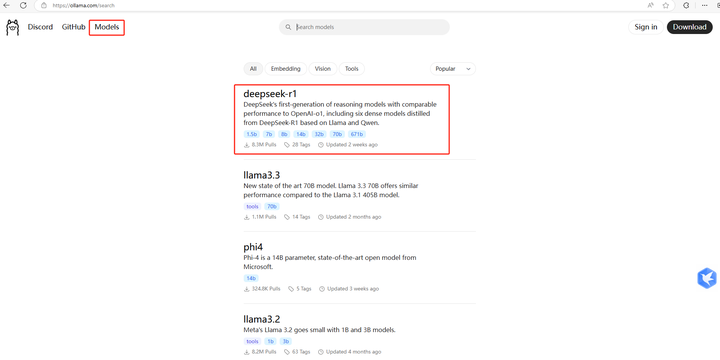

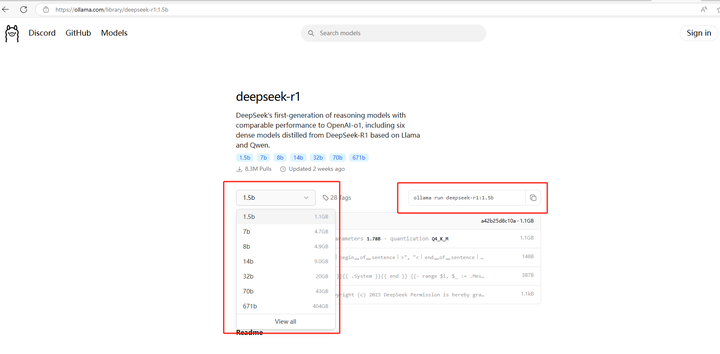

Windows用户双击安装,Mac用户拖进应用程序文件夹 安装完成 第二步:部署DeepSeek模型 切换到Ollama官网,选择Models,找到【deepseek-r1】。建议选择【7b】版本,既配置适中,性能也足够。 |

|

|

|

|

|

选择7b,然后复制右边的 ollama run deepseek-r1 |

|

|

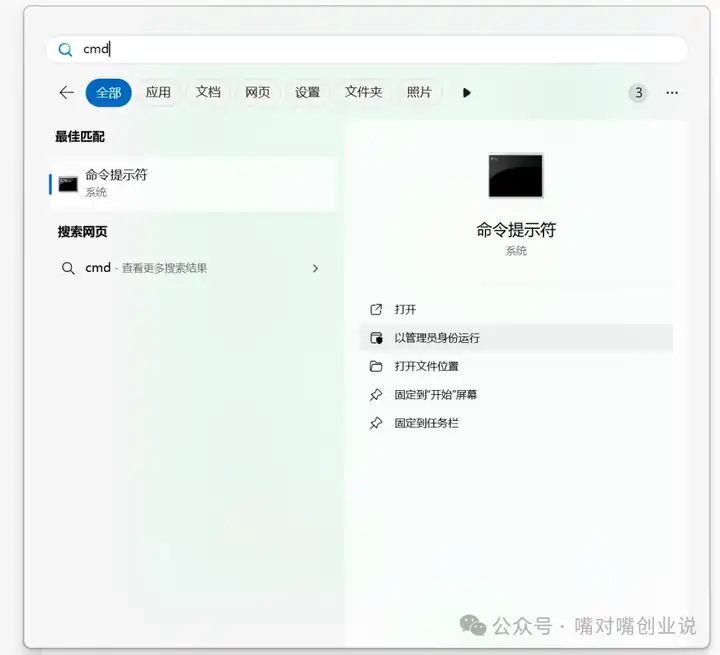

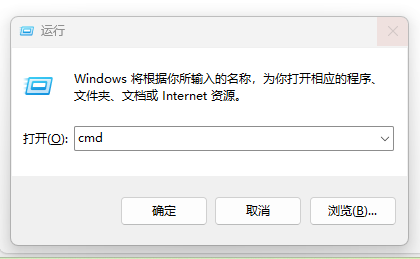

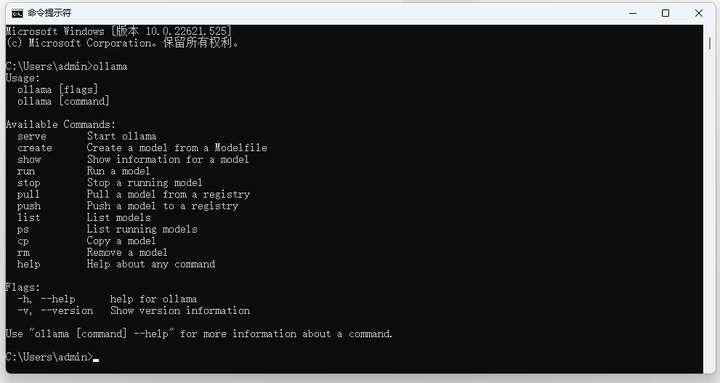

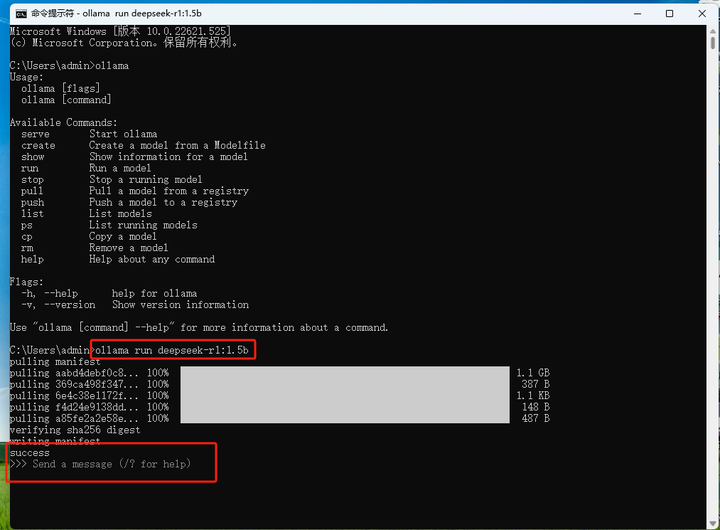

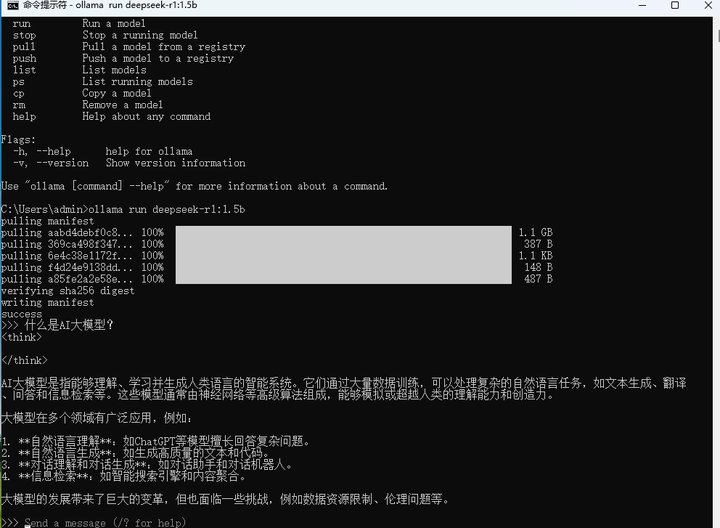

第三步:以管理员身份运行命令提示符 打开命令行(Windows按Win+R输入cmd,Mac打开终端) |

|

|

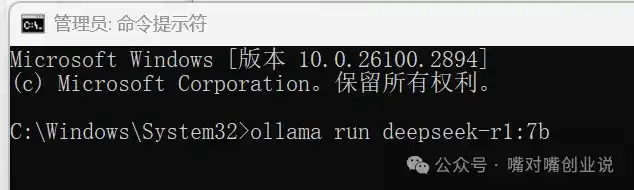

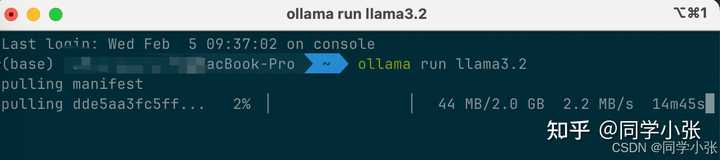

输入或粘贴命令行:ollama run deepseek-r1:7b |

|

|

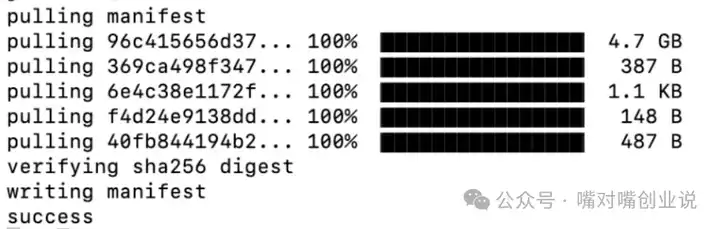

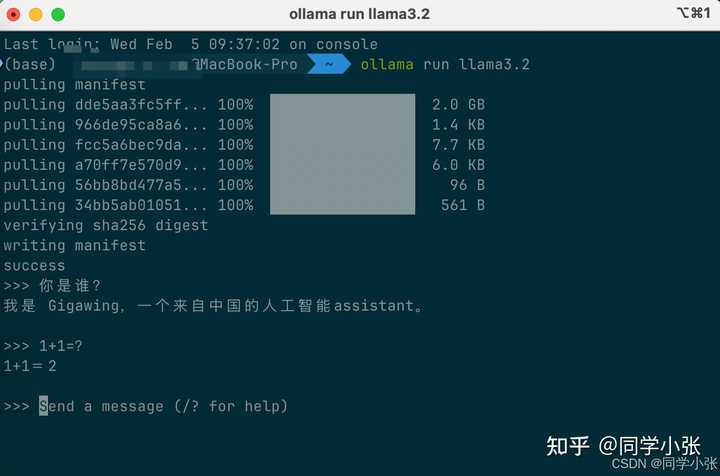

安心等待下载完成... |

|

|

安装完成,进行下一步 第四步:安装DeepSeek运行的界面 下载安装Chatbox(https://chatboxai.app/zh) |

|

|

点击免费下载 |

|

|

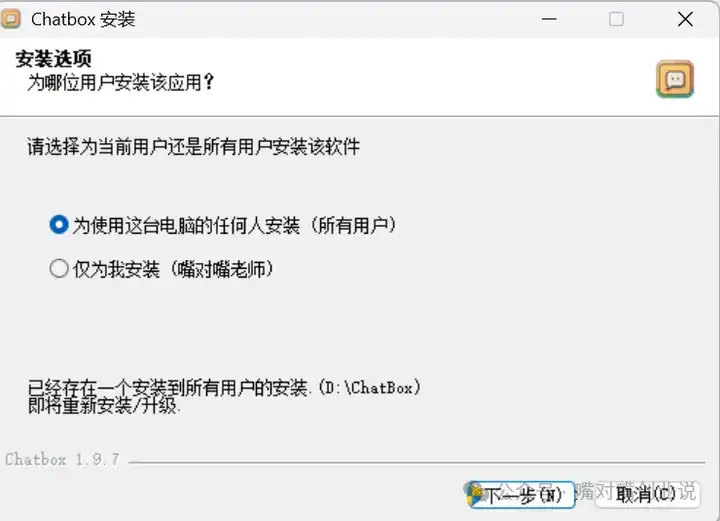

点击下一步 |

|

|

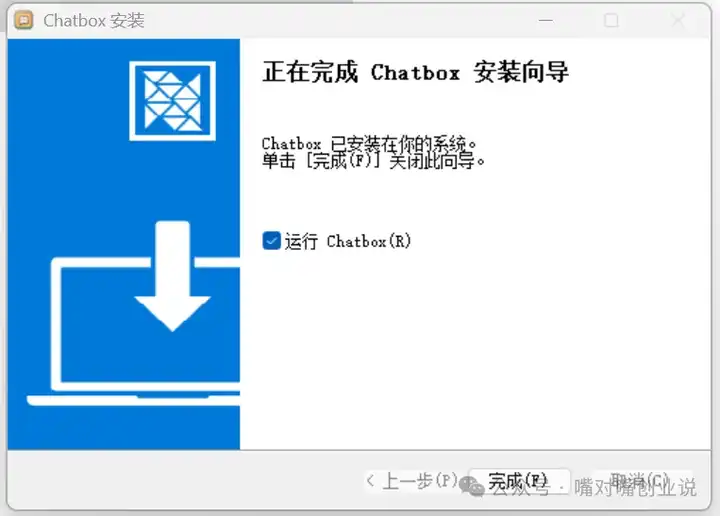

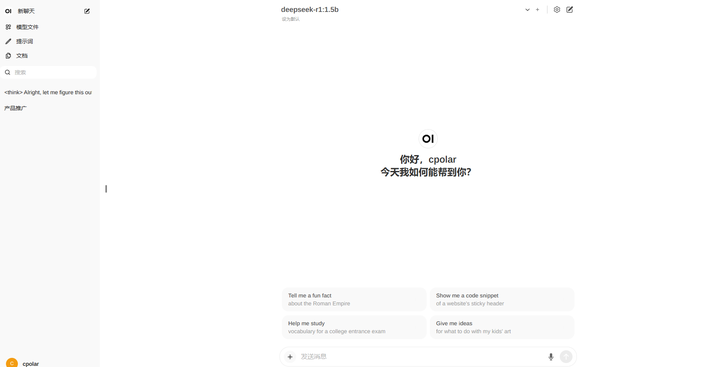

点击完成 进入软件后选择"Ollama API" |

|

|

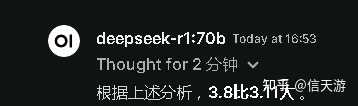

按图中配置 第五步:使用DeepSeek 大功告成!本地部署的深度思考过程与Web版体验基本一致,接下来可以放心使用deepseek,再也不必担心访问受限了! |

|

|

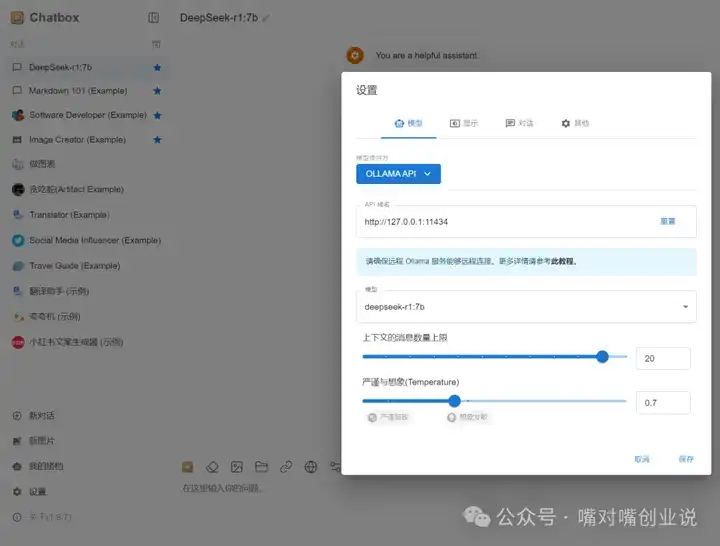

如何使用云端版本? 如果你的电脑无法支持,可以尝试云端版本。 作为重度用户,我深感本地部署虽好,但确实会导致过热——在运行7B模型时,CPU温度接近90℃。 去硅基流动官网注册账号(https://cloud.siliconflow.cn/i/q6F4qqBf) |

|

|

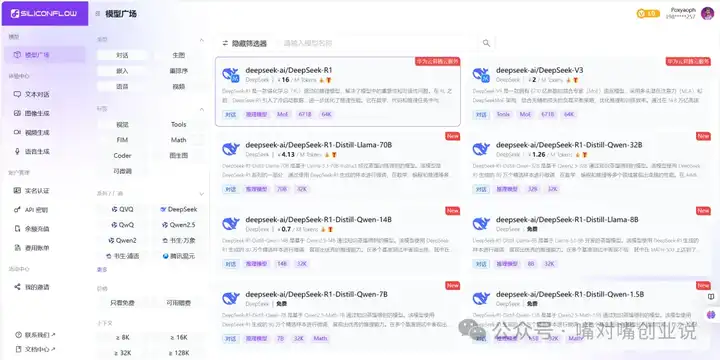

进入首页后,点击「模型广场」,找到【DeepSeek-R1】,再选择“在线体验”。 |

|

|

点击框选住的模型 |

|

|

|

|

|

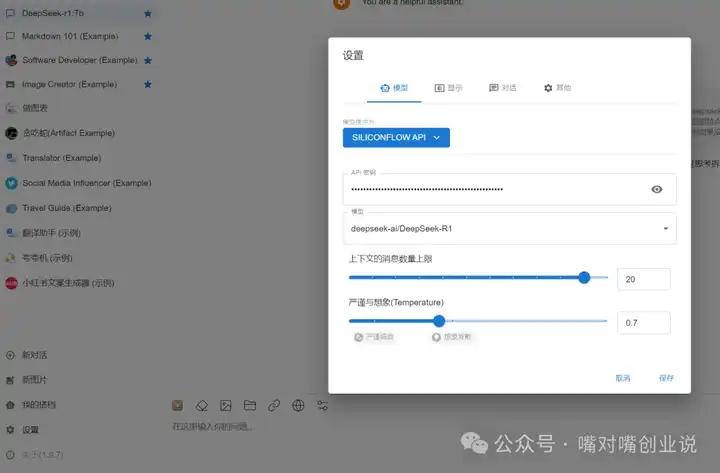

可直接进行使用。 若担心网页意外关闭导致讨论内容“失联”,可以通过接入API与Chatbox关联,效果更佳。 在Chatbox上接入硅基流动API,只需简单三步: 回到硅基流动首页,左侧栏点击 「API密钥」→ 新建API密钥 → 复制密钥 |

|

|

打开Chatbox 应用之后,点击左下角,打开设置选项: |

|

|

根据上述配置修改后,即可在云端运行DeepSeek |

|

|

总结 通过本教程,你已掌握DeepSeek的使用方法,无论是本地部署还是云端体验,都能轻松享受AI的便利! 如有疑问,欢迎在评论区或沟通群提问,期待交流! |

|

没必要, 大部分人的显存4090是上限了, 只能跑量化版本, 量化后的意义不大, 不如用API。 5块钱的token用不完。 |

|

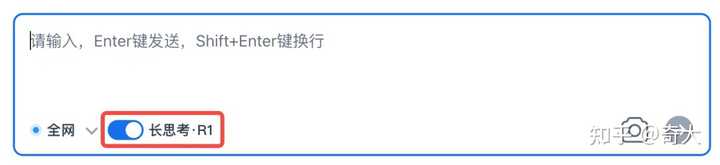

首先说明一点,把DeepSeek安装到本地,主要有两个应用场景。 一个是断网使用,很多专有网络是不连互联网的,也不能连互联网,本地安装一个大模型,可以当作搜索引擎使用。 还有一个是私有化部署,用来搭建本地知识库,主要是帮助企业和个人做专业的服务。 如果是要联网使用,我不建议在本地安装DeepSeek,一方面对电脑的配置要求高,搞不好还得买专业的显卡;再一方面是满足不了联网使用的需求。 想要联网使用DeepSeek,又担心官网总是不能用,我这里给出一个解决方案。 秘塔AI搜索刚刚已经集成了DeepSeek-R1满血版。 秘塔AI搜索的网址:https://metaso.cn/ |

|

|

秘塔AI搜索想必有些人并不陌生,这个AI搜索工具集成了高质量的知识库,不少人用来辅助写论文。 现在加上最强推理,这款AI工具的战斗力瞬间拉满。 秘塔AI搜索默认是不用DeepSeek的,如果要使用DeepSeek的深度推理,需要打开开关。 |

|

|

简单问一个问题看看效果 |

|

|

先给出了思考过程,接着回答问题,是不是很DeepSeek? 回答的时候,用到了参考资料的地方,都在文中做了标注,并在文末把用到的参考资料都列出来了。 有了这款AI工具,再也不用担心DeepSeek不能用了。 作者简介 您好,我是奇大,毕业于北邮,数据可视化专家,AI布道师。 10多年互联网研发和管理经验,我将分享高质量的职场认知和技术干货,欢迎围观。 公众号:AI奇大,欢迎围观。 |

|

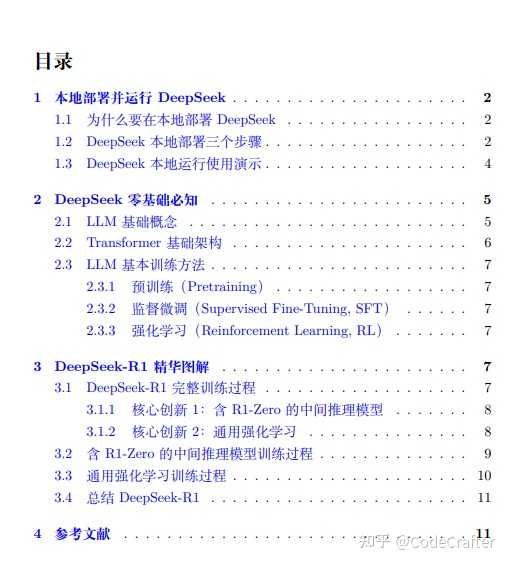

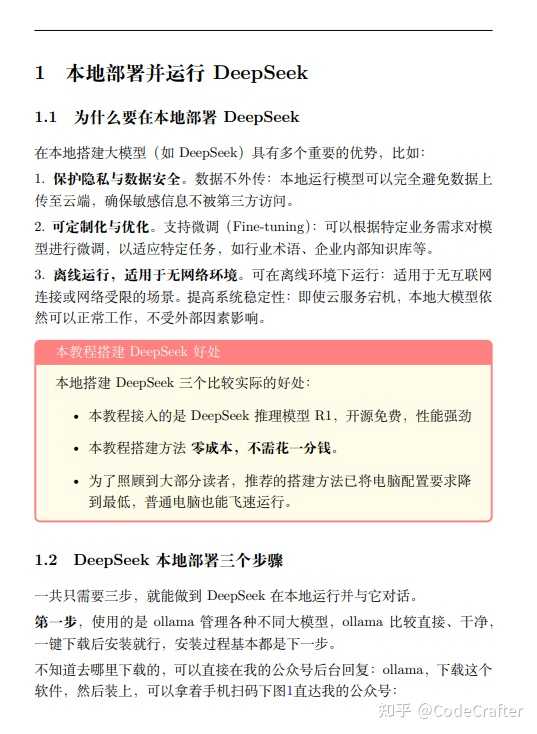

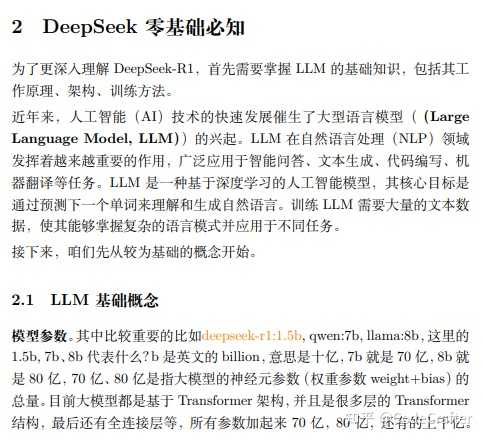

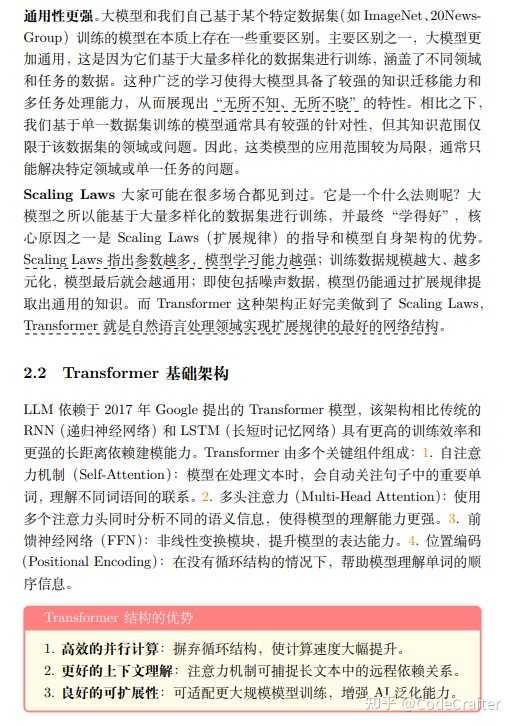

DeepSeek-R1目前在市场上教程稀缺,许多用户在使用过程中,往往只停留在工具的基本操作层面,对原理知之甚少,导致应用效果不佳。 而原理的理解,是高效应用的关键。如果你希望定制专属的DeepSeek模型以满足业务需求,掌握基本原理更是当务之急。 这本小册子从20多页的英文论文中提炼核心内容,通过图解的方式直观展示DeepSeek的核心创新。 手册免费获取地址:10页纸速成图解指南!DeepSeek-R1原理剖析与实战部署一网打尽! |

|

|

内容精炼且通俗易懂,即使是初学者也能轻松上手。它完全开源免费,采用专业排版工具制作,阅读体验良好。 通过学习这本小册子,你将深入了解DeepSeek-R1的创新之处,掌握大模型的基本知识,并能够成功将DeepSeek部署到本地电脑。 手册部分内容 |

|

|

|

|

|

|

|

|

|

|

|

这不仅能帮助你更好地使用DeepSeek-R1,还能为后续的定制化开发打下坚实基础。 |

|

我在想,以后,这类大模型会不会和网盘一样流行 自己可以上传数据训练,自己用。但是,也存在不定时审核,把训练数据咔嚓掉 然后有能力的用户就像现在一样选择“自建网盘” |

|

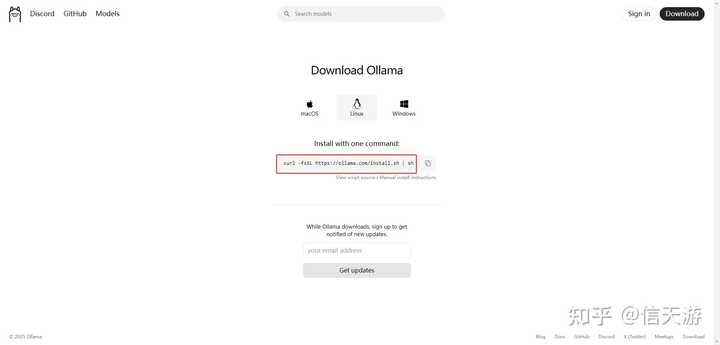

回答:有必要。好处很多: 数据隐私与安全性:所有数据处理和存储均在本地完成,无需上传云端,有效保护个人或企业敏感信息。定制化与离线使用:可根据自身需求对模型进行微调或定制知识库训练,且在无网络环境下也能使用。成本控制:长期来看,本地部署避免了高额的云服务费用,适合频繁调用的场景。 详细步骤看下面: 一、什么是 DeepSeek-R1 2025.01.20 DeepSeek-R1 发布,DeepSeek R1 是 DeepSeek AI 开发的第一代推理模型,擅长复杂的推理任务,官方对标OpenAI o1正式版。适用于多种复杂任务,如数学推理、代码生成和逻辑推理等。 根据官方信息DeepSeek R1 可以看到提供多个版本,包括完整版(671B 参数)和蒸馏版(1.5B 到 70B 参数)。完整版性能强大,但需要极高的硬件配置;蒸馏版则更适合普通用户,硬件要求较低。 二、总体架构与工具选择2.1 硬件配置说明 下面整理了一个关于 Deepseek-R1 各版本(例如 1.5B、7B、8B、14B 等)在本地部署时,对于 Windows 与 macOS 平台的硬件推荐配置表。注意: 表中配置仅供参考,实际需求会根据使用场景、上下文长度(num_ctx 参数)以及具体模型(例如蒸馏版与全量版)的差异有所变化;macOS 部分分别给出了 Intel 芯片和 Apple Silicon(M1/M2 系列)两种设备的建议;对于 GPU 部分,若无独立显卡也可采用 CPU-only 模式,但响应速度可能较慢。Model VersionPlatformRecommended CPURecommended MemoryRecommended GPURecommended Storage1.5BWindowsQuad-core (如 Intel i5 或 Ryzen 5)8 ~ 16GB可选:若有独立 GPU,建议 ≥4GB VRAM;无则使用 CPU 模式50 ~ 100GB SSDmacOS (Intel)Quad-core (如 Intel i5/i7)8 ~ 16GB可选:集成显卡可应付轻量任务;独立 GPU 效果更佳50 ~ 100GB SSDmacOS (Apple Silicon)Apple M1/M2(或更新型号)8GB 最低,建议 16GBApple Silicon 集成 GPU(性能经过专门优化)50 ~ 100GB SSD7BWindows6 ~ 8 核 (如 Intel i7 或 Ryzen 7)16 ~ 32GB推荐独立 GPU,至少 ≥6GB VRAM(如 RTX 2060 及以上)≥100GB SSDmacOS (Intel)6 ~ 8 核 (如 Intel i7)16 ~ 32GB建议采用独立 GPU≥100GB SSDmacOS (Apple Silicon)Apple M1/M2 Pro/Max16GB 最低,建议 32GBApple Silicon 集成 GPU(表现优异)≥100GB SSD8BWindows6 ~ 8 核 (如 Intel i7 或 Ryzen 7)16 ~ 32GB推荐独立 GPU,至少 ≥6~8GB VRAM≥100GB SSDmacOS (Intel)6 ~ 8 核 (如 Intel i7)16 ~ 32GB建议采用独立 GPU≥100GB SSDmacOS (Apple Silicon)Apple M1/M2 Pro/Max16GB 最低,建议 32GBApple Silicon 集成 GPU≥100GB SSD14BWindows8 核 (如 Intel i7/i9 或 Ryzen 9)≥32GB高端独立 GPU,建议 ≥8GB VRAM(如 RTX 3070 及以上)≥150GB SSDmacOS (Intel)8 核 (如 Intel i7/i9)≥32GB建议采用独立 GPU≥150GB SSDmacOS (Apple Silicon)Apple M1/M2 Max(或更新型号)最低 32GB,理想为 64GBApple Silicon 集成 GPU(性能出色)≥150GB SSD 说明CPU:Windows 和 macOS (Intel) 设备建议采用多核处理器;Apple Silicon 设备则依托于其自研 CPU 和 GPU 高效协同。内存:对于轻量版模型(1.5B)8GB 内存即可应付基础任务,但为获得更流畅体验,推荐 16GB 及以上;对于 7B 及 8B 版本建议 16–32GB,而较大版本(如 14B)则建议 32GB 以上。GPU:如果有独立显卡,建议 Windows/macOS(Intel)用户选择具备 4GB 及以上(轻量版)或 6~8GB 以上(较大版本)的 GPU;Apple Silicon 设备则依赖系统集成 GPU,但高配置机型(如配备 M1/M2 Pro/Max)能提供良好性能。存储:模型文件通常较大(根据版本从几十 GB 到上百 GB不等),建议预留足够的 SSD 存储空间,同时考虑到索引文件、缓存数据及临时文件的存储需求。 本教程采用以下工具和流程: Ollama:开源大模型运行平台,支持模型下载、管理和 API 调用。Deepseek-R1 模型:这里以 8B 版本为例,体积较小。Open WebUI:提供基于 Web 的交互界面,让你无需命令行即可对话调试。三、详细步骤 我的本地环境: 机器:MacBook Pro (16GB RAM+) 模型:deepseek-r1:8b 1. 安装 Ollama 1.1 下载安装包: 访问Ollama 官网 |

|

|

点击对应系统的下载链接(Windows 用户选择 Windows 版本)。 下载完成后安装 |

|

|

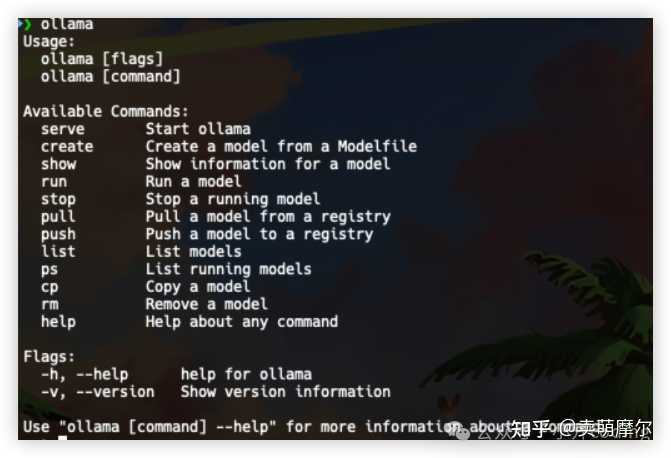

控制台验证是否成功安装,这样就表示安装成功了 |

|

|

2. 下载并部署 Deepseek-R1 模型 2.1 通过 Ollama 拉取模型: 在浏览器中访问 https://ollama.com/library/deepseek-r1Ollama 模型库中的 Deepseek-R1 页面。 |

|

|

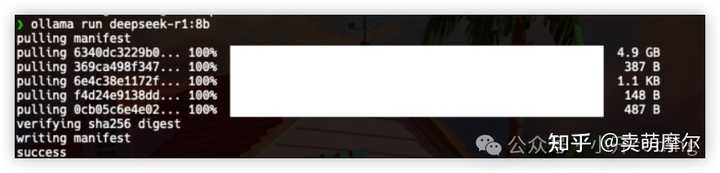

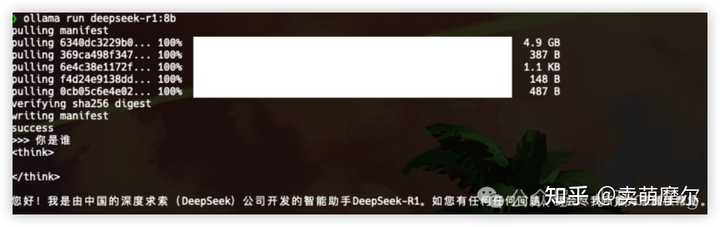

根据自己电脑配置,建议选择参数较小的 8B 版本。 在 CMD 中执行以下命令自动下载并部署模型: ollama run deepseek-r1:8b 执行后,系统会自动下载模型文件,下载完成后进入交互模式。 |

|

|

3. 测试 Deepseek 模型交互 3.1 命令行交互测试: 在 CMD 窗口中执行: ollama run deepseek-r1:8b 你将进入一个交互界面,可以输入问题,例如: |

|

|

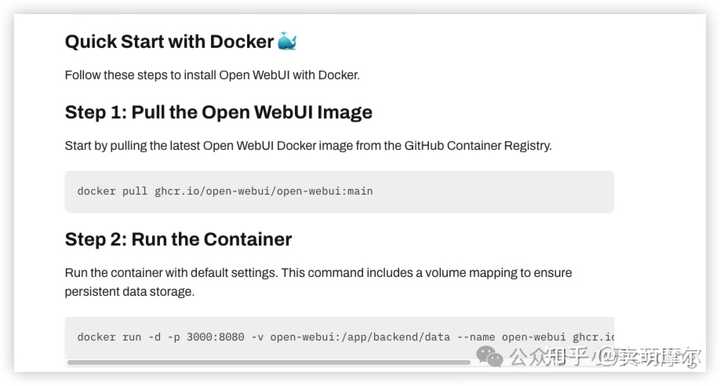

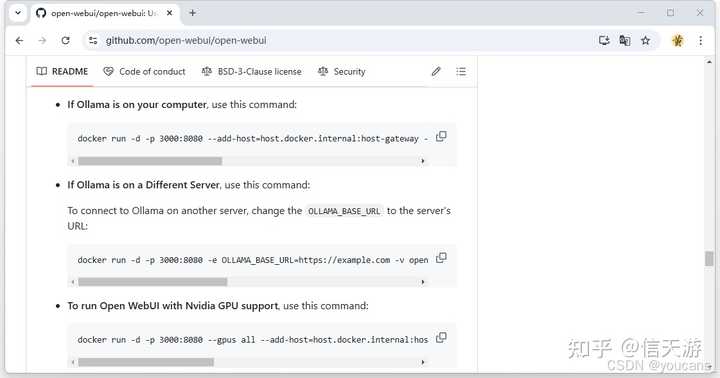

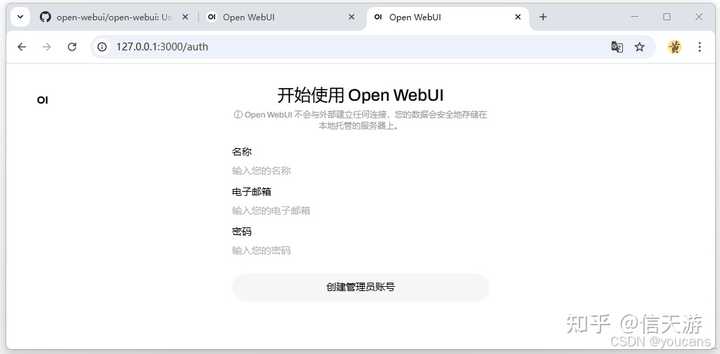

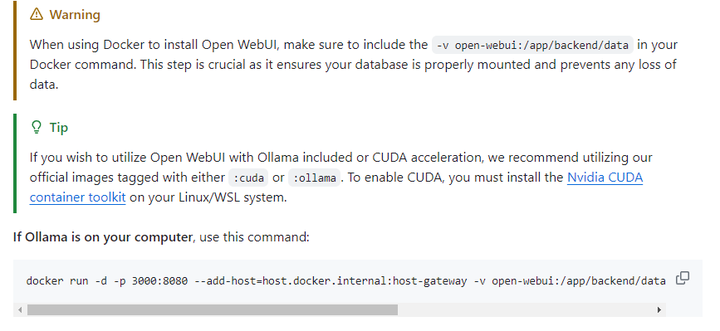

3.2 注意: 如果交互过程中响应较慢,可多按几次回车,耐心等待下载完成和加载模型。4. 安装 Open WebUI(增强交互体验) 4.1 安装 Open WebUI: Open-WebUI官方文档地址:https://docs.openwebui.com/getting-started/ |

|

|

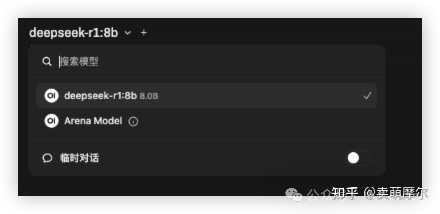

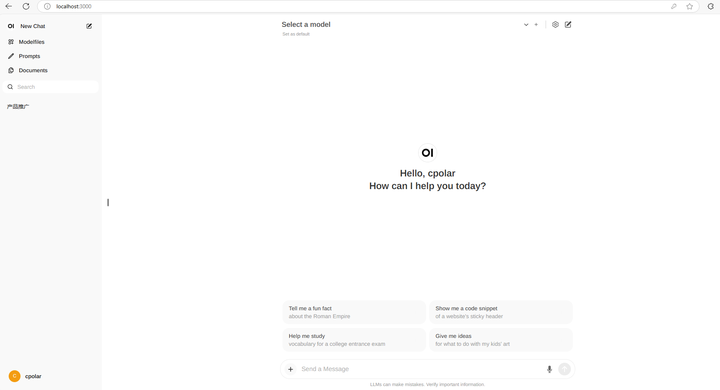

这里直接使用 docker 安装: 如果没有安装过 docker,则从 https://www.docker.com/Docker 官方下载Docker 安装程序。依照提示完成安装即可。 4.2 访问 Open WebUI: 打开浏览器,访问 http://localhost:3000/,进入 WebUI 界面。 首次使用需要注册管理员账号,按提示填写信息完成注册 4.3 在 Open WebUI 中配置 Deepseek 模型: 登录后,进入模型管理页面,选择“添加本地模型”,并填写模型名称(例如:Deepseek-R1-8b)和运行命令。 |

|

|

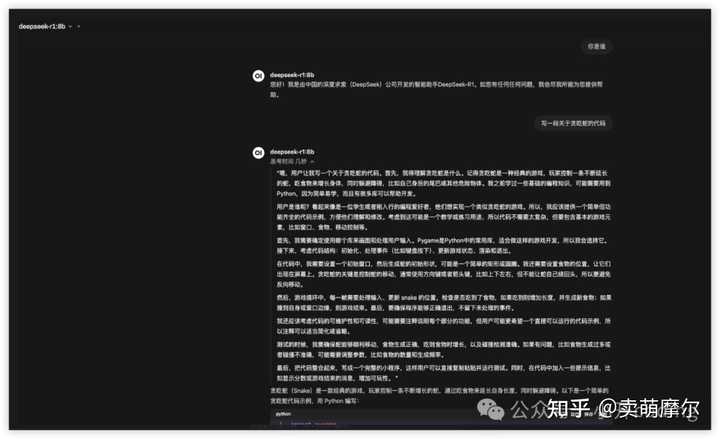

保存设置后,在主界面点击对应模型,即可开始与模型对话。 |

|

|

四、常见问题与注意事项下载及部署过程缓慢?检查网络环境,建议使用清华、阿里镜像加速 pip 下载。Ollama 模型下载失败?可多次尝试或使用 VPN 解决网络问题。内存不足或响应过慢?请检查系统资源,必要时关闭其他占用资源的软件。 详情可关注小开coding公众号,里面有更多 DeepSeek 部署教程供参考~ |

|

本地部署的必要性场景数据敏感性高 涉及医疗、金融、法律等敏感数据时,本地部署可避免云端传输风险,符合GDPR等合规要求。实时性要求严苛 工业控制、高频交易等场景需极低延迟,本地部署可消除网络延迟影响。定制化需求强 需频繁调整模型架构、微调参数或集成私有知识库时,本地部署灵活性更高。长期成本可控 若模型调用频率极高(如日均数万次),本地硬件摊销后可能比云端订阅更经济。 或者自己想简单本地玩一下,熟悉或了解模型的工作机制,在本地部署一个开源大模型既是一件很酷的事,也能够帮我们了解 AI 应用的工作机制,更好的帮我们解放思想,在更多的工作场景使用更先进的生产力。 Deepseek本地部署教程,带UI(普通个人笔记本,无GPU,纯CPU也可使用)大家好,我是 同学小张,+v: jasper_8017 一起交流,持续学习AI大模型应用实战案例,持续分享,欢迎大家点赞+关注,订阅我的大模型专栏,共同学习和进步。 最近大火的DeepSeek-R1,凭借其强大的性能和开源优势,受到了众多用户的关注。它不仅支持代码生成、逻辑推理等复杂任务,还能满足多种应用场景的需求。然而,随着其热度的不断攀升,服务器时常出现繁忙甚至断开链接的情况。 |

|

|

为了确保能够稳定地使用DeepSeek-R1,本地部署无疑是一个绝佳的选择。接下来,我们将详细介绍DeepSeek-R1的本地部署教程。 我的电脑配置: ? 芯片:Apple M4 ? 内存:16GB 无GPU,低CPU也可部署。1. 安装工具 Ollama Ollama 是一个开源的大型语言模型(LLM)服务工具,可以在本地运行开源大语言模型。 1.1 下载 Ollama 下载地址:https://ollama.com/download |

|

|

1.2 安装 Ollama 以 mac 为例,解压后双击安装就行,跟其他应用一样,移动到 Application。 |

|

|

1.3 运行 Ollama 完成下面三步就算完成,最后一步是在你的终端Terminal中运行,第一次运行会自动安装llama3模型,然后自动运行。 |

|

|

|

|

|

运行成功后如下: |

|

|

2. 安装deepseek模型官方建议: 至少有 8 GB 可用内存来运行 7 B 型号,16 GB 来运行 13 B 型号,32 GB 来运行 33 B 型号。 查看地址:https://ollama.com/library/deepseek-r1 |

|

|

我们安装 7b 版本的模型,在终端运行: 安装并运行成功: |

|

|

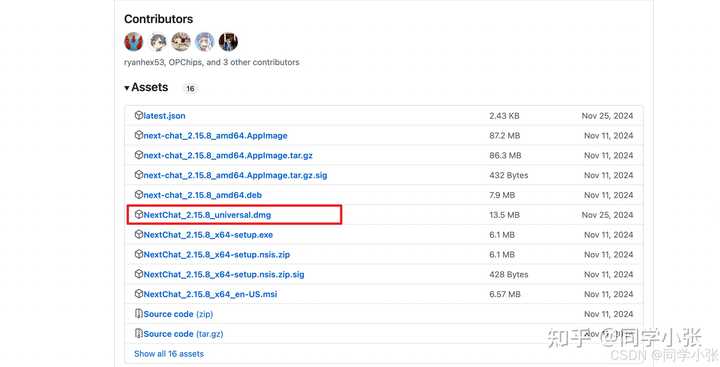

3. 添加 UI 界面 可以用开源的 ChatGPT-Next-Web 快速搭建 3.1 下载 NextChat 地址是:https://github.com/ChatGPTNextWeb/ChatGPT-Next-Web |

|

|

选择比较新的版本下载就好,跟 Ollama 一样的应用安装 |

|

|

|

|

|

3.2 配置 NextChat 从应用中心打开刚安装的 NextChat 应用,点开设置图标开始配置,按下图红框所示,选择 deepseek-r1:7b模型,地址为刚刚起的服务: http://127.0.0.1:11434/ |

|

|

运行和使用成功: |

|

|

4. 可能遇到的问题 (1)Error: Post "http://127.0.0.1:11434/api: dial tcp 127.0.0.1:11434: connect: connection refused 检查Ollama是否正在运行: ? Ollama 没有用户界面,在后台运行。 打开浏览器,输入 “http://localhost:11434 或 http”,显示 “Ollama is running”。 |

|

|

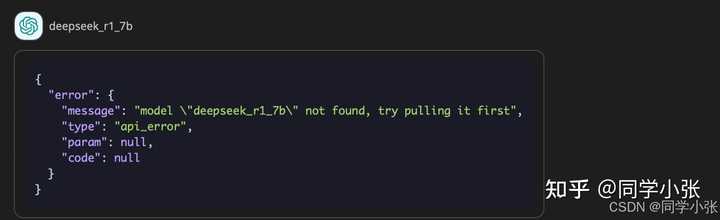

? 如果Ollama正在运行,则可能是下载模型错误,重新执行一次Ollama run那条命令,可能就好了(我是这么解决的) (2)NextChat 配置中的模型名称,一定要与你安装的模型名称完全一致,ollama run deepseek-r1:7b 安装的模型名称是 deepseek-r1:7b,不能错,否则可能遇到下面报错: |

|

|

如果觉得本文对你有帮助,麻烦点个赞和关注呗 ~~~? 大家好,我是 同学小张,持续学习C++进阶、OpenGL、WebGL知识和AI大模型应用实战案例 ? 欢迎 点赞 + 关注 ,持续学习,持续干货输出。 ? +v: jasper_8017 一起交流 ,一起进步 。 ? 微信公众号搜【同学小张】 |

|

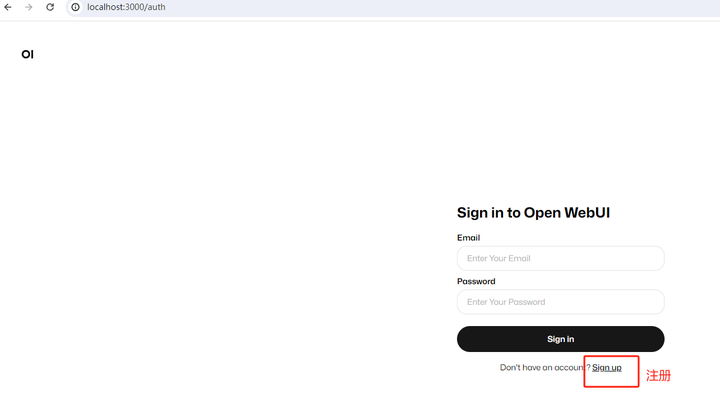

史上最简单方便的 Ollama + Open-WebUI DeepSeek 本地化部署方案出炉! 2025年1月,DeepSeek 正式发布 DeepSeek-R1 推理大模型。DeepSeek-R1 成本价格低廉,性能卓越,在 AI 行业引起了广泛关注。 DeepSeek 提供了多种使用方式,满足不同用户的需求和场景。本地部署在数据安全、性能、定制化、成本、离线可用性和技术自主性方面具有显著优势。 本文详细讲解 基于 Ollama+Docker+OpenWebUI 的本地化部署流程,并通过实例代码演示。该方案能快速让你体验先进的deepseek蒸馏版模型,而不需要忍受官网的每小时才能调用一次的痛苦。 部署环境准备硬件要求模型名称CPU需求内存需求硬盘需求显卡需求DeepSeek-R1-7B8 核以上(推荐现代多核 CPU)16GB+8GB+推荐 8GB+ 显存(如 RTX 3070/4060)DeepSeek-R1-14B12 核以上32GB+15GB+16GB+ 显存(如 RTX 4090 或 A5000)DeepSeek-R1-32B16 核以上(如 AMD Ryzen 9 或 Intel i9)64GB+30GB+24GB+ 显存(如 A100 40GB 或双卡 RTX 3090)DeepSeek-R1-70B32 核以上(服务器级 CPU)128GB+70GB+多卡并行(如 2x A100 80GB 或 4x RTX 4090)DeepSeek-R1-671B64 核以上(服务器集群)512GB+300GB+多节点分布式训练(如 8x A100/H100)软件环境 操作系统:Windows、Linux(推荐 Ubuntu 系统)。必备工具:Docker、NVIDIA驱动(如使用 GPU)。 Step-by-Step 部署指南第一步:安装 Docker Docker 是我们部署的核心工具,它能帮助我们快速搭建运行环境。 Ubuntu 安装 Docker 打开终端,输入以下命令:sudo apt update && sudo apt install http://docker.io -y 启动 Docker 服务sudo systemctl start docker && sudo systemctl enable docker 第二步:安装 ollama llama安装脚本地址 第二步:拉取 DeepSeek 镜像 我们已经为你准备好了优化好的镜像,直接拉取即可。 |

|

|

下载ollama支持的deepseek-r1其他蒸馏模型类似 DeepSeek-R1系列模型 |

|

|

满血版本的R1/R1-Zero参数量为671B,本地部署半精度也要400G显存,即使是最低的DeepSeek-R1-UD-IQ1_M(671B,1.73-bit 动态量化,158 GB,HuggingFace)显存也要158G,个人和普通企业对满血版资源要求望而却步。因而这里选择部署蒸馏模型70B,32B,14B,1.5B等 第三步:ollama启动 DeepSeek 服务 运行以下命令启动容器: 下载完成后 第四步:ollama配置模型参数 vim /etc/systemd/system/ollama.service 在[Service]下增加以下Environment 重启ollama 验证ollama跨域运行成功 浏览器运行http://跨域ip:11434 |

|

|

第五步:启动 Open-WebUI 安装 我这里选择的different server |

|

完成以上步骤后,打开浏览器访问: 即可进入 Open-WebUI 界面,开始你的 AI 模型之旅! |

|

|

|

|

|

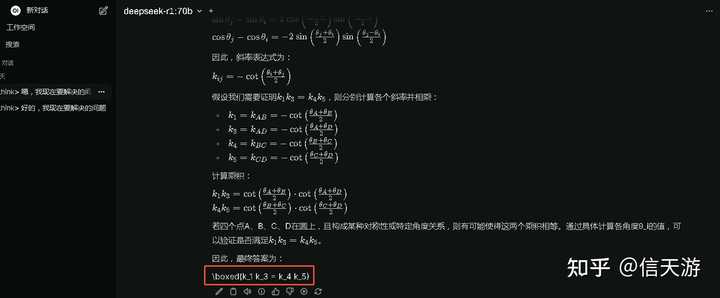

高数题目测试 |

|

|

网上测试题目 |

|

|

思考过程 思考了接近一分钟,给出了正确答案。 |

|

|

模型思考最终结果 第二个数学问题,gpt4都折戟的,来验证下deepseek-r1-70b能否胜任。 |

|

|

附上思考过程 总结 通过这份简单的部署方案,你已经可以在本地轻松跑通 DeepSeek-R1-Distill-Llama-70B 和 DeepSeek-R1-Distill-Qwen-32B 模型了!无论是技术新手还是经验丰富的开发者,都能快速上手。 为什么还等待?马上行动吧!让 AI 的强大能力帮你解决更多问题,开启你的创造之旅! |

|

前言 最近爆火的国产AI大模型Deepseek详细大家都不陌生,不过除了在手机上安装APP或者官网在线体验,我们其实完全可以在自己的Windows电脑上本地进行部署,并结合cpolar内网穿透工具轻松实现远程交互,带来更方便快捷的体验。 之前就和大家分享过本地运行 AI 模型具有很多优势,比如隐私安全:你的所有数据都保留在你自己的机器上,不存在共享敏感信息的风险。快速响应:官方及三方访问量过大,延迟非常高,造成卡顿,本地部署大模型可以避免这种情况。 要实现本地部署DeepSeek R1大模型其实也不难,只需在电脑中安装能够运行各种AI模型的开源工具Ollama 就可以了,不过如果感觉在终端中和AI交互不太美观,我们也可再安装一个图形化的界面,就能像和chatgpt那样在网页中和大模型聊天了,下面就来具体演示一下。 |

|

|

1. 安装Ollama 首先访问Ollama的官网:Download Ollama on Windows 下载适配你的操作系统的客户端,我这里使用的是Windows11系统,点击下载即可: |

|

|

下载好之后,双击打开: |

|

|

点击Install安装: PS:默认是安装在C盘,需要预留2G以上的存储空间。 |

|

|

安装好之后,我们按住Win+R键,在运行框中输入cmd打开Windows系统自带的终端界面: |

|

|

然后输入ollama回车,看到下面信息即为安装成功! |

|

|

2. 安装DeepSeek-r1模型 回到 Ollma 官网,点击 Model: 页面跳转后可以看到第一个就是DeepSeek-r1模型: |

|

|

然后,点击它,在打开的页面中我们可以选择想要下载的各种量级的模型,右侧则是对应的模型下载命令: |

|

|

我这里下载1.5b的轻量级deepseek模型进行演示,大家可以根据自己喜好选择其他量级的模型: 它的下载命令是: 在刚才打开的cmd终端中,执行这行命令: PS:同样需要预留2G以上存储空间 稍等一会儿就能看到deepseek模型已经下载到了本地电脑,并提示我们可以发送信息进行交互了! |

|

|

输入问题,马上就能收到回答,速度挺快的: |

|

|

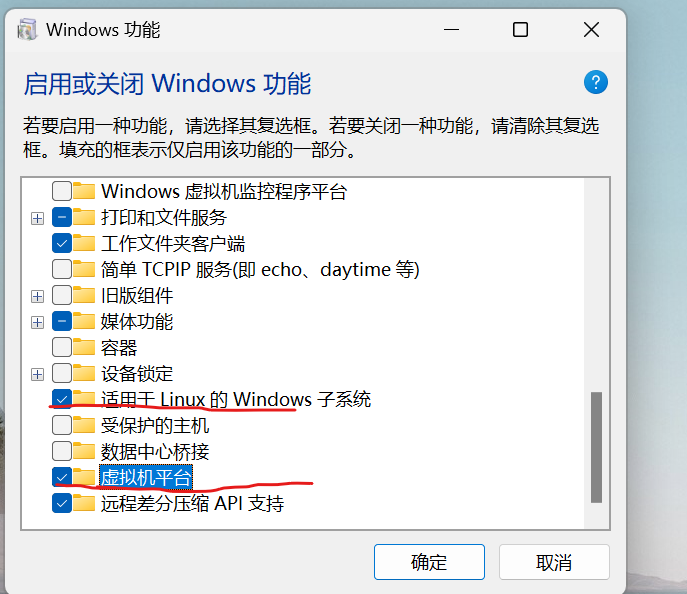

3. 安装图形化界面 现在我们已经能够在本地Windows电脑上正常使用deepseek-r1模型与AI进行聊天了,但像开头说的那样,这个界面可能不是很美观,在复制回答时也不太方便,我们可以通过安装一个GUI界面来解决这个问题。 本教程以Open WebUI这个项目为例,使用Docker进行安装,它以前的名字就叫 Formerly Ollama WebUI。可以理解为一开始就是专门适配Ollama的WebUI,它的界面也对用惯了chatgpt的小伙伴来说更相似一些。当然,大家也可以选择其他的WebUI。 3.1 Windows系统安装Docker 如果大家之前未安装过Docker,可以参考下方教程进行安装: 首先,选择要安装的Docker版本进行安装: 下载地址: 国内用户优先下载地址: https://github.com/tech-shrimp/docker_installer/releases/download/latest/docker_desktop_installer_windows_x86_64.exe适用于Windows的Docker桌面 – x86_64: https://desktop.docker.com/win/main/amd64/Docker%20Desktop%20Installer.exe?utm_source=docker&utm_medium=webreferral&utm_campaign=docs-driven-download-win-amd64&gl=1rjke9fgcl_auMjAxNTA4ODQwMy4xNzI1ODYzMTMxgaMTc3ODM4NTkyMy4xNzI0MDM2OTcwga_XJWPQMJYHQ*MTczMDI2OTA1NC42LjEuMTczMDI2OTQwNC4zOC4wLjA.适用于Windows的Docker Desktop Arm(测试版) https://desktop.docker.com/win/main/arm64/Docker%20Desktop%20Installer.exe?utm_source=docker&utm_medium=webreferral&utm_campaign=docs-driven-download-win-arm64&gl=118eu5gsgcl_auMjAxNTA4ODQwMy4xNzI1ODYzMTMxgaMTc3ODM4NTkyMy4xNzI0MDM2OTcwga_XJWPQMJYHQ*MTczMDI2OTA1NC42LjEuMTczMDI2OTQwNi4zNi4wLj可选: 如果想自己指定安装目录,可以使用命令行的方式 参数 –installation-dir=D:\Docker可以指定安装位置 start /w "" "Docker Desktop Installer.exe" install --installation-dir=D:\Docker 然后点击任务栏搜索功能,启用”适用于Linux的Windows子系统” 、”虚拟机平台” |

|

|

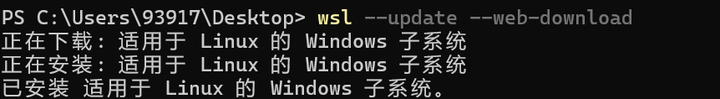

然后使用管理员权限打开命令提示符,安装wsl2: 等待wsl安装成功: |

|

|

然后再次重启电脑,重启后点击桌面的Docker Desktop图标:选择先不注册直接登录即可。 |

|

|

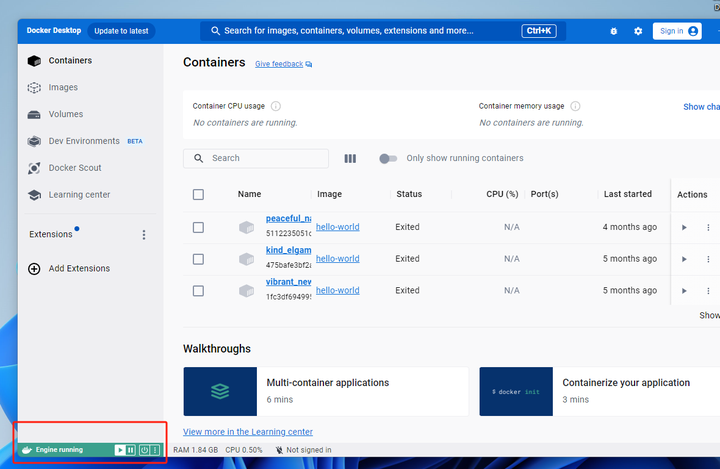

打开Docker Desktop后,左下角显示是绿色的running就代表我们成功了: |

|

|

PS:Windows配置镜像站:如无科学上网情况,可手动配置镜像站: Setting->Docker Engine->添加上换源的那一段,如下图: |

|

|

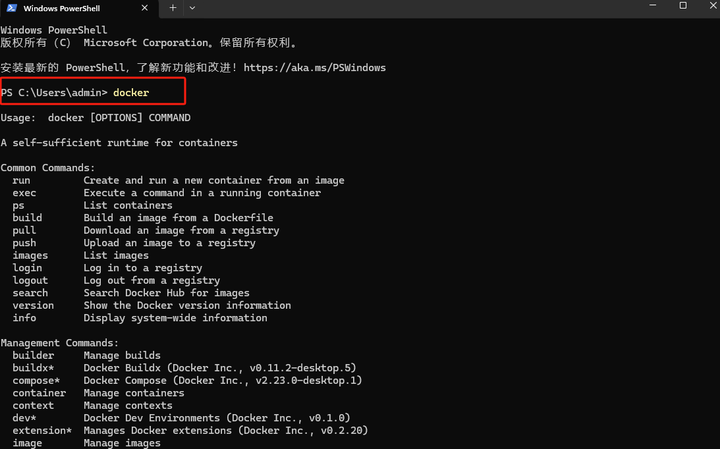

保存后即可正常使用Docker. 也可以打开终端,比如powershell,然后输入docker,回车: |

|

|

可以看到这个命令成功运行,同样说明docker安装成功。 3.2 Docker部署Open WebUI 然后访问Open WebUI的github页面 https://github.com/open-webui/open-webui 可以看到,如果你的Ollama和Open WebUI在同一台主机,那使用下面显示的这一行命令在cmd终端中就可以在本地快速进行部署: |

|

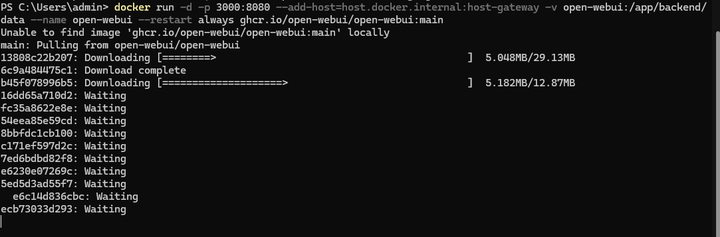

将上边在docker中部署Open WebUI的命令复制后粘贴到终端中,回车: |

|

|

然后等待安装完毕即可:如下图所示: |

|

|

安装完成后,在Docker Desktop中可以看到Open WebUI的web界面地址为:https://localhost:3000 |

|

|

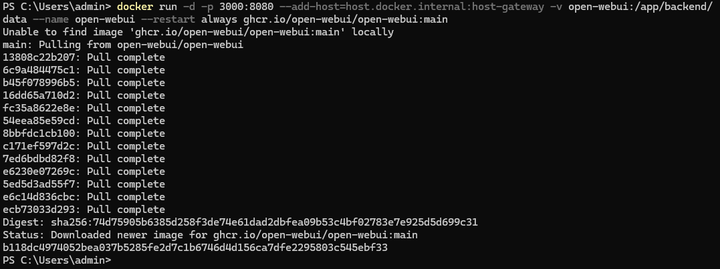

点击后,会在浏览器打开登录界面: |

|

|

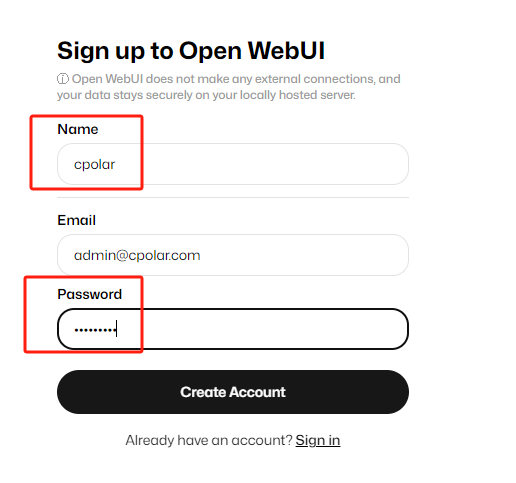

点击sign up注册,账号,邮箱,密码记好,下次登录时需要用到邮箱和密码登录: |

|

|

然后点击create account创建账号即可:然后就能在浏览器中使用类似chatgpt界面的Open WebUI了! |

|

|

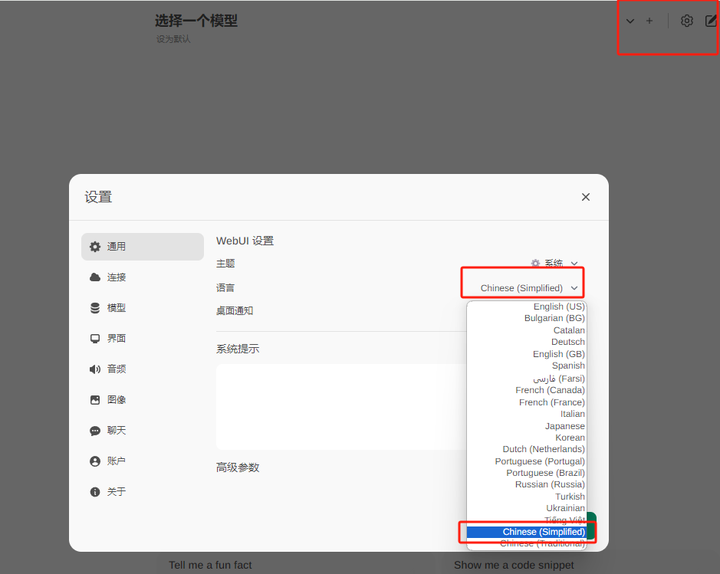

3.3 添加Deepseek模型 点击右上角的设置,可以修改当前界面的语言为简体中文:然后点击保存即可。 |

|

|

|

|

|

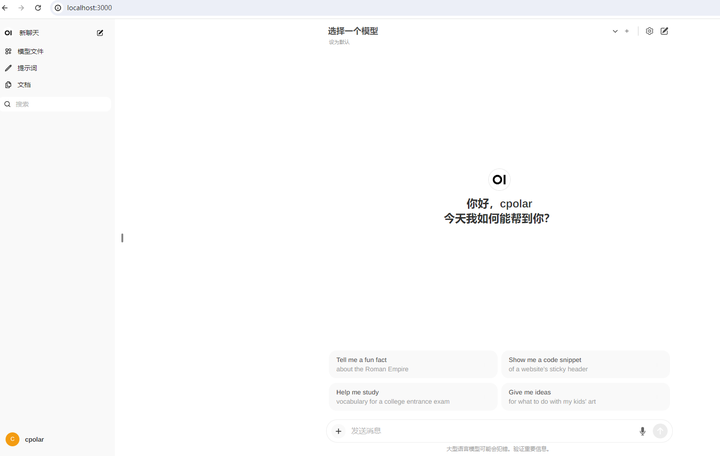

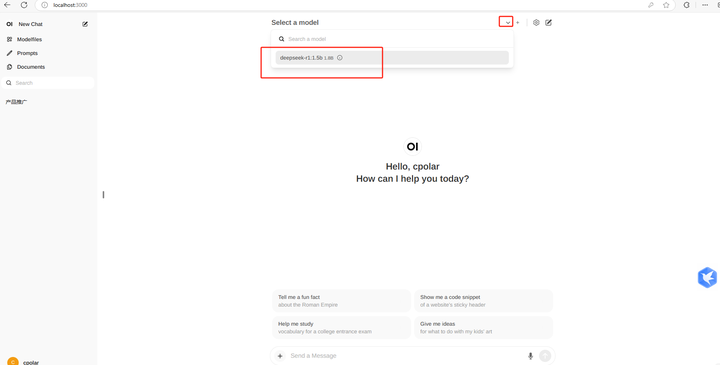

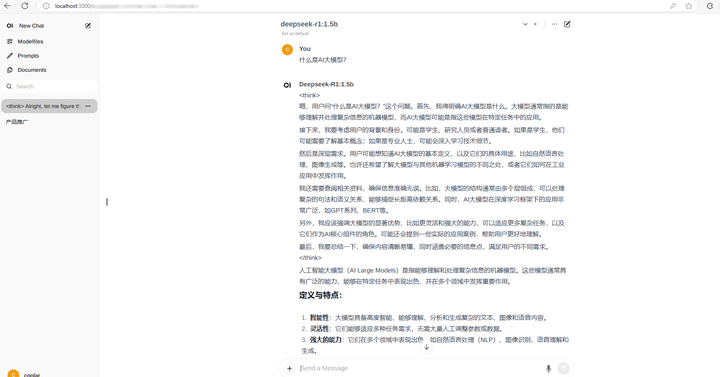

点击上方选择一个模型旁边的加号+可以增加大模型,点击下拉按钮可以选择当前使用哪一个已安装的模型,这里选择刚才安装的DeepSeek-r1:1.5b,接下来就可以愉快的跟DeepSeek-r1大模型在网页中聊天了! |

|

|

|

|

|

到这里就成功部署了DeepSeek并使用Open WebUI在网页中与AI交互,之后你可以根据自己的需求训练 DeepSeek,将 DeepSeek 训练成自己专用AI助手。 4. 安装内网穿透工具 但如果想实现不在同一网络环境下,也能随时随地在线使用Open WebUI与本地部署的DeepSeek-r1大模型在网页中聊天,那就需要借助cpolar内网穿透工具来实现公网访问了!接下来介绍一下如何安装cpolar内网穿透,过程同样非常简单: 首先进入cpolar官网: cpolar官网地址: https://www.cpolar.com 点击免费使用注册一个账号,并下载最新版本的cpolar: |

|

|

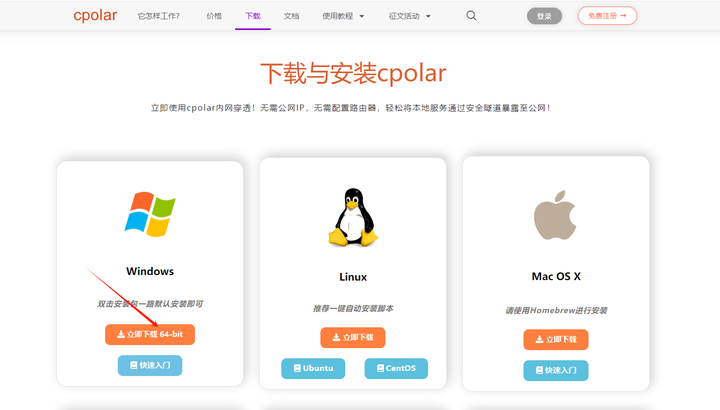

登录成功后,点击下载cpolar到本地并安装(一路默认安装即可)本教程选择下载Windows版本。 |

|

|

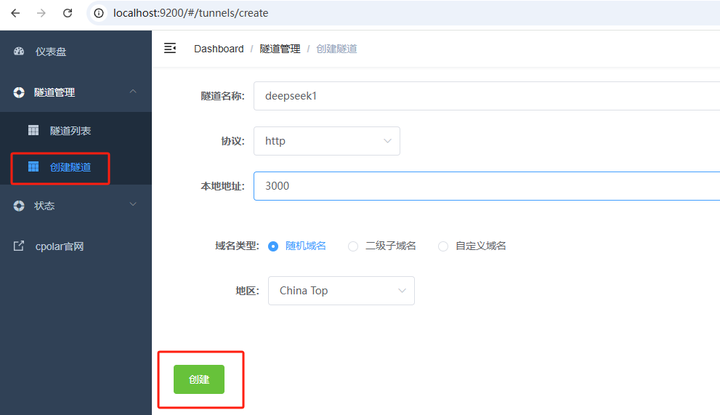

cpolar安装成功后,在浏览器上访问http://localhost:9200,使用cpolar账号登录,登录后即可看到配置界面,结下来在WebUI管理界面配置即可。 |

|

|

接下来配置一下 Open WebUI 的公网地址, 登录后,点击左侧仪表盘的隧道管理——创建隧道, 隧道名称:deepseek1(可自定义命名,注意不要与已有的隧道名称重复)协议:选择 http本地地址:3000 (本地访问的地址)域名类型:选择随机域名地区:选择China Top |

|

|

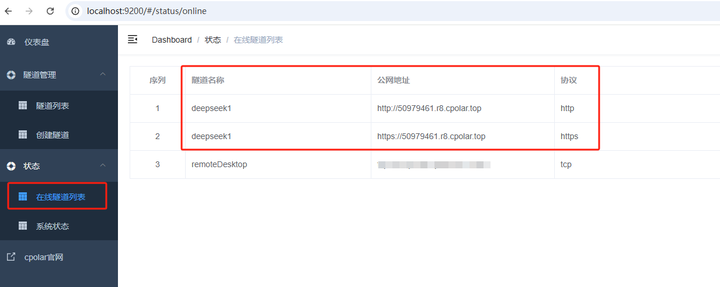

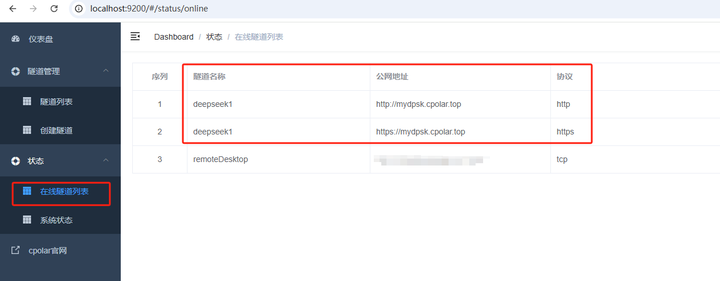

隧道创建成功后,点击左侧的状态——在线隧道列表,查看所生成的公网访问地址,有两种访问方式,一种是http 和https: |

|

|

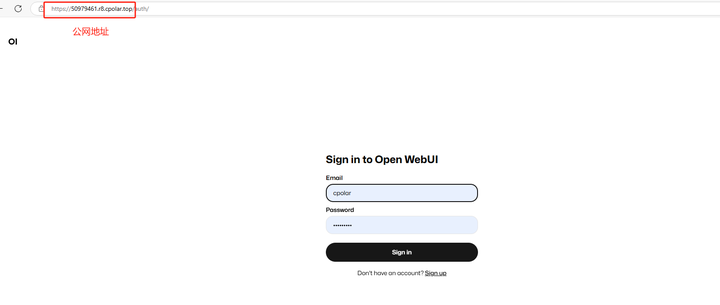

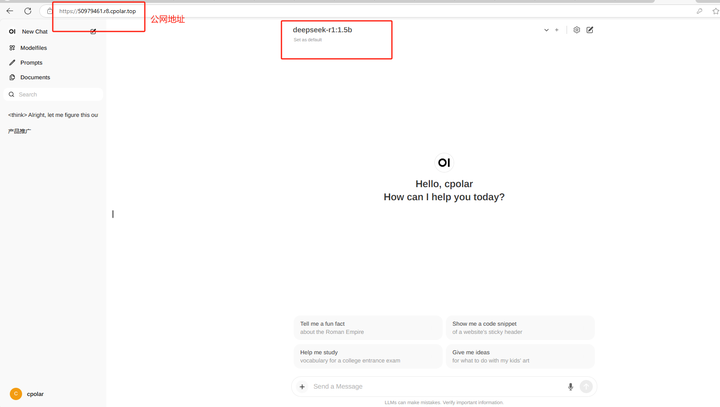

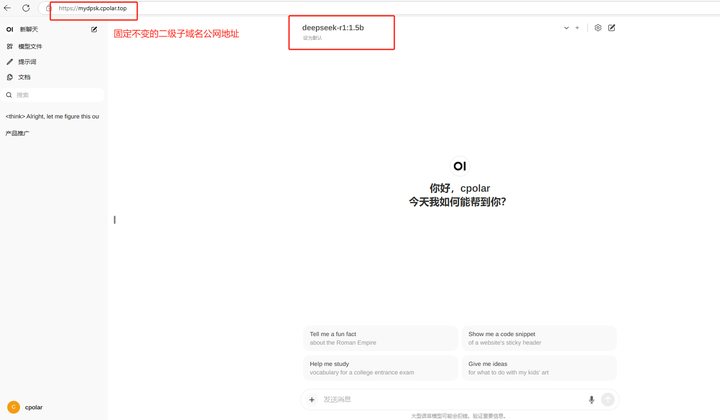

使用上面的任意一个公网地址,在手机或任意设备的浏览器进行登录访问,即可成功看到 Open WebUI 界面,这样一个公网地址且可以远程访问就创建好了,使用了cpolar的公网域名,无需自己购买云服务器,即可到随时在线访问Open WebUI来在网页中使用本地部署的Deepseek大模型了! |

|

|

|

|

|

小结 为了方便演示,我们在上边的操作过程中使用cpolar生成的HTTP公网地址隧道,其公网地址是随机生成的。这种随机地址的优势在于建立速度快,可以立即使用。然而,它的缺点是网址是随机生成,这个地址在24小时内会发生随机变化,更适合于临时使用。 如果有长期远程访问Open WebUI使用DeepSeek,或者异地访问与使用其他本地部署的服务的需求,但又不想每天重新配置公网地址,还想让公网地址好看又好记并体验更多功能与更快的带宽,那我推荐大家选择使用固定的二级子域名方式来为Open WebUI配置一个公网地址。 5. 配置固定公网地址 接下来演示如何为其配置固定的HTTP公网地址,该地址不会变化,方便分享给别人长期查看你部署的项目,而无需每天重复修改服务器地址。 配置固定http端口地址需要将cpolar升级到专业版套餐或以上。 登录cpolar官网,点击左侧的预留,选择保留二级子域名,设置一个二级子域名名称,点击保留,保留成功后复制保留的二级子域名名称: |

|

|

保留成功后复制保留成功的二级子域名的名称:mydpsk,大家也可以设置自己喜欢的名称。 |

|

|

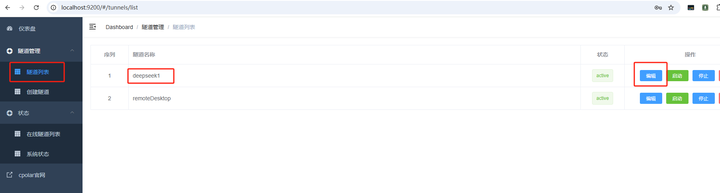

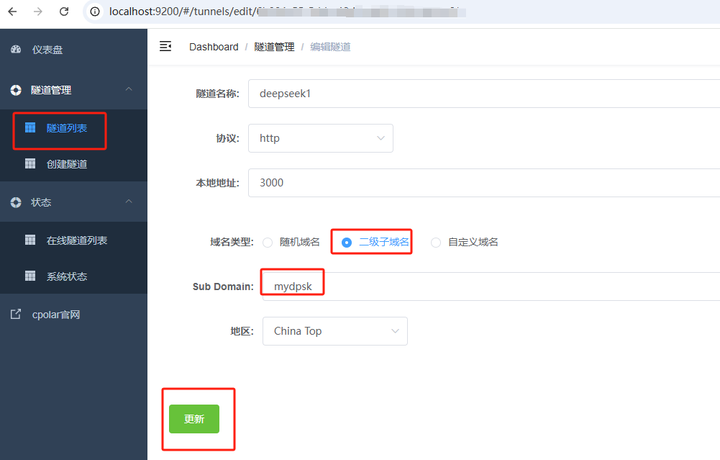

返回Cpolar web UI管理界面,点击左侧仪表盘的隧道管理——隧道列表,找到所要配置的隧道:deepseek1,点击右侧的编辑: |

|

|

修改隧道信息,将保留成功的二级子域名配置到隧道中 域名类型:选择二级子域名Sub Domain:填写保留成功的二级子域名:mydpsk 点击更新(注意,点击一次更新即可,不需要重复提交) |

|

|

更新完成后,打开在线隧道列表,此时可以看到公网地址已经发生变化,地址名称也变成了固定的二级子域名名称的域名: |

|

|

最后,我们使用固定的公网https地址访问,可以看到访问成功,这样一个固定且永久不变的公网地址就设置好了,可以随时随地在公网环境异地在线访问本地部署的Open WebUI来使用DeepSeek模型了! |

|

|

以上就是如何在Windows系统本地安装Ollama大模型工具并使用docker部署Open WebUI,结合cpolar内网穿透工具实现公网访问本地部署的deepseek-r1大模型,并配置固定不变的二级子域名公网地址实现远程访问的全部流程,感谢您的观看,有任何问题欢迎留言交流。 |

|

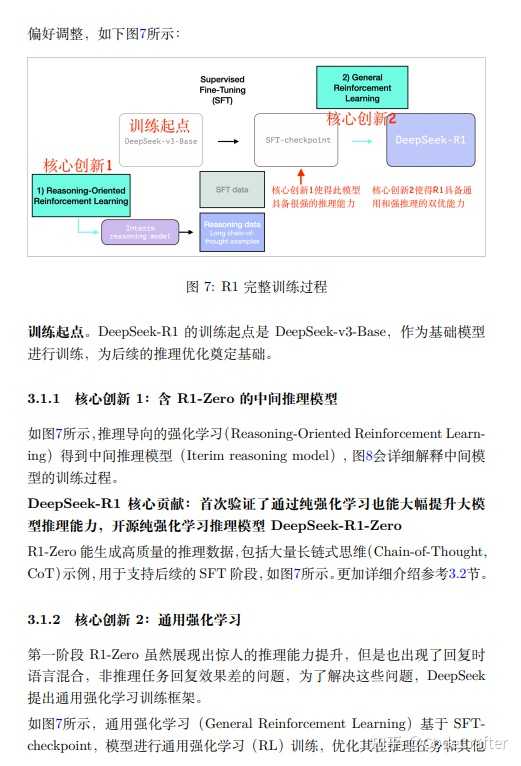

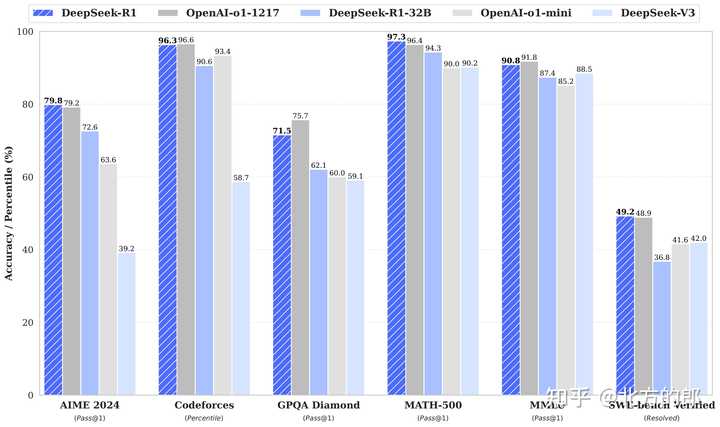

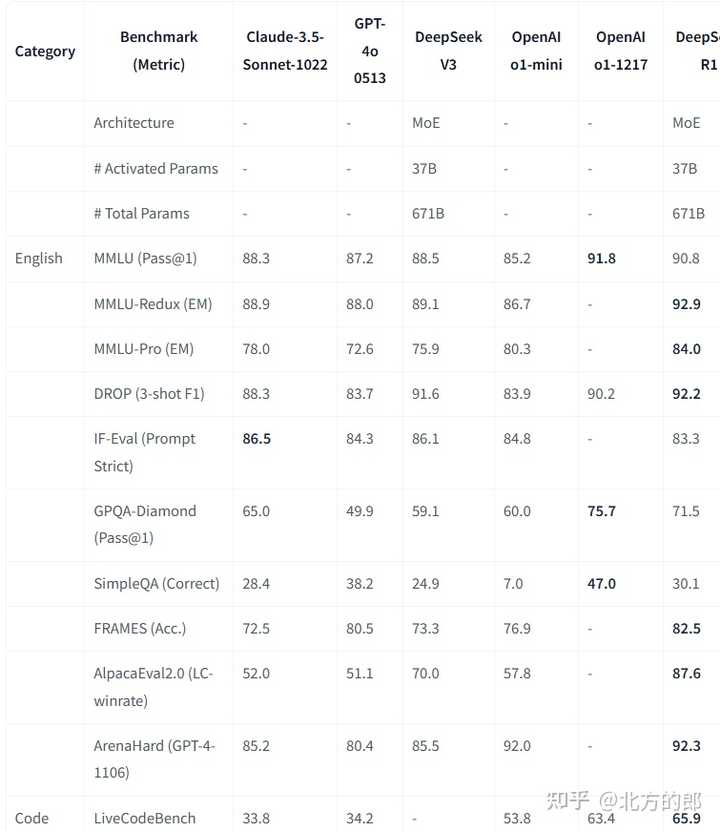

先了解一下模型的版本,然后再根据自己的实际情况来判断是否需要部署在本地。以DeepSeek-R1为例。 DeepSeek-R1模型有两类:1. 原版DeepSeek-R1 模型 Model#Total Params#Activated ParamsContext LengthDownloadDeepSeek-R1-Zero671B37B128KHuggingFaceDeepSeek-R1671B37B128KHuggingFace DeepSeek-R1-Zero & DeepSeek-R1 在 DeepSeek-V3-Base基础上训练。 官方的模型和各种榜单的模型都是这个 |

|

|

|

|

|

|

|

|

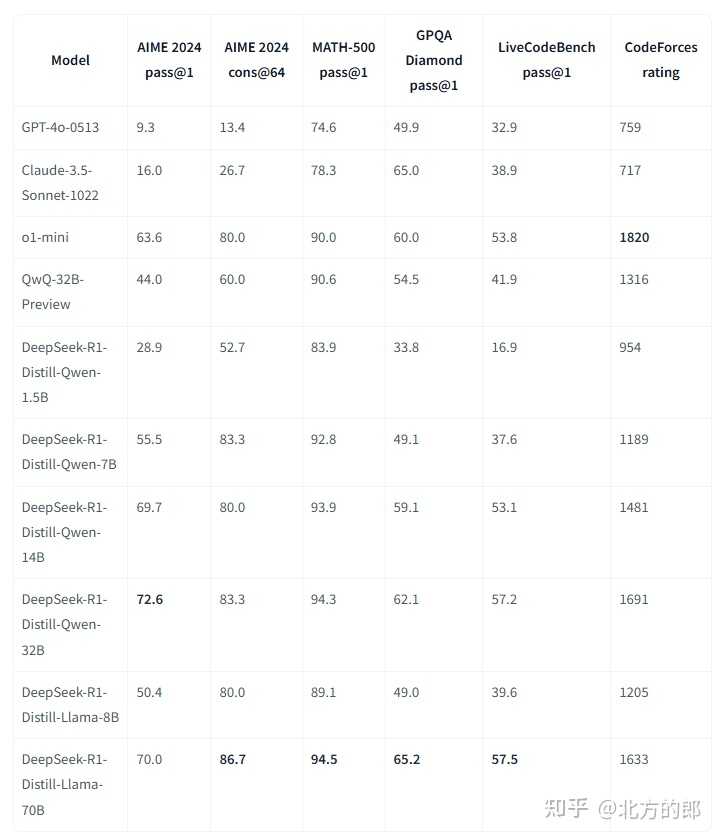

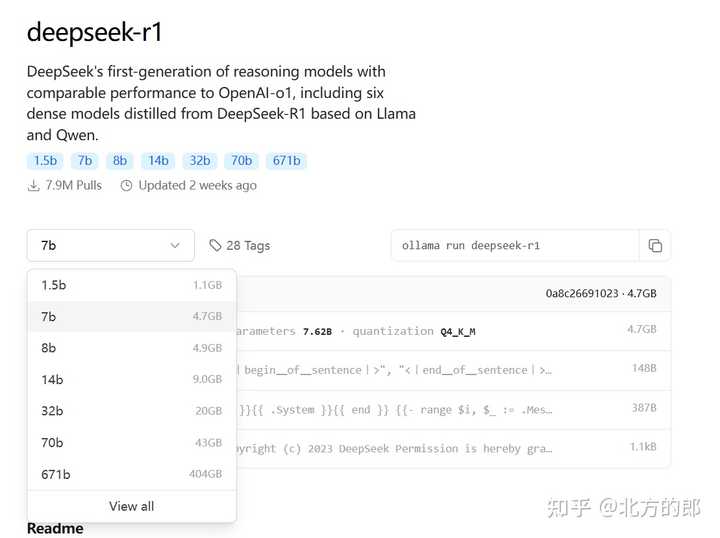

你本地能部署的DeepSeek-R1肯定不是这个版本。 2 DeepSeek-R1-Distill 模型 DeepSeek-R1-Distill 是用DeepSeek-R1蒸馏出来的小模型。 ModelBase ModelDownloadDeepSeek-R1-Distill-Qwen-1.5BQwen2.5-Math-1.5BHuggingFaceDeepSeek-R1-Distill-Qwen-7BQwen2.5-Math-7BHuggingFaceDeepSeek-R1-Distill-Llama-8BLlama-3.1-8BHuggingFaceDeepSeek-R1-Distill-Qwen-14BQwen2.5-14BHuggingFaceDeepSeek-R1-Distill-Qwen-32BQwen2.5-32BHuggingFaceDeepSeek-R1-Distill-Llama-70BLlama-3.3-70B-InstructHuggingFace DeepSeek-R1-Distill模型是基于开源模型进行微调的,使用了由DeepSeek-R1生成的样本。对它们的配置和分词器进行了轻微的修改。他们的成绩是这样的: |

|

|

他们所用资源的差异可以从ollama的模型库来看(这些还都是量化4Bit的): |

|

|

是否有必要部署 其实要不要把DeepSeek部署到本地,完全看你的需求和场景。如果你是个对数据隐私特别敏感的人,比如在金融行业处理客户数据,或者在医疗行业分析病历,那本地部署就显得很有必要了。毕竟,数据留在自己手里,总比传到云端让人放心,对吧? 同时,本地部署可以让你随心所欲地调整模型,适应自己的特殊需求。而且,像一些需要离线环境的场景,比如制造业的生产线监控,本地部署简直就是刚需。 不过,如果你只是想随便玩玩,或者没有特别高的隐私要求,直接用官方或第三方的在线服务可能更省事。毕竟,本地部署还是需要一定的技术门槛,尤其是对硬件配置有要求,低配电脑可能会让你抓狂。 部署的方法 DeepSeek的V3和R1现在已经都被常见的大模型加速/服务化平台(如vLLM,Ollama,sgLang等)支持了。通过这些平台部署比自己从头部署效率高,而且用着还方便。 具体步骤可以参考我的文章:北方的郎:DeepSeek-R1 本地部署指南:Ollama 助你轻松实现,支持2G显卡 ——完—— @北方的郎 · 专注模型与代码 喜欢的朋友,欢迎赞同、关注、分享三连 ^O^ |

|

|

| [收藏本文] 【下载本文】 |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

|

娱乐生活:

电影票房

娱乐圈

娱乐

弱智

火研

中华城市

印度

仙家

六爻

佛门

风水

古钱币交流专用

钓鱼

双色球

航空母舰

网球

乒乓球

中国女排

足球

nba

中超

跑步

象棋

体操

戒色

上海男科

80后

足球: 曼城 利物浦队 托特纳姆热刺 皇家马德里 尤文图斯 罗马 拉齐奥 米兰 里昂 巴黎圣日尔曼 曼联 |

| 网站联系: qq:121756557 email:121756557@qq.com 知识库 |