| |

|

| 知识库 -> 科技 -> 为什么 LLM 仅预测下一词,就能「涌现」出高级能力? -> 正文阅读 |

|

|

[科技]为什么 LLM 仅预测下一词,就能「涌现」出高级能力? |

| [收藏本文] 【下载本文】 |

|

研究领域对此有何解释? |

|

研究界对这事儿已经吵了好几年,我知道的几个主流的解释思路,可以给你整理下 先说个最有说服力的角度——信息论视角。有个叫 Hutter Prize 的比赛,核心理念就是"谁能把文本压缩得更小,谁就更聪明"。听起来挺奇怪的对吧?但仔细想想,要把海量文本高效压缩,你必须找到里面的规律和模式。 Marcus Hutter 提出的理论是:Solomonoff 的通用预测器本质上等价于 Kolmogorov 的通用最佳压缩器。白话说就是,预测哪个字最可能出现,和找到最短的编码方式,在数学上是同一回事。所以当模型学会预测语言分布时,它实际上在学习生成这些语言的世界结构。 这个解释在理论和实践上都站得住脚,因为语言本身就是人类思维的浓缩版嘛,里面编码了逻辑、因果、社会规范、物理常识……模型要准确预测"球落地后会____",就得理解重力;要预测对话回复,就得理解社交意图。压缩语言分布的过程,逼着模型去构建一个内部的世界模型。 而OpenAI 在 2020 年发了篇 Scaling Laws 的论文,发现模型损失和参数量、数据量之间有稳定的幂律关系,跨越七个数量级都成立。后来 DeepMind 用 Chinchilla 修正了这个结论,说其实模型参数和训练 token 要等比例增长才最优,大概每个参数需要 20 个 token。 https://arxiv.org/abs/2001.08361arxiv.org/abs/2001.08361 Jason Wei 等人在 2022 年发表的论文《Emergent Abilities of Large Language Models》定义了涌现能力:在小型模型中不存在、但在大型模型中突然出现的能力,这些能力无法通过简单外推小模型性能来预测 https://arxiv.org/abs/2206.07682arxiv.org/abs/2206.07682 而斯坦福 2023 年的论文《Are Emergent Abilities of Large Language Models a Mirage?》对此提出质疑,认为涌现可能是评估指标(非线性或不连续指标)造成的假象,而非模型行为的根本相变 https://arxiv.org/abs/2304.15004arxiv.org/abs/2304.15004 说涌现可能是"海市蜃楼"——不是模型本身突变了,而是我们用的评估指标太离散,把连续变化看成了突变。比如你用准确率来衡量,40% 和 60% 看着差不多,但换成 F1 分数可能就是质的飞跃。 而2025 年最新的综述还在讨论这个问题:涌现到底是真实的相变,还是测量方式的假象? https://arxiv.org/abs/2503.05788arxiv.org/abs/2503.05788 所以到底这个是不是“涌现”还没有没盖棺定论,但有个现象倒是真实的——Grokking。就是神经网络先过拟合训练数据很久,然后突然泛化能力暴涨。研究发现这确实可以用临界指数描述,像真正的一阶相变。所以某种程度上,"涌现"这个比喻可能不完全是空话。 除了肯定的,我还能再给你找两个不同角度批评的: Bender 等人认为LLM 只是在概率上将词和句子链接在一起,而不考虑意义,因此被称为"随机鹦鹉" https://dl.acm.org/doi/10.1145/3442188.3445922dl.acm.org/doi/10.1145/3442188.3445922 这篇论文引发了巨大争议,好像闹得挺大,Gebru 被 Google 要求撤回论文或删除 Google 员工的名字,最后被还谷歌辞退了。 还有就是 Gary Marcus 这是老批评家了,它从神经网络开始就说神经网络无法可靠地外推和进行形式推理,还有深度学习什么的都一直在说 https://arxiv.org/abs/1801.00631arxiv.org/abs/1801.00631 而且他25年2月在(CACM)的官方采访中 Marcus 还详细谈了他对 LLM 技术局限性的看法,以及为什么他认为规模定律正在遇到收益递减的问题。 https://cacm.acm.org/opinion/not-on-the-best-path/cacm.acm.org/opinion/not-on-the-best-path/ 所以我觉得你说的为什么能涌现,答案还是未知的。因为这个领域现在就是这么个状态——有一堆有意思的理论,每个都能解释一部分现象,但谁也不敢说自己完全理解了,谁也不敢说自己是对的,毕竟才研究了几年。 我们的确看到了大语言模型的能力,涌现相变这个概念很吸引人,但是就像上面论文说的可能部分是测量假象,需要更严格的数学定义。 也许等过两年再看,说不定就清楚多了。 送礼物 还没有人送礼物,鼓励一下作者吧 |

|

这件事其实困扰了学术界和工业界很久,哪怕是现在,OpenAI 内部也没人敢拍着胸脯说自己完全搞懂了其中的全部机理。 从最早的 SVM、逻辑回归,到后来的 LSTM、BERT,再到现在的 GPT 系列,眼看着模型参数从几万涨到几万亿。你可以去翻一个记录了各种技术变迁的 大模型237篇必读论文合集,会发现一个有趣的现象:刚开始大家都觉得扯淡。一个做文本接龙的玩意,怎么就能写代码、做推理、甚至还能给你讲笑话?这不符合我们对“智能”二字的传统认知。我们以前觉得智能应该是结构化的,是有明确逻辑符号的,是类似数理逻辑推导那样的东西。 但现实给了我们一记响亮的耳光。 只要参数够大,数据够多,算力管饱,单单预测下一个词,就是能涌现出高级能力。 这背后的逻辑,其实非常硬核。我把这些年做算法、读论文、跟同行通宵debug聊出来的东西,揉碎了跟大伙说一说。别指望听到什么瑞士军刀之类的比喻,那些都是骗外行的,咱们直接看本质。 压缩即智能 这是目前最硬核的一个解释,也是我很推崇的一个观点。OpenAI 的 Ilya Sutskever 以前经常挂在嘴边。 你得这么想,预测下一个词,本质上是在对数据进行 无损压缩。 想象一下,你要把整个互联网的文本数据压缩到一个模型里。这个模型的大小(参数量)远小于数据本身的大小。为了能准确还原(预测)出这些数据,模型必须被迫去学习数据内部的 规律 和 逻辑。 如果我让你背诵圆周率,你死记硬背能背个几百位。但如果我让你预测圆周率的下一位,你光靠死记硬背是不行的,你必须掌握圆周率的计算公式。一旦你掌握了公式,你就能无限预测下去。 文本也是一样。 比如我在一段话里写:张三把那把沉重的钥匙插进锁孔,用力一扭,只听咔嚓一声,门__。 你想预测这个空是 开 了。 这看起来简单。但模型要做到大概率预测出 开 这个字,它需要学到什么? 它得学会物理常识:钥匙插进锁孔扭动通常会导致锁打开。 它得学会语言习惯:咔嚓一声通常是机械结构动作的声音。 它得学会因果关系:扭动是因,门开是果。 这还只是最简单的例子。如果是一本侦探小说呢? 警长看着地上的烟灰,突然想起来,死者生前从不抽烟,唯一的来访者是那个左撇子的__。 要预测这里填 嫌疑人 或者具体的名字,模型必须具备 长期记忆,必须具备 推理能力,必须理解 反常即为妖 的逻辑。它得知道不抽烟的人地上有烟灰意味着有其他人来过,它得结合前文提到的左撇子特征去定位具体的人。 为了把这个 下一个词 预测准,模型被逼得没办法,只能去 理解 整个世界的运作规律。它不是想理解,它是为了降低预测错误率(Loss),被迫 演化出了理解能力。 因为如果不理解,它就压缩不了这么多信息,它的预测准确率就上不去。 所以在海量数据的训练下,预测下一个词,等价于学习生成这些数据的 世界模型。 我们以前做算法,总想着给模型设计各种特征,告诉它这是主语,这是谓语,这是因果关系。现在发现,根本不需要。你只要给它足够难的预测任务,它自己会在数千亿个参数里,构建出一种我们人类目前还看不懂,但确实有效的特征表示。 这种表示,比我们人工设计的要高维得多,也精细得多。 说到这,得提点稍微枯燥但很本质的东西。 语言模型本质上是在学习一个高维空间中的概率分布。 我们人类的语言、逻辑、知识,在这个高维空间里,不是杂乱无章的,而是分布在某些特定的 流形(Manifold)上。 以前的词向量,比如 Word2Vec,比较简单,它能学到 国王 和 男人 的距离,这就好比 女王 和 女人 的距离。这是一种简单的线性关系。 现在的 LLM,参数量巨大,它构建的这个语义空间非常复杂且稠密。 当你输入一段 prompt 的时候,你其实是在这个高维空间里确定了一个起点和方向。模型预测下一个词,就是在这个流形上沿着概率密度最高的路径走一步。这听起来很玄,其实底层全是矩阵运算。如果你对线性变换或空间映射感觉云里雾里的很抽象,可以去看下 3Blue1Brown的线性代数笔记.pdf,它能帮你建立起直观的几何直觉,让你明白数据是如何在数学层面被压缩和理解的。 神奇的地方在于,这个流形结构,竟然把逻辑推理这种抽象能力也编码进去了。 有研究发现,当你让模型做数学题或者逻辑推理的时候,它内部的神经元激活模式,和它处理普通文本时是不一样的。它好像在那个高维空间里,找到了一条专门处理 逻辑变换 的通道。 涌现 这种现象,很可能就是当参数量达到一定规模后,这个高维流形足够连续、足够平滑,使得模型可以从一个概念平滑地游走到另一个概念,哪怕这两个概念在训练数据里从来没有直接挨在一起出现过。 这就是 泛化。 以前的小模型,流形是破碎的,全是坑坑洼洼,走两步就掉坑里了(输出乱码或废话)。大模型把这些坑填平了,把断路修通了。 我之前在项目里遇到过一个情况,我们用一个小模型去微调,教它写 SQL 语句。效果很差,稍微复杂点的嵌套查询就挂。后来换了个基座模型,参数量大了十倍,甚至没怎么专门教,它自己就能写出非常复杂的 join 查询。 为什么? 因为在大模型的语义空间里,自然语言的逻辑 和 SQL 代码的逻辑 被映射到了相近的区域。它理解了 查询 这个概念的本质,而不仅仅是记住了 select * from table 这种死板的语法。 这种 概念层面的对齐,是涌现高级能力的基础。 做工程的都知道 Scaling Laws。简单说就是,算力、数据、参数量,这三者指数级增加,模型的性能就会线性增长。 但这里有个 相变(Phase Transition) 的问题。要让这种相变发生,工程上的挑战是巨大的。你去一些看大厂在落地时关注的细节,比如可以去看下 字节大模型算法岗面试手册 里写的, 就能体会到,像这种从显存优化到分布式训练的坑,再到推理加速——这些“脏活累活”才是让 Scaling Laws 真正生效的幕后功臣。 很多能力,不是线性增长的。在模型很小的时候,它完全不会做加法。参数增加一点,它还是不会。直到参数突破某个临界值,它的加法能力突然从 0 跳到了 100。 这就像烧开水。0 度到 99 度,水都是液态,看起来没什么变化。到了 100 度,突然变成了气态。 对于 LLM 来说,预测下一个词的任务,在低算力下,模型主要靠 统计共现。比如看到 人工 就接 智能,看到 这 就接 是。这完全是浅层的统计规律。 但当模型足够大,它发现光靠统计共现已经没法进一步降低 Loss 了。因为很多文本是需要深层逻辑才能预测准的。 这时候,模型内部可能发生了某种 相变。它开始从 记忆模式 切换到 推理模式。 有篇很有意思的论文讲 Grokking(顿悟)现象。模型在训练集上已经过拟合了,准确率 100% 了,这时候继续训练,验证集准确率本来是不动的,突然在某个时间点,验证集准确率飙升。 这意味着模型抛弃了 死记硬背 的解法,突然找到了 通解(General Solution)。 在预测下一个词这个任务的逼迫下,大模型被迫去寻找通解。因为数据量太大了,它根本背不下来所有组合。为了生存(降低 Loss),它必须学会推理算法。 这就像老师让你做一万道数学题。你脑子容量有限,背不下来每道题的答案。你最后被逼得没办法,只能学会了微积分公式。一旦学会了公式,你就不需要背答案了,而且你具备了做新题的能力。 这就是涌现的本质:算法的内化。 有一个点很多人容易忽略。现在的 LLM 之所以逻辑能力强,很大程度上是因为训练数据里包含了海量的 代码。 代码和自然语言不一样。代码是严谨的逻辑链条。 if A then B else C。这种结构在代码里是绝对不能错的。缺少一个括号,程序就跑不通。 预测代码的下一个 token,比预测自然语言要难得多,也硬核得多。 在预测代码的过程中,模型被迫学会了 状态跟踪(State Tracking)。比如它得记住 100 行前定义的变量 x 是什么类型,在第 101 行调用的时候才能预测对。 这种 长距离的依赖关系 和 严格的逻辑执行 能力,被模型学到后,迁移到了自然语言任务上。 所以你会发现,现在的模型写作文理特别清晰,第一点、第二点、第三点,逻辑严丝合缝。这很可能就是从代码里学来的 思维链(Chain of Thought)能力。 我有个做大模型预训练的朋友跟我聊过,他们在训练数据里剔除掉代码后,模型的推理能力出现了肉眼可见的下降。这就反向证明了,预测代码的 next token,是构建高级逻辑能力的关键一环。 我们再换个角度。 我们可以把 LLM 看作是一个巨大的 贝叶斯推理机。 每一次预测下一个词,其实都是在做一次贝叶斯更新。 P(Next Word | Context)。 这个 Context(上下文),包含了你给它的 Prompt,也包含了它自己刚刚生成的词。 随着生成的词越来越多,Context 包含的信息量就越大,对后续内容的约束就越强。 人类思考问题的过程,其实也是类似的。 你想想你写代码或者写文章的时候。你心里有个模糊的想法(意图)。你写下第一个字。这个字会限制你第二个字的选择。写完第一句,你必须在第一句的基础上写第二句。 你的思想在文字的生成过程中逐渐成型。 很多时候,我们自己都不知道自己下一句要具体说什么,直到我们把上一句说完。语言不仅仅是思想的载体,语言本身就是思想的过程。 LLM 完美地模拟了这个过程。 它不需要预先规划好整个宏大叙事。它只需要在每一步,基于当前的上下文,做出最合理的推断。当每一步都走得合理时,整体看下来,就涌现出了宏大的逻辑和智慧。 这有点像生物进化。每一步变异和选择都只是为了当下的生存,没有长远规划。但经过亿万年的迭代,竟然涌现出了人类大脑这么复杂的结构。 Next Token Prediction,就是进化的选择压力。Loss Function,就是自然选择的剪刀。 还有个问题,为什么是文本预测?为什么图像预测没有这么明显的逻辑涌现? 因为人类的智慧,绝大部分都浓缩在文本里。 文字是人类思维的高维投影。我们几千年的历史、科学、哲学、情感,都编码在文字里了。 图像虽然信息量大,但它是 感知 层面的。一只猫的图片,像素点之间更多是空间相关性。 而文字,是 符号 层面的。文字符号之间,充满了 逻辑、因果、抽象 关系。 预测文本,本质上是在学习人类的 思维方式。 你在训练模型预测 苏格拉底是人,所有人都有一死,所以苏格拉底____。 模型要填 会死。这不仅仅是词语接龙,这是三段论逻辑。 互联网上的文本数据,包含了人类所有的三段论、归纳法、演绎法、反证法。模型把这些都学去了。 所以,与其说模型涌现了智能,不如说模型 复刻 了人类群体智慧的思维模式。它是一面镜子,反射的是全人类在互联网上留下的思维痕迹。 前段时间我们搞了个运维机器人的项目。以前的方法是写一大堆正则匹配规则,去提取 Log 里的错误信息。累死人,而且一旦报错格式变了就失效。 后来我们试着用 LLM。 我们把报错的那一段 Log 扔给它,让它预测接下来的分析。 注意,我们没有专门教它怎么修服务器。 但是,模型在预训练阶段,看过 StackOverflow,看过 GitHub 上的 issue 讨论,看过各种技术博客。 当它看到一段特定的 Java 堆栈溢出报错时,它预测下一个词的概率分布里,自动浮现出了 内存泄漏、HashMap、死循环 这些概念。 它给出的建议是:检查一下代码里是不是在遍历 Map 的时候进行了删除操作。 这真的是惊掉下巴。它不仅仅是匹配到了错误,它理解了这个错误背后的 代码逻辑。 它之所以能做到,是因为在它的训练数据里,无数个程序员在预测下一个词的时候,把 报错 和 成因 关联起来了。模型把这种关联压缩进了参数里。 当我们输入报错,模型就在它那高维的语义空间里,顺着概率流形,找到了成因所在的区域。 很多人觉得,仅仅预测下一个词,这也太简单了吧?智能怎么可能这么简单? 这种直觉是错的。 我们太低估 预测 这个任务的难度了。 在一个开放的世界里,实现完美的预测,等于全知全能。 你想想,如果我要完美预测明天的股票价格(这也是一种时序数据,类似于 Next Token),我需要知道什么? 我需要知道全球的政治局势、经济政策、公司财报、甚至大众的心理状态。 任何一个信息的缺失,都会导致预测的不完美。 所以,追求极致的预测准确率,就是在这个过程中倒逼模型去建模整个世界。 LLM 现在的能力还远没有到顶。现在的 Loss 还没有降到 0(也不可能降到 0,因为语言有内在的随机性),但还有很大的下降空间。 只要 Loss 还能降,模型对世界的理解就还能更深。 虽然我是做技术的,但看着这玩意儿一天天变强,心里也犯嘀咕。 我们是不是无意中触碰到了智慧的本质? 也许人类大脑的工作方式,在底层机制上,真的就是一个不断进行 Next Token Prediction 的生物神经网络? 我们听到一句话,大脑自动预测下一句。我们看到一个动作,大脑自动预测后果。 那种所谓的 灵感、顿悟、意识,可能只是大规模神经网络在处理复杂预测任务时,涌现出来的高层宏观现象。 如果真的是这样,那我们现在走的这条路,可能真的就是通往 AGI(通用人工智能)的康庄大道。 当然,现在还有很多问题。幻觉问题、逻辑一致性问题、长窗口记忆问题。 但这些更像是工程问题,而不是原理上的死胡同。 所以为什么预测下一个词能涌现智能? 压缩即理解:为了在海量数据上实现高准确率的预测,模型被迫学会了数据背后的生成规律(也就是世界知识和逻辑)。高维语义空间:模型构建了一个包含了逻辑、因果、概念的稠密流形结构,推理变成了在这个空间里的路径游走。Scaling Laws 与相变:量变引起质变,参数量大到一定程度,模型从统计记忆转向了算法推演。代码数据的加持:代码训练增强了模型的严谨逻辑和长程依赖能力。文本的特殊性:文本是人类思维的高保真投影,学文本就是学思维。 这事儿没什么玄学的,全是数学和算力堆出来的奇迹。但正是因为是数学,才让人觉得更震撼。因为这意味着,智能是可以被计算的,是可以被我们亲手制造出来的。 我们这代工程师,有幸见证甚至参与这个过程,说实话挺带劲的。 不管未来这东西会发展成什么样,至少现在,别把它当成一个简单的 自动补全工具。它是一个正在努力通过预测下一个字,来试图理解我们这个嘈杂、混乱但又充满逻辑的世界的 庞然大物。 送礼物 还没有人送礼物,鼓励一下作者吧 |

|

泻药。 首先要纠正一个巨大的误区,也是这个问题里最大的陷阱:预测下一个词这个动作,并不是目的,它是手段,它是那个无比残酷的损失函数Cross Entropy Loss强加给模型的紧箍咒。 我们要把时间拨回到2023年,那时候大家还在争论GPT到底有没有意识。现在回头看,那是个很初级的阶段。现在的顶级闭源模型,哪怕是开源界的SOTA,它们的训练目标依然包含了Next Token Prediction。为什么?因为这个任务足够难。 你要想清楚一件事,当模型面对海量互联网数据,要精准预测下一个字是什么的时候,它面临的是一个什么级别的信息压缩挑战。 比如说,我给你一句代码:public static void,你不管是人还是AI,你大概率知道后面跟的是main。这叫浅层语法记忆。这种能力,你拿个几百万参数的小模型就能做,根本不需要涌现。 但是,如果前面是几千字的物理论文推导,最后一句是因此,我们可以得出结论:这个时候,你要预测下一个词,你需要什么?你需要的不是概率统计,你需要的是对这几千字物理逻辑的完整理解和运算。如果模型不懂物理,它预测这个词的准确率也就是Loss就不可能降下来。 压缩即智能。这是Illya当年还在OpenAI的时候经常挂在嘴边的教训,现在看来越来越像是真理。模型为了在预测下一个词这个变态难度的考试里拿高分,它被迫在自己的神经网络权重里,构建了一套世界模型。它必须学会逻辑推理,必须学会因果关系,必须学会情感分析,否则它就无法在复杂的上下文中,把那个Loss降到极致。 所以,涌现不是魔法,涌现是模型为了偷懒而进化出的高级压缩算法。它发现,与其死记硬背每一句话,不如学会生成这句话背后的逻辑。学会了逻辑,预测下一个词就从背诵变成了推导。这就是所谓的高级能力。 咱们这几年在做训练的时候,有个非常明显的体感。当你把参数量堆到一定程度,比如过了100B,数据质量清洗得足够干净,加入了大量的合成推理数据(Synthetic Data)之后,你会发现Loss曲线会出现一个诡异的拐点。 在拐点之前,模型是在拟合表面规律。拐点之后,模型好像突然开窍了,这就是著名的Grokking现象。现在的技术栈里,我们已经能比较好地控制这个Grokking发生的时间点了。我们发现在那个瞬间,模型内部的电路发生重组,它不再是用统计相关性来输出,而是调用了类似程序执行的模块。 举个具体的场景,这是我去年在优化一个金融垂类模型时遇到的真事。 当时我们在搞一个复杂的并购案推演。输入是两家公司过去五年的几千页财报和法律文书,任务是预测如果并购发生,潜在的监管风险点在哪里。 如果你用的是那种没经过强化学习对齐的旧时代模型,它预测出来的下一个词,往往是废话。比如它会预测根据相关法律法规这种万金油。为什么?因为在概率上,这句话接在任何法律问题后面都没错,Loss很低,模型很鸡贼,它选择了安全牌。 但是,当我们引入了Process Reward Model(过程奖励模型),也就是现在推理系模型标配的思维链监督之后,强迫它进行深层思考。这时候,它预测的下一个词变了。它开始输出考虑到A公司在2025年第三季度的反垄断罚款记录...。 注意,A公司这个词的预测概率,在原始分布里可能极低。但模型为什么要输出它?因为它在内部进行了几百步的隐式推理,它模拟了并购后的市场占有率计算,它检索了记忆中的反垄断法条文,它把这两者做了一个碰撞,得出了风险极高的结论,而要表达这个结论,它必须输出A公司这个具体的实体。 这就是我想说的核心观点:预测下一个词,实际上是在对未来进行蒙特卡洛树搜索后的坍缩。 你看到的输出是一个词,但模型在输出这个词之前,在它那庞大的高维向量空间里,可能已经预演了无数种可能性的分支,最后选择了一条最符合逻辑一致性的路径。现在的模型,特别是经过RLHF(人类反馈强化学习)和RLAIF(AI反馈强化学习)这几轮打磨后的版本,它们预测的不是词,它们预测的是最优解的路径。 很多搞传统NLP的人,到现在还转不过弯来,觉得这还是N-Gram的变种。这简直是胡扯。N-Gram是看过去两个词猜这一个词,现在的LLM是看过去十万个Token,结合它几万亿参数里压缩的全人类知识,在做一个复杂的函数映射。 这事儿还得从Transformer的架构说起,虽说现在,Transformer的变种层出不穷,什么Mamba、Jamba这种SSM架构混合体也占了一席之地,但Attention机制的核心地位没变。Attention让模型可以跨越时空去寻找依赖关系。 当你在写代码的时候,你在第100行定义了一个变量user_id,在第2000行调用它。模型在预测第2000行的那个token时,它不需要从第100行一路背诵下来,它的Attention机制让它能直接看到那个定义。这种跨时空的连接能力,就是逻辑涌现的基础。它学会了变量作用域,学会了函数调用栈,这些不是程序员教它的,是它为了把代码补全这个任务做到极致,自己悟出来的。 这里面有个非常有意思的现象,就是In-context Learning(上下文学习)的本质。 以前我们觉得提示词工程(Prompt Engineering)是玄学,现在我们知道,当你给模型一段Prompt,你其实是在做Inference-time Descent(推理时梯度下降)。虽然参数没变,但你的Prompt改变了Attention的激活模式,相当于临时训练了一个微型模型。 如果预测下一个词仅仅是概率匹配,那One-shot或者Few-shot根本解释不通。为什么我看两个例子就会了?因为预测下一个词的目标函数,强迫模型具备了元学习(Meta-learning)的能力。它必须学会学习如何学习。 我再讲个硬核一点的,关于算力的视角。 大家都知道Scale is all you need,这句话现在看来还是对的,但要有定语。是Effective Compute is all you need。我们现在训练新一代大模型,用的数据早就不单纯是网页抓取的垃圾了。现在的核心竞争力是合成数据,是模型自己思考过程产生的数据。 这就涉及到一个更深层的问题:为什么通过预测下一个token,能学会数学? 数学是最严谨的逻辑,差一个符号全盘皆输。如果只是概率模仿,它永远学不会数学。它之所以现在能解奥数题,是因为在训练数据里,包含了大量的推导步骤。模型发现,如果它跳过推导直接猜答案,Loss会非常高,因为它猜不对。只有当它老老实实地一步步预测中间步骤,因为...所以...设...,把这个思维链条完整地预测出来,最后的答案自然就水到渠成了。 所以,不仅是预测下一个词,更是预测思维的中间状态。 现在的前沿模型,特别是那些专注于重推理(Heavy Reasoning)的架构,它其实把这个过程显式化了。它在给你输出最终答案之前,后台可能已经跑了上万个token的思维链。这上万个token,每一个都是预测下一个词。它自己跟自己辩论,自己给自己找bug,自己推翻自己的假设,最后才把那个经过千锤百炼的下一个词吐给你。 你看,这哪里是预测?这分明是思考。 只不过,这种思考被包装成了序列生成的格式。人类的思考不也是这样吗?你心里想事情的时候,难道不是有一个声音在说话?那个声音也是线性的,也是一个词接一个词的。你没法同时想两个念头,你的显意识就是一条Token流。从这个角度看,LLM的架构其实意外地符合智能的本质特征。 咱们再聊聊代码能力。作为算法工程师,这块我是感触最深的。 几年前Copilot刚出来的时候,也就是补全个for循环。现在你看看,IDE里的AI Agent,直接给你重构整个微服务架构。 为什么?因为代码是逻辑密度最高的文本。模型在预测代码的下一个token时,它受到的约束是极强的。如果你预测错了一个分号,编译器就报错。这种报错反馈(虽然后期多是RL环节加入,但在Pre-training阶段代码的结构性本身就是强监督),让模型对逻辑的一致性极其敏感。 我之前在训练一个专用于CUDA内核优化的垂直模型。我们把GitHub上所有的CUDA高性能代码喂给它。如果你只看表面,它是在学C++语法。但实际上,它为了预测准那个**__syncthreads()**指令出现的位置,它必须理解GPU的线程束(Warp)调度机制,它必须理解内存屏障(Memory Barrier)的概念。 这些概念从来没有教科书直接灌输给它,它是通过数亿次的预测失败-反向传播-修正权重循环,自己在高维空间里把这些概念勒出来的。 这就像你是学画画的。老师不教你透视原理,就让你临摹一万张照片,画错一点就打手板。画到第一万零一张的时候,你脑子里自然就长出了透视线,因为只有懂了透视,你才能在不打手板的情况下画出下一笔。LLM就是那个被打了几万亿次手板的画家。 还有个挺有争议的观点,关于幻觉。 很多人诟病模型会胡说八道。其实在技术人员眼里,幻觉和创造力是同源的。它们都是预测下一个词的副产品。 当模型面对一个它确定的事实,比如水的化学式是,它预测H2O的概率接近1。这叫知识提取。 当模型面对一个开放性问题,比如给一家火锅店起个名,它预测的概率分布是平坦的,辣翻天、赛博火锅、量子涮肉概率都差不多。这时候采样算法选了一个,这叫创造力。 当模型面对一个它没见过的问题,强行去预测,结果选了一个错误的路径,这叫幻觉。 现在的技术趋势,比如我们正在搞的Retrieval-Augmented Generation (RAG) 3.0,或者是基于长上下文(Long Context)的显存优化,其实都是在限制模型在预测下一个词时的搜索空间,给它挂外挂,给它看参考书,不让它瞎猜。 但归根结底,核心驱动力依然是那个简单的、暴力的、美妙的Next Token Prediction。 有时候夜深人静,看着服务器机房的灯在那闪,看着Loss log一行行刷,我真的会有一种敬畏感。我们人类自诩万物之灵,觉得自己有灵魂,有自由意志。但有没有可能,我们的自由意志,也不过是生物神经网络里的Next Token Prediction? 我们的大脑无时无刻不在预测下一秒会发生什么。走路时预测脚下的触感,聊天时预测对方的反应,做决策时预测未来的回报。当预测偏差时(Surprise),多巴胺分泌,大脑修正模型。这跟Transformer的反向传播有什么本质区别吗? 也许,智能的本质就是对未来的压缩和预测。 到了2026年,我们已经不再像2023年那样,对LLM盲目崇拜或者盲目恐惧了。我们把它当成工具,当成一种新型的计算原语。 你现在的手机操作系统里,底层可能就跑着一个3B的小模型,专门负责预测你下一步要点哪个App,从而提前预加载。这不也是预测下一个Token的高级应用吗? 所以,回到你的问题。为什么仅预测下一个词就能涌现高级能力? 因为我们的宇宙本身就是因果的。过去决定未来。如果你能完美地利用所有的过去,精准地预测未来,你就必须掌握控制这个宇宙运转的所有法则。 大模型还没有掌握所有法则,但它通过预测下一个词这个笨办法,已经摸到了人类理性思维的门槛。它不需要懂,它只需要像懂了一样去预测。而当它预测得足够完美时,像和是之间的界限,就已经模糊了。 这就是为什么我们现在在这个行业里,越来越少谈论算法,越来越多谈论数据和算力。因为算法的上限已经被物理规律锁死了,Next Token Prediction就是通往AGI的最短路径,至少目前看是这样。 最后,我想给在这个时间节点还对AI底层原理感兴趣的朋友一个建议。别被那些花哨的名词吓住了。去读读原始的Attention is All You Need,去看看Andrej Karpathy早年的讲解,哪怕是2026年的现在,那些基础直觉依然是最硬核的。 技术在变,架构在变,甚至连Transformer可能都会被替代,但通过压缩数据来预测未来,从而提取智能这个范式,只要香农的信息论不倒,估计还得统治我们很长一段时间。 这行混久了,越来越觉得,大道至简。预测下一个词,就是那个道。 希望这番碎碎念对你有帮助。有空再聊。 送礼物 |

|

|

[img_log] |

|

|

3 人已送礼物 |

|

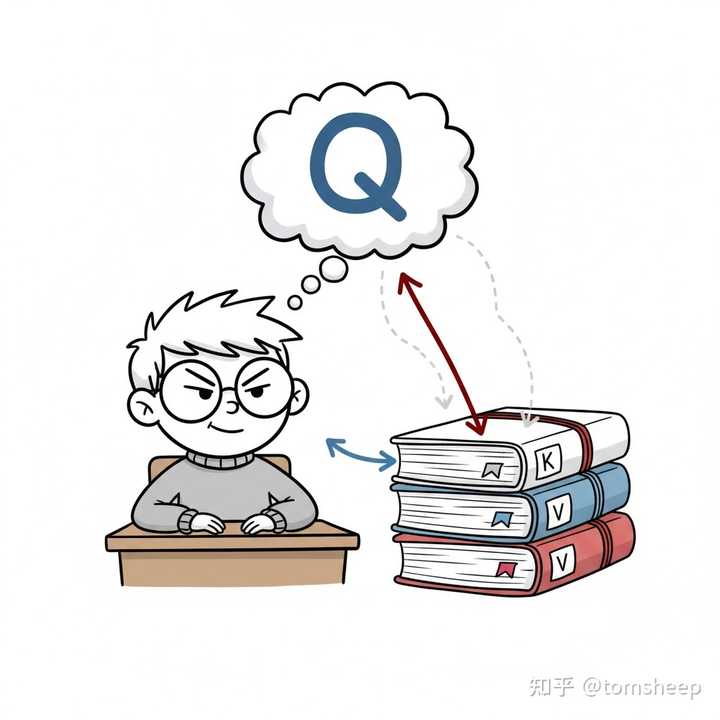

前几天写了一个 LLM 随机性来源的科普文章,评论区有一个问题是: 为什么 LLM 重复「预测下一个词」这个步骤,就可以使得它输出的文本的语句是通顺的,而且能保持逻辑一致性?是因为这个高度复杂的函数本身具备这样的关联性,在结果上限制了语法、因果逻辑、相关性,一定不会跑题吗? 这个问题非常好,也符合我们的直觉:为什么一个如此「短视」的目标(预测紧邻的下一个词),能够孕育出一个具备「远见」和复杂能力的系统? 看似模型每一步都在做一个局部最优解,但最终结果却展现出全局的连贯性、逻辑性和创造性。这确实是整个领域最令人着迷的问题之一。 这个问题目前并没有非常确切的答案,可以说我们对 LLM 可解释性的探索还不足万一。不过,我们不妨一起从最基本的问题出发,来稍微介绍一下当前的一些主流看法: 全局上下文的构建:模型是如何在每一步都「看到」全部历史的?它和我们大脑的记忆机制有何异同?预测与理解的关系:为什么「预测」这个目标会迫使模型去「理解」?从模式匹配到即时学习:归纳头(Induction Heads)是如何工作的?它是模型「举一反三」能力的全部秘密吗?涌现的本质:能力的涌现(Emergence)究竟如何解释?为什么更大的模型就能实现这种非线性的能力飞跃?一、模型如何克服「金鱼记忆」? 首先,模型能够变现出种种高级能力的基础,是它要能充分理解上下文。也就是说,要保证在做预测的时候,已有的信息能够被参考到。打个比方,就好比参加一场开卷考试,决定成败有两个关键的要点:第一点,得保证你带进考场的资料,足以回答考试中遇到的题目;第二点,你需要有能力在考试的时候高效地查阅这些资料。 这两点缺一不可,而且相互影响。资料带的不够,巧妇难为无米之炊。而带了过多的资料,又会加大现场查阅的难度。目前主流的 LLM 都基于 Transformer 架构,其中自注意力(Self-Attention)机制解决的,其实就是这么一个「带够资料 + 高效查询」的核心问题。 早期的 Seq2Seq 都会先把上下文压缩到一个固定大小的中间向量中,相当于你给开卷考试准备了一张写满小抄的 A4 纸,但即便你把字写得再小,这张纸的大小总是有限的,信息总有损耗。而注意力(Attention)机制,则是把你所有的原始资料都带进了考场,并给这些资料进行了高效的索引。从而,模型在每一步预测时,都能动态地回头查阅原始资料。 具体来说,每个输入的 token 都会生成三组向量:查询(Q)、键(K)和值(V)。Q 用来提问,我现在需要什么信息? K 和 V 则像资料库中的索引和内容。当模型处理一个新词时,它就用 Q 去和所有旧词的 K 做匹配(点积计算相似度),相似度越高,说明那部分旧信息越相关,然后用这些匹配到的权重去加权求和对应的 V,从而得到一份上下文加权摘要。 这种机制让模型具备了「任意回溯」的能力。理论上,只要上下文长度够,它就可以在预测时参考前面任意位置的信息。换句话说,模型的「记忆」不再依赖一个瓶颈式的中间状态,而是以计算访问的方式(compute-as-memory) 来实现记忆的调用。 当然,这种记忆方式虽然克服了早期 RNN/Seq2Seq 的金鱼记忆问题,但也引入了新的挑战:计算和存储开销随着上下文长度呈平方级增长。模型虽然能看得「远」,但代价也变得高昂。因此,后续研究开始探索如何在不丢失重要信息的前提下,压缩、稀疏化或结构化注意力模式。不过这超出了我们这篇文章的主题,暂不展开。 我们现在只需要理解:Transformer 有能力在每一步都构建一个包含全局信息的、动态的上下文表示。 |

|

|

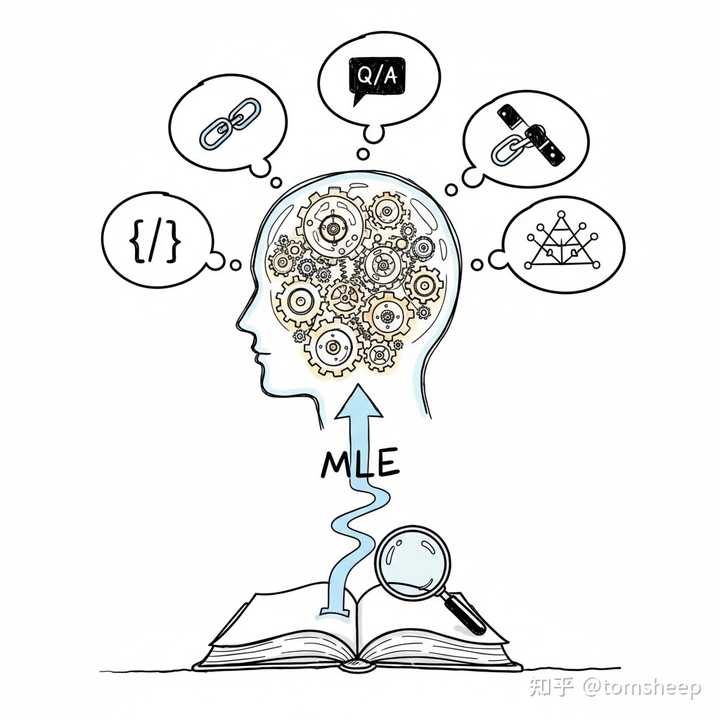

拓展阅读: [1409.0473] Neural Machine Translation by Jointly Learning to Align and Translate[1706.03762] Attention Is All You Need二、预测即是理解? 表面上,LLM 的训练目标极其单纯:给定前文,预测下一个词的概率最大化。这种最大似然训练(MLE)看似只是统计学习意义上的「拟合文本分布」,但它展现出的更深一层的结果却让人惊讶。 在庞大的语料分布下,单纯记忆和匹配模式是无法有效提高预测准确率的。模型要想在不同语境、不同风格、不同任务下都能生成合理的词语,就必须主动捕捉隐藏在文本背后的生成机制——也就是人类语言中所蕴含的世界结构、因果关系、角色意图与推理逻辑。 于是,模型的优化过程本质上成为一种无监督的算法发现。当它在反复尝试最小化预测误差时,梯度下降和架构归纳偏置(Inductive Bias)会自然推动网络形成一系列内部计算模式。这些模式并非显式编程出来的规则,而是从预测需求中「涌现」的有效策略。 举几个典型的例子: 为了预测下一句对话回复,模型必须隐式建模对话双方的语义意图与情绪状态;为了生成合理的因果叙事,模型会学习到事件之间的逻辑顺序与依赖关系;为了在代码数据中预测下一个 token,它需要掌握程序语法、控制流乃至调试逻辑;为了压缩语言的高维分布,模型内部会逐渐形成语义层次结构,以便用更低维的抽象捕捉更高层的语义规律。 这些「能力」的出现并非人为设计的功能模块,而是优化过程的副产物。从信息论角度看,最大似然训练迫使模型以有限参数量去逼近庞大而复杂的自然语言分布。最优的压缩方式,恰恰是去复现语言生成的底层规律。于是,语言模型不只是学会「说话」,更是学会了生成语言所需的思考过程。 这就是行业中经常所说的「涌现」(Emergence)现象:当模型规模与训练数据达到某一临界点后,原本不存在的复杂行为(如算术、逻辑推理、多步规划)会突然出现。换句话说,预测驱动的优化在足够复杂的系统中,会自发实现推理驱动的计算。 我们现在对这种现象的解释还非常不完善,而且也有不少质疑的声音。暂时,我们只能比较笼统地认为,LLM 可被视作一种「通过预测学习世界」的系统。它的智能,不是来自外部监督的灌输,而是来自优化过程中对世界结构的压缩、抽象与重建。它预测得越好,也就「理解」得越深。 |

|

|

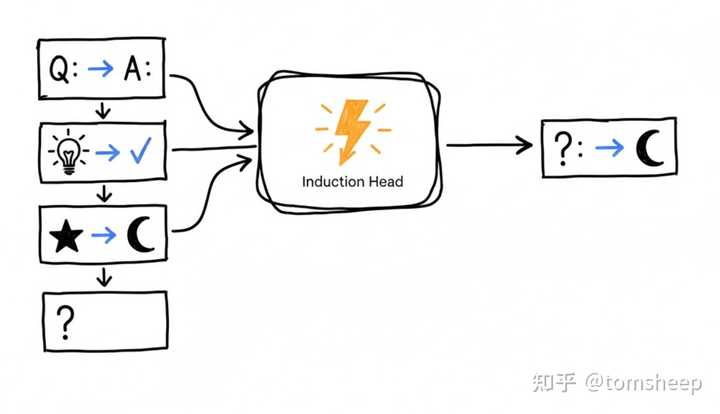

拓展阅读: [2206.07682] Emergent Abilities of Large Language Models[2304.15004] Are Emergent Abilities of Large Language Models a Mirage?三、认知 / 神经科学的启发 有趣的是,大型语言模型(LLM)基于「预测下一个词」的学习机制,与人类大脑在语言理解中的工作方式存在一些相似性。越来越多的认知科学与神经成像研究指出,大脑并非被动接收信息,而是在持续地进行预测。这一理论框架被称为 预测编码(Predictive Coding)。 根据预测编码模型,人类的感知与理解可以被看作一种分层预测–校正过程:高层神经网络基于经验与上下文生成对输入的预测,而低层感官信号则不断反馈预测误差(prediction error)。大脑的学习目标,就是不断最小化这种预测误差——这与 LLM 的最大似然优化在形式上高度相似。 在语言领域,这种层级预测结构表现得尤为明显。当人类听到一句话时,神经系统并不是等到句末才理解意思,而是在每个词出现时,就会根据上下文动态地预测下一个可能的词汇、语义或语法结构。一些研究通过脑成像对比发现:当人类阅读句子时,大脑语言相关区域(尤其是前额叶和颞叶)中激活的模式,与 Transformer 模型在预测下一个 token 时的激活分布呈显著对应关系。他们提出,大脑在语言处理时同样形成了一种层次化预测体系——低层预测语音与词汇,中层预测句法与短语结构,高层则预测语义与叙事走向。 这种相似性并不意味着 LLM 就是大脑的复制品,但它提供了一个重要洞见:预测任务天然会诱导系统学习出结构化的世界模型。无论是神经系统还是深度网络,当一个系统被要求高效地减少预测误差时,它必然会去提炼那些能最好解释输入变化的中间表示。这或许是结构、语法、因果与语义层级得以自发涌现的根源。 这种跨领域的呼应也为我们提供了一个更宏观的视角:也许「智能」的本质,不是推理或记忆的堆叠,而是世界状态的持续预测与误差最小化。 拓展阅读: Evidence of a predictive coding hierarchy in the human brain listening to speech | Nature Human Behaviour 四、上下文学习 LLM「涌现」出的最令人惊讶的能力之一,是它们能够在不修改任何参数的情况下学习新任务。 只要在提示(prompt)中给出几个例子或一段说明,模型就能立刻模仿出相应的模式、语气或解题方式——这正是所谓的 上下文学习(In-Context Learning)。 这一现象其实是模型在推理时复用了它在训练中习得的预测策略。在最大似然训练阶段,模型见过无数形式各异的输入 - 输出对(问题与答案、句子与续写、代码与输出)。因此,它被迫学会在序列中识别并复现模式。当我们在提示中提供「示例 + 问题」时,模型就会把它视作一串更长的文本样本——唯一的目标仍然是预测下一个 token。但为了最小化预测误差,模型会自然地把前面的示例总结成一种「规则」,并将其应用到新的输入上。 这种机制的核心在于 Transformer 的注意力结构。Anthropic 的一些研究者发现,模型内部出现了被称为 归纳头(Induction Head) 的注意力回路。这些注意力头能够在序列中找到类似的子串模式(例如两个问题之间的相似提示词),并把第二个问题与第一个答案建立起对应关系。 这使得模型在处理少样本(few-shot)提示时,能够根据上下文中出现的映射关系,生成符合同一规则的新答案。换句话说,模型在推理时将上下文当作程序的一部分来执行。 举个直观的例子:当提示中出现几组「英语 -> 中文」的翻译示例时,模型会学会把这种「映射规律」抽取出来,并在下一次输入时直接应用。这不是因为模型「真的理解」了中文,而是因为它在上下文中识别出一种统计可复用的模式,并在输出层复现这一模式。 更有意思的是,这种机制并不局限于语言任务。随着模型规模扩大,上下文学习能够处理越来越复杂的模式:从算术运算、表格推理到多步逻辑链。它就像一个临时的解释器,能在上下文中「编译」任务规则并「执行」输出。 这使得提示工程(Prompt Engineering)变成了某种动态编程接口——开发者通过构造上下文,就能让模型在不改参数的前提下完成新功能。这种能力可以被视作预测范式的一次质变: 模型不再只是被动地预测下一个词,而是在每次预测前,主动地在上下文中构建一套小型任务模型。它用自己的注意力网络来临时学习、归纳和执行,这种「即时学习」正是大模型智能的雏形。 当然,Induction Head 也只是我们目前对 ICL 理解的冰山一角。更复杂的机制还需要深入的挖掘。 |

|

|

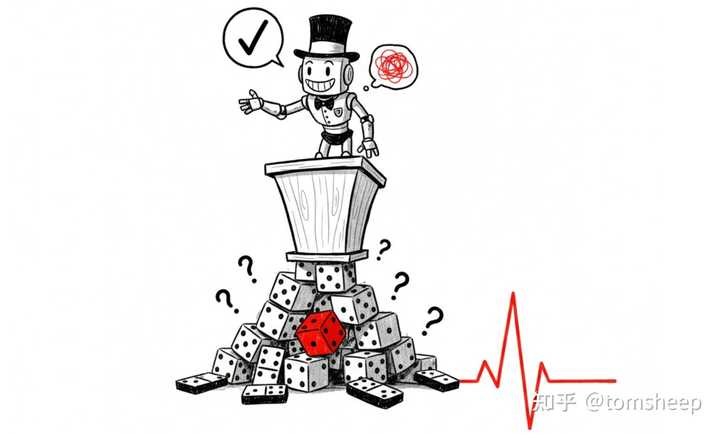

拓展阅读: [2209.11895] In-context Learning and Induction Heads[2212.07677] Transformers learn in-context by gradient descent[2402.15607] How Do Nonlinear Transformers Learn and Generalize in In-Context Learning?五、NTP 也存在缺陷 尽管预测下一词(NTP)的这种简洁的模式取得了巨大成功,但必须强调的是:这种能力的出现,并不意味着模型的函数形式天然保证逻辑一致或事实正确。 LLM 的本质,仍然是一个被训练来最小化下一个词预测误差的概率分布近似器。它的每一次输出,都是在特定上下文下从概率分布中抽样的结果——并不存在一个外部的「真理判定器」来约束生成是否合理。换句话说,模型输出的「自洽性」与「准确性」只是统计意义上的倾向,而非逻辑意义上的必然。 由于训练数据的不均衡、提示措辞的细微差别、以及采样策略的随机性,模型可能在不同条件下生成完全相反的结论。它之所以常常显得「合理」,是因为它习惯性地复制了训练数据中的语用结构和知识模式。 但一旦提示超出了分布的熟悉区域,模型的「预测力」就会迅速退化,出现自信但错误的推理或风格化的胡编。它生成的推理链往往是启发式的重构——一种看似合理、实则为提高预测质量而形成的「伪算法」。 一些研究也指出,这种范式存在内在局限:LLM 的优化目标只关心句子的统计连贯性,而不关心命题的真伪。只要「看起来像是正确答案」的句式能提高预测概率,它就会被梯度强化。这意味着模型的「知识」其实是一种预测偏好(predictive bias),而非语义层面的真理表述。 因此,模型并不会「保证不跑题」。相反,它总是在跑题的边缘维持平衡:如果提示足够清晰、上下文足够稳定,它能保持一致性;但一旦上下文含糊或带有诱导性,它就可能生成出逻辑上完全相反的内容。 如何在保持生成流畅性的同时,为模型引入可验证、可校正的推理机制,也是一个非常活跃的研究领域。 |

|

|

拓展阅读: [2403.06963] The pitfalls of next-token predictionThe Surprising Power of Next Word Prediction: Large Language Models Explained, Part 1 | Center for Security and Emerging Technology总结看似短视的「下一词预测」之所以能孕育出远见与复杂能力,关键在于自注意力为模型提供了全局可访的上下文最大似然训练推动模型以压缩与抽象的方式逼近语言与世界结构上下文学习则让模型在推理时即时归纳并复用规则当规模与数据跨过某些阈值,这些机制会叠加出非线性的能力提升。不过,LLM 仍是概率匹配器,连贯与正确只是一种统计倾向而非逻辑必然,因而需要以检索、工具、过程监督与对齐训练等方法加以约束。 送礼物 还没有人送礼物,鼓励一下作者吧 |

|

1. 表面是 Next One,实则是 Next N 虽然 Pre-training 的 Loss 仅针对当前 Token 计算,但为了实现精准预测,模型的 Hidden States 必须隐含对后续内容的规划。这就像开车过弯,当下的操作虽只是转动方向盘,但大脑其实已经预判了未来几十米的轨迹。 从机制上看,推理 Next Two 时,历史的大部分 KV Cache 实际上早在 Next One 阶段就已确定。这意味着虽然是在做单步生成,但内部参数已经为后续序列做好了准备。 这一点在 Post-Training 阶段尤为明显:RL 的 Reward 是基于完整的 Token List(整段生成结果)给出的。这种针对最终结果的反馈,进一步强迫模型在生成当前 Token 时,必须具备对未来的全局规划能力。 Next One是动作空间,Next N是奖励维度。 2. GPT的NTP是一个高效的文本生成任务:生成是理解的最高级形式 给GPT找一个参照物——BERT,才能看出它的神奇特质。在参数量不大的早期,GPT和BERT分别代表了生成模型和理解模型,并且同样参数量级下,GPT的casual attention在理解任务上完全不敌BERT的full attention。 但是随着参数和数据的Scaling Up,迎来了GPT-3时刻:生成和理解任务统一并远远超越了BERT。 我觉得包括几点: GPT自回归的设计(casual attention+next token prediction)能非常高效地利用预料中每一个token,为Transformer提供训练梯度,BERT的“完形填空”任务的预料利用效率可能只有不到20%。GPT的设计,适合高效地对接所有的文本语料,进行数据Scaling Up,构建世界模型。生成任务比理解更难,Scaling Limit更高,并且通过“生成”带动了“理解”,实现了生成和理解的统一和超越。 类比于人,“理解”就是“听和读”,“生成”就是“说和写”。费曼学习法被公认为世界上最高效的学习方法之一,它核心理念是“如果你不能简单地把一个知识解释清楚,那就说明你还没有真正理解它。” 为了能讲清楚,它必须先理解清楚,这是人类的“生成”带动“理解”的例子。 “生成是理解的最高级形式”。 只有当模型建立了一个足够完善的世界模型,它才能在概率空间中坍缩出那个唯一正确的Next Token。 再对比T5,它由Encoder+Decoder组成,再NMT(Neural Machine Translation)任务上也显示出了Scaling Law——翻译任务上的 cross-entropy loss 也随模型 / 数据呈幂律下降。更细致地Scaling Law研究分别取放大Encoder和Decoder参数:单独放大 Encoder 或 Decoder,幂律斜率和最优点都不一样,一般是多给 Decoder 算力更划算,Encoder 放太大收益会更快递减。也就是说Scaling那个做Next One生成的参数量更划算!再次说明了,生成是驱动理解的,是理解的最高形式!后来T5因为拖着个Encoder(LM模型的工程拖累),所以并不适合作为通益模型的架构。 在视觉领域,理解与生成长期依赖两套完全不同的体系:理解模型多以 ViT 及其自监督变体为主,生成模型则以 Diffusion 为核心,二者在网络结构与训练目标上都不统一。这与 NLP 形成鲜明对比——GPT 只凭一个简单的 Next Token Prediction 就同时逼出了理解与生成能力,并随着规模扩展出强通用智能。 目前 CV 也在寻找“视觉版 NTP”:包括 Masked Image Modeling、自回归式视觉 token 生成、多模态统一建模,以及 Transformer 化的扩散模型等方向,都在尝试用一个通用框架同时解决理解与生成。但迄今仍没有出现一个像 NTP 那样优雅、高效、可大规模扩展的单一任务。 3. 所谓的“涌现”,可能是测评指标不够平滑带来的错觉 就像养一个小孩你会觉得它突然会走了,突然会说话了,但是他的肌肉力量和语言能力可能是平缓发展的,只是我们评估能力是看最终的那个走出的第一步和说出的第一句话。 大模型也是一样,Loss 一直在降,能力一直在涨,测评指标却是跳变的,最后惊呼“涌现”了。 关于这点的研究证据:斯坦福大学团队在 NeurIPS 2023 发表的论文 《Are Emergent Abilities of Large Language Models a Mirage》详细论证了这一点。 研究发现,所谓的“涌现曲线”完全取决于你用什么尺子去量。 如果使用 Exact Match(完全匹配,对错 0/1 分)这种非线性指标,就会看到陡峭的“涌现”。一旦换成 Token Edit Distance 或 Brier Score 这种平滑的线性指标,那条陡峭的曲线瞬间就变平了,模型的能力其实是随着规模线性提升的。 虽然有上面的说法,我觉得还是存疑:是否存在涌现,或涌现背后的机制。 对比涌现(Emergence),更神奇和值得深究的是顿悟(Grokking)。 涌现(Emergence)和顿悟(Grokking)时长会被搞混,如果严格区分:Grokking 可以被视为一种“时间维度”上的涌现。 Emergence (涌现): 通常指随着模型规模(参数量、数据量)变大,能力突然出现。Grokking (顿悟): 通常指随着训练时间(步数)变长,泛化能力突然出现。 这里各种解释太混乱了,我最后自己也没理顺逻辑,后面的就删掉了。。有空再聊 |

|

|

| [收藏本文] 【下载本文】 |

| 科技 最新文章 |

| 为什么有些人不敢使用微信? |

| 作业帮 iOS 版应用被曝存在假卸载按钮设计, |

| 你认为稀土是中国手里的终极王牌吗? |

| 如何看soul这个软件? |

| 如何看待FARS批量制造100篇论文? |

| 为什么有些用户宁愿看盗版,也不愿为正版视 |

| 英政府拟强制中资桥接芯片巨头FTDI出售80%股 |

| 如何看待姚班大神陈立杰官宣入职 OpenAI? |

| 微信有多傻逼? |

| 如何看待「斩杀线」概念的出现及其影响? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

|

娱乐生活:

电影票房

娱乐圈

娱乐

弱智

火研

中华城市

印度

仙家

六爻

佛门

风水

古钱币交流专用

钓鱼

双色球

航空母舰

网球

乒乓球

中国女排

足球

nba

中超

跑步

象棋

体操

戒色

上海男科

80后

足球: 曼城 利物浦队 托特纳姆热刺 皇家马德里 尤文图斯 罗马 拉齐奥 米兰 里昂 巴黎圣日尔曼 曼联 |

| 网站联系: qq:121756557 email:121756557@qq.com 知识库 |