| |

|

| 知识库 -> 科技 -> 如何看待英伟达 CEO 黄仁勋在2026 CES上的演讲,有哪些信息值得关注? -> 正文阅读 |

|

|

[科技]如何看待英伟达 CEO 黄仁勋在2026 CES上的演讲,有哪些信息值得关注? |

| [收藏本文] 【下载本文】 |

|

英伟达 CEO 黄仁勋将于 1 月 6 日早上 5 点在拉斯维加斯举行的 CES 2026 上发表主题演讲。 [图片] 黄仁勋新年首场演讲:AI超级芯… |

|

作者|周一笑 作者|王兆洋 Vera Rubin已经在全面投产。 这是黄仁勋在CES 2026上透露的最重要信息。 这场在拉斯维加斯的90分钟演讲,是黄仁勋的开年演讲,给2026年定基调的意义非常明确。而整场演讲有很强的叙事设计——他要讲的故事逻辑是这样的: 回顾2025年,scaling law还在继续,推动这个过程里开源很重要,而英伟达做了很多开源,甚至第一次自称"开源之王"(NVIDIA Leads Open Model Ecosystem),尤其是物理世界的模型其实在由它来推动——而这一切都在证明强烈的需求还在继续,泡沫不存在,所以,新的芯片架构更加重要。 这就是Vera Rubin。 |

|

|

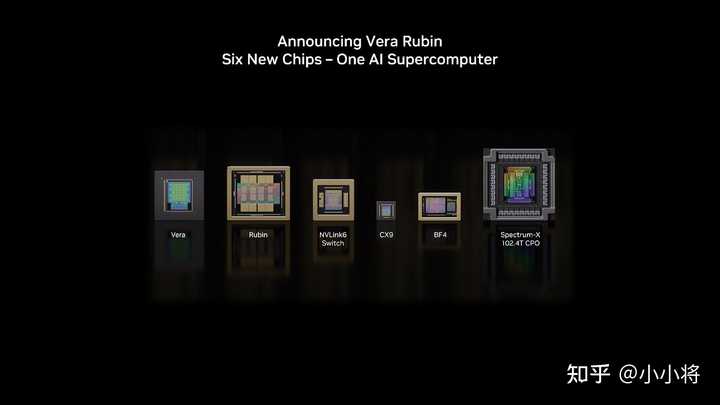

“我可以告诉你们,Vera Rubin已经在全面投产了”(I can tell you that Vera Rubin is in full production),黄仁勋在舞台上宣布。这是一个全面重构的芯片架构——从CPU到GPU,到互联方式,到机柜设计,六颗芯片全部重新设计。 |

|

|

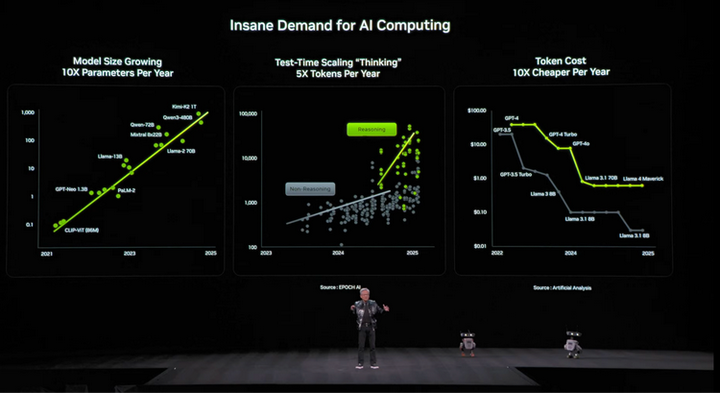

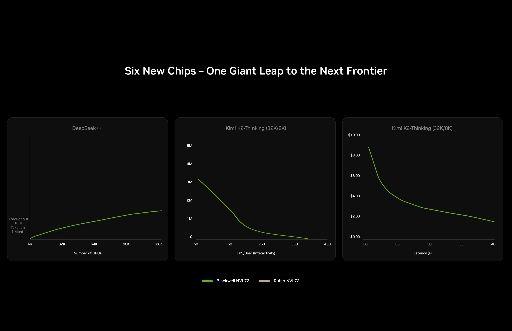

Vera Rubin - Six New Chips全景图摩尔定律追不上AI,所以必须激进 黄仁勋给出了一组数据来解释为什么必须打破英伟达自己的规则。 过去英伟达有一条内部准则:每代架构最多只改动1-2颗芯片。但这次,他们一口气重新设计了六颗。原因很简单,摩尔定律在放缓,但AI的需求在爆炸。模型规模每年增长10倍,生成的token数量每年增长5倍,单token成本每年下降10倍。 |

|

|

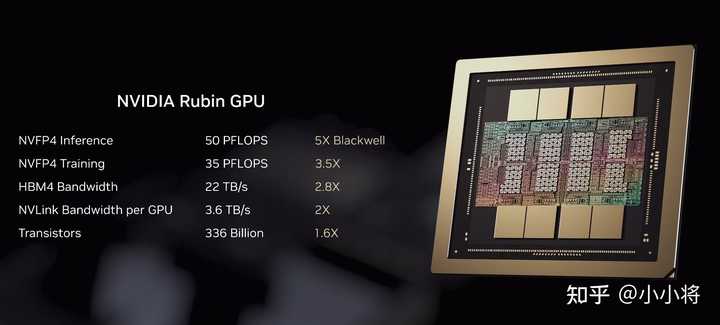

AI 算力需求爆炸式增长 “我们每年能获得的晶体管数量,根本不可能跟上10倍更大的模型、每年5倍更多的token生成”,黄仁勋解释道,“除非我们采用激进的、极致的协同设计,否则不可能跟上这种增长速度。” 换句话说,如果继续按部就班地迭代,英伟达会被自己的客户甩在后面。 Rubin GPU:5倍性能只用1.6倍晶体管 六颗芯片中,Rubin GPU是核心。 |

|

|

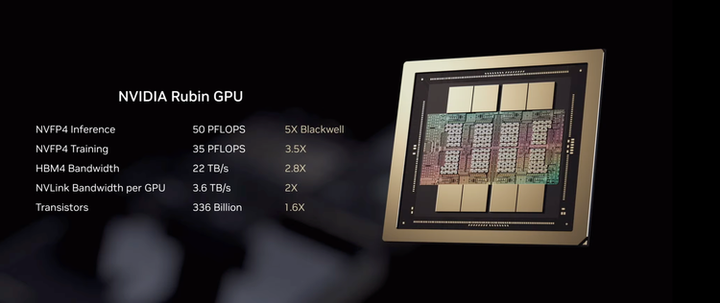

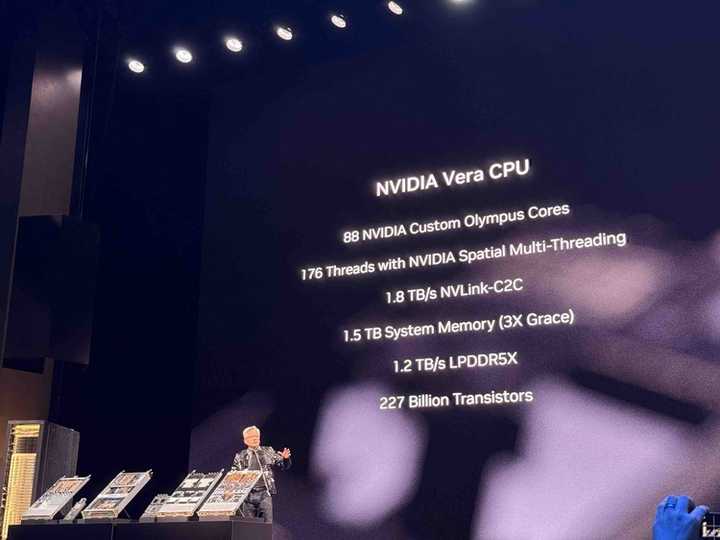

NVIDIA Rubin GPU规格图 最关键的数字是这个,NVFP4推理性能达到50 PFLOPS,是Blackwell的5倍,但晶体管数量只有3360亿,仅增加了1.6倍。这意味着架构效率的巨大飞跃,而不仅仅是堆料。HBM4带宽达到22 TB/s(2.8倍),单GPU的NVLink带宽达到3.6 TB/s(2倍)。 这背后是NVFP4 Tensor Core的创新——一种新的4位浮点格式,通过硬件层面的自适应精度调节和动态transformer引擎实现。黄仁勋暗示这可能成为行业标准:“我不会惊讶于整个行业都希望我们把这个格式和架构变成行业标准。” Vera CPU:88个自研核心,不是ARM公版魔改 全新的自研CPU采用88个Olympus核心,176线程,1.5TB系统内存(是Grace的3倍),1.2 TB/s的LPDDR5X带宽,2270亿晶体管。 |

|

|

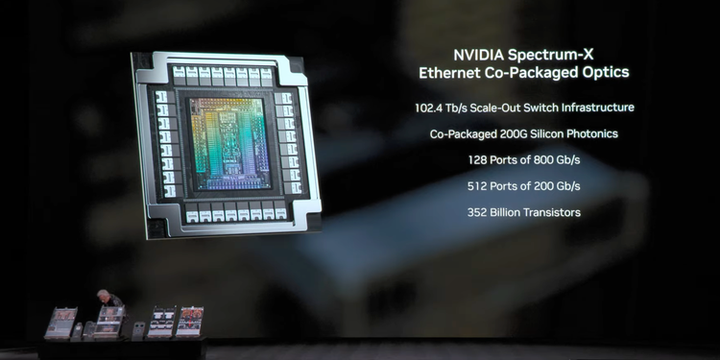

这是英伟达第一次在数据中心CPU上如此激进地自研。Olympus核心是全新设计,不是ARM公版的修改。黄仁勋在台上展示了从Blackwell到Rubin的硬件演进,亲手拿起计算托盘——“你必须是一个身体状况很好的CEO才能干这个活”””(You have to be a CEO in really good shape to do this job),他开玩笑说。 硅光子上芯片:英伟达变成了网络公司 让黄仁勋特别兴奋的是Spectrum-X Co-Packaged Optics,硅光子直接封装在芯片上。 |

|

|

NVIDIA Spectrum-X Ethernet Co-Packaged Optics规格 这颗芯片采用TSMC的COUPE工艺,实现102.4 Tb/s的交换机基础设施,128个800 Gb/s端口,512个200 Gb/s端口,3520亿晶体管。黄仁勋说这让英伟达“成为了全球最大的网络公司”。 配合新一代NVLink 6.0,单GPU带宽达到3.6 TB/s,整个NVL72系统的互联带宽达到260 TB/s。黄仁勋的比喻是,“这是全球互联网带宽的两倍”,全球互联网总带宽大约是100 TB/s。 |

|

|

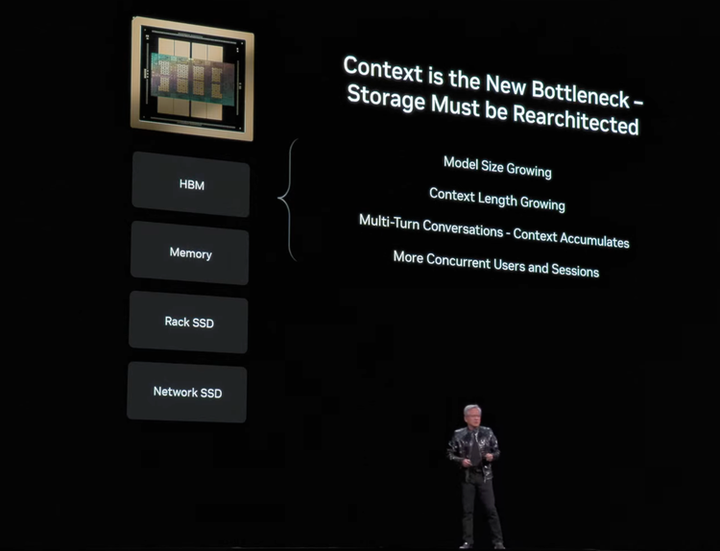

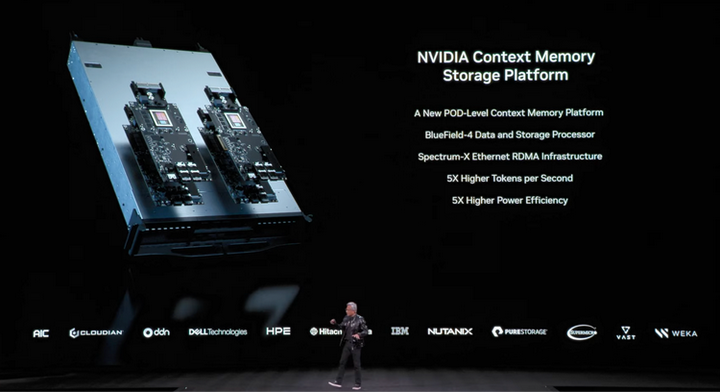

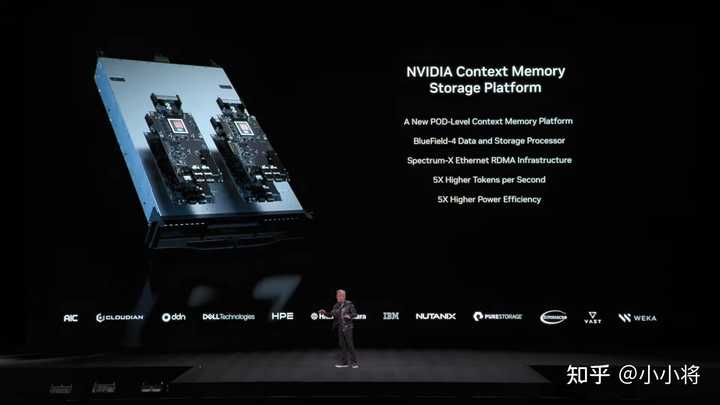

KV Cache成了新瓶颈,BlueField-4来解决 黄仁勋特别强调了一个正在浮现的问题:context memory正在成为新的瓶颈。 |

|

|

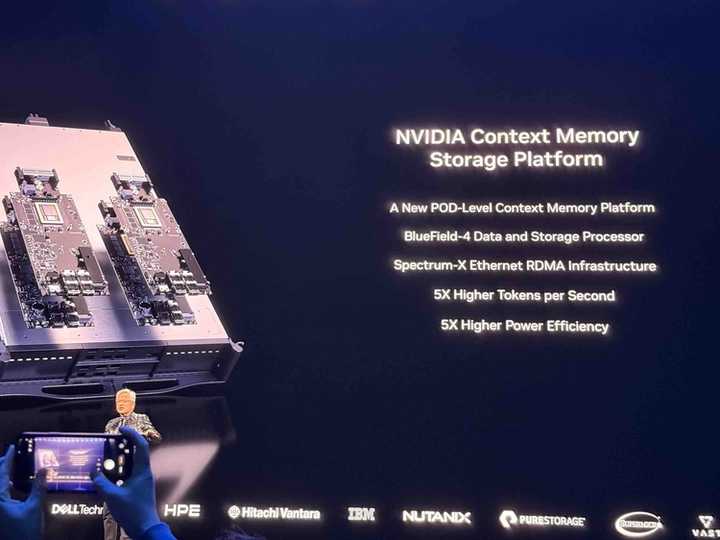

随着上下文长度增长、多轮对话累积、并发用户增加,KV cache的存储需求在爆炸。BlueField-4 DPU就是为了解决这个问题,800G Gb/s的SmartNIC和存储处理器,内置64核Grace CPU,相比上代在网络、计算、内存带宽上分别提升2倍、6倍、3倍。 |

|

|

配合新的Context Memory Storage Platform,可以为每个节点提供150TB的KV cache存储。黄仁勋称之为“完全革命性的”。 |

|

|

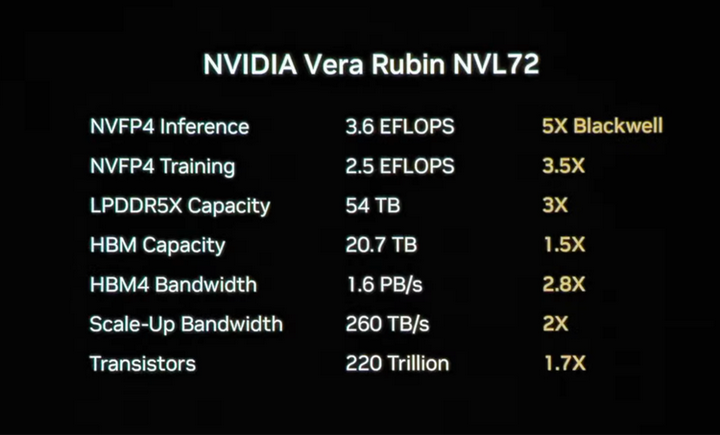

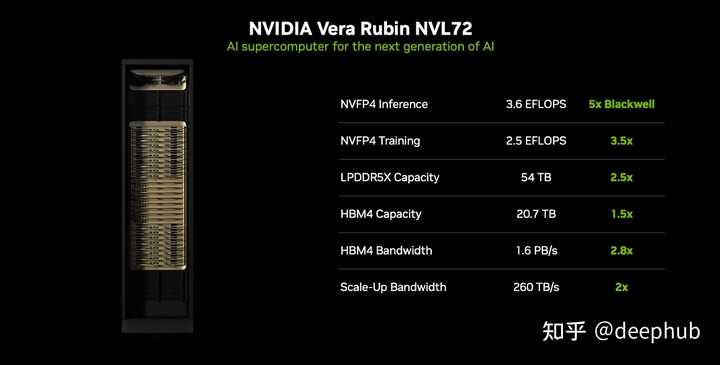

NVL72:一个机柜220万亿晶体管 六颗芯片组合成Vera Rubin NVL72系统。 |

|

|

这是一个完整的机柜级计算单元:3.6 EFLOPS的FP4推理算力(5倍于Blackwell),2.5 EFLOPS的FP4训练算力(3.5倍),54TB的LPDDR5X容量(3倍),20.7TB的HBM容量(1.5倍),1.6 PB/s的HBM4带宽(2.8倍),260 TB/s的Scale-Up带宽(2倍)。整个机柜包含220万亿个晶体管。 |

|

|

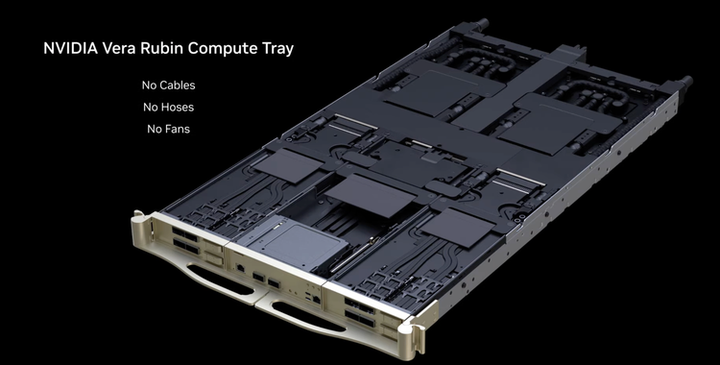

组装一个计算节点:从2小时到5分钟 除了芯片本身,Vera Rubin在系统工程上也有大量创新。 |

|

|

NVIDIA Vera Rubin Compute Tray 新的计算托盘设计是“No Cables, No Hoses, No Fans”,无线缆、无水管、无风扇。过去组装一个计算节点需要2小时,现在只需要5分钟。黄仁勋在台上亲自演示,把托盘像抽屉一样滑入机柜。 整个系统100%液冷,使用45°C的热水,不需要冷水机。"今天这台机器重2.5吨,因为他们发货的时候忘了把水放掉",黄仁勋开玩笑说。整机包含2英里的铜缆和5000根线缆,但因为采用了新的无线缆托盘设计,实际部署时的复杂度大大降低。 虽然性能是Blackwell的5倍,但热设计保持在同一水平,这意味着在相同的数据中心功率预算下,可以获得5倍的算力提升。 |

|

|

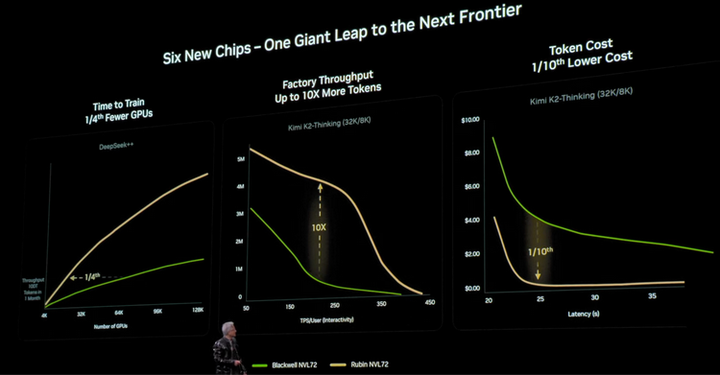

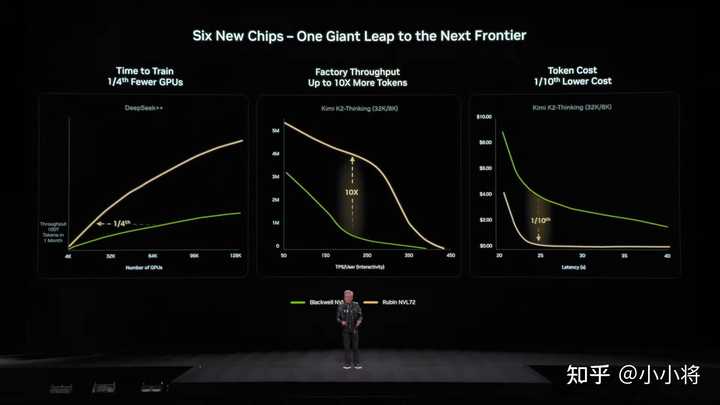

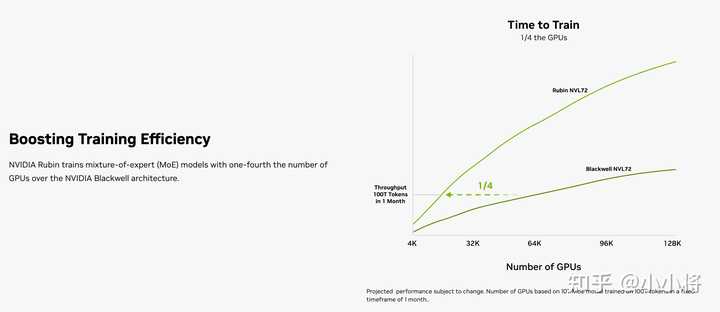

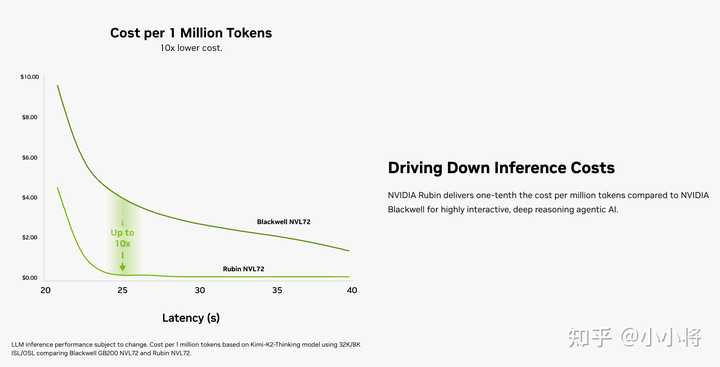

1/4的GPU,1/10的成本 黄仁勋用DeepSeek++(对未来超大规模开源模型的一种代称)和Kimi K2Thinking展示了三组性能对比。 |

|

|

训练效率:以10万亿参数模型、100万亿token、1个月训练周期为基准,Rubin只需要Blackwell 1/4的GPU数量。工厂吞吐量:从Hopper到Blackwell是10倍提升,从Blackwell到Rubin再提升10倍。Token成本:Rubin是Blackwell的1/10。 这组数据的含义很清晰,对于训练大模型的公司来说,Rubin意味着用更少的硬件、更低的成本、更快的速度完成同样的任务。 时间表:一年一代,但这次跨度更大 Vera Rubin 2026年出货,现已全面投产。Rubin Ultra NVL576在2027年下半年,性能是Rubin的4倍。Feynman在2028年,已预告。 黄仁勋维持了英伟达“一年一架构”的节奏,但这次的迭代幅度远超以往。 |

|

|

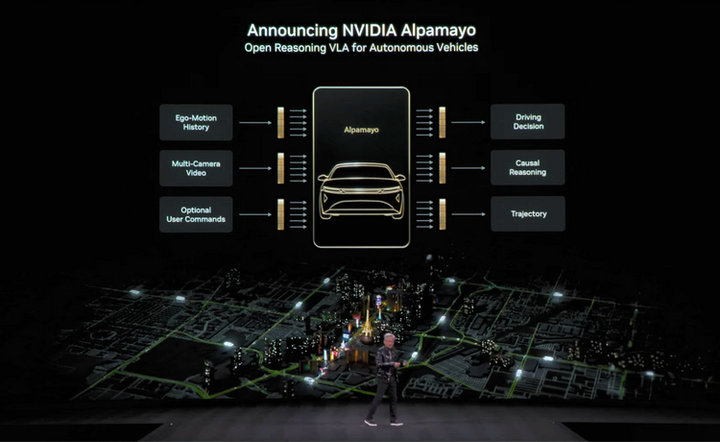

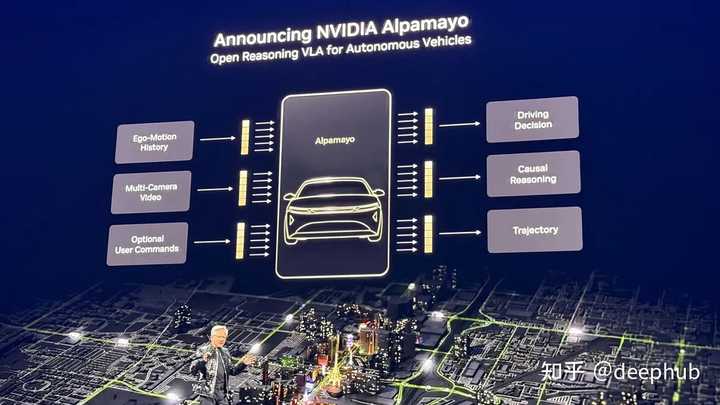

Alpamayo:物理AI的ChatGPT时刻 算力基础设施最终是为了让AI理解和操控物理世界。除了造“大脑”,英伟达也在教AI控制“身体”,演讲中另一个值得注意的发布是Alpamayo。 |

|

|

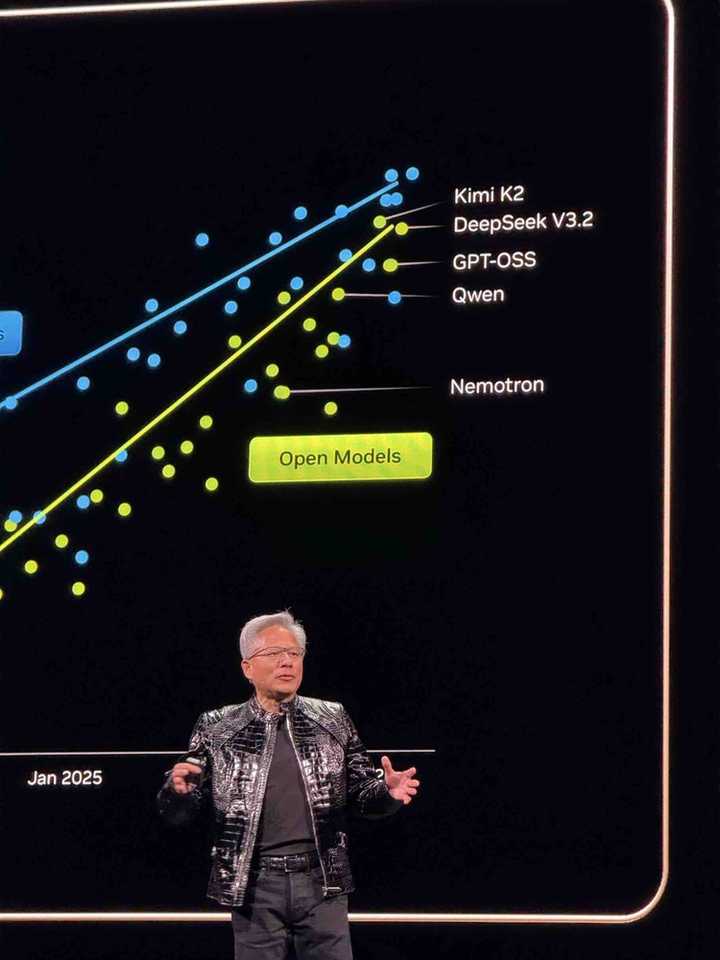

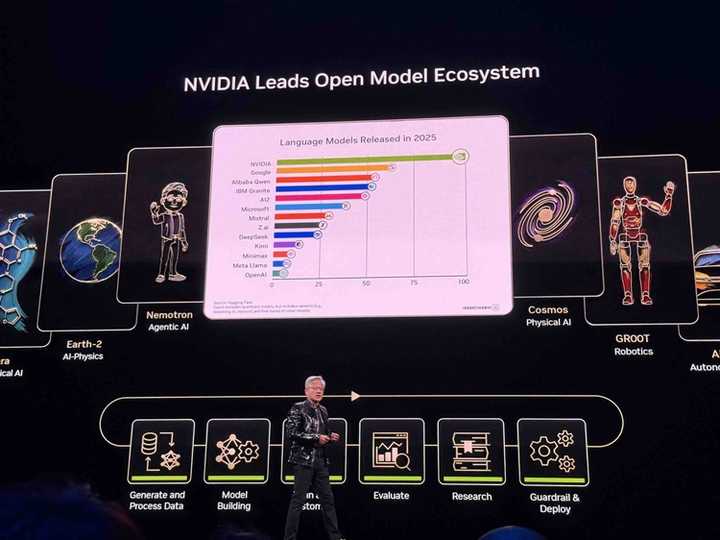

NVIDIA Alpamayo架构 这是一个开源视觉-语言-动作模型(VLA),专为自动驾驶设计,支持chain-of-thought推理来处理边缘场景。输入是多摄像头视频、自车运动历史、可选用户指令,输出是驾驶决策、因果推理、轨迹规划。 演示视频中称之为“物理AI的ChatGPT时刻几乎就要到来了”(The ChatGPT moment for physical AI is nearly here)。首个商用落地是Mercedes-Benz CLA,2026年Q1在美国上市。 值得注意的是,英伟达不仅开源了模型,还开源了训练数据。“我们不仅开源模型,还开源用来训练这些模型的数据。因为只有这样,你才能真正信任这些模型是怎么来的。” 黄仁勋演讲PPT里用到了很多中国开源模型的数据: |

|

|

经典场面:黄仁勋和中国开源模型们 不过,他最终要强调的是这张: |

|

|

英伟达才是开源第一。 一个信号 回看整场演讲的结构,黄仁勋想传递的信号很明确,AI的需求还在爆炸式增长,scaling law没有撞墙,英伟达的护城河不仅是芯片设计能力,更是整个系统级的极致协同优化能力。 当摩尔定律放缓时,只有通过“激进的、极致的协同设计”,例如六颗芯片同时重新设计,才能跟上AI发展的速度。而且这一切都不是空话,Vera Rubin已经在全面投产,不是路线图,不是期货,是现在就在产线上跑。2026年,云厂商和AI公司将拿到比Blackwell强5倍的新硬件。 黄仁勋的最后一张幻灯片这样写道: 英伟达是为所有AI提供的那个独一无二的平台。 |

|

|

这个开年演讲相比过往黄仁勋的演讲要“干”很多,看来2026年黄仁勋不讲故事了,要直接上干货,上硬菜了。 |

|

几个重要的事,我简单总结下: 1、今年的CES没有新的消费级GPU 我觉得最重要的一个是老黄已经明确表示不会在GeForce社区更新中发布新的消费级GPU了,这么多年的CES每年都会发布一个消费级的新品,但是今年没有了。 这对游戏玩家来说这不是好消息,但从商业角度看完全能理解老黄的战略方向的变了,他说有100万亿美元的产业投资正在向AI转移,这个市场规模完全不是消费级显卡能比的。所以在老黄眼里还真是 “游戏玩家不如狗” 。 2、Vera Rubin平台 这应该算是整个演讲里面最核心的发布:这个名字来自天文学家薇拉·鲁宾,她研究暗物质做出了巨大贡献,老黄还是继续以科学家来命名新产品。 这次发布的不是单个芯片而是由六种新芯片构成的完整系统,性能数据据说相当夸张:相比上一代Blackwell,推理性能提升5倍,训练性能提升3.5倍,token成本直接降低10倍。(PPT写的) |

|

|

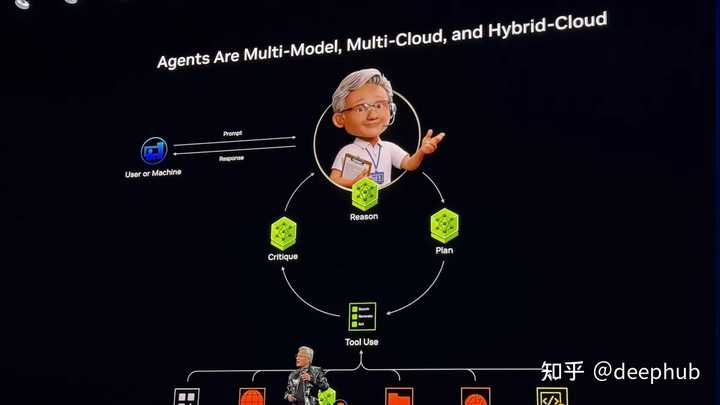

Vera Rubin NVL72机架里塞了72个Rubin GPU和36个Vera CPU,提供260 TB/s的带宽。老黄在台上说这个带宽超过了整个互联网的带宽,虽然我觉得这个说法可能有点夸张的成分但确实能看出规模有多疯狂。 不过大家手里可能连 B200 都还没摸热乎甚至可能还没出货,老黄直接就把 Rubin 平台端上来了而且还明确表示 Rubin 全系产品已经进入“全面生产”阶段,2026年下半年会正式出货。说明老黄面对TPU和AMD的竞争也是真急了(至少是重视了)。 3、Agentic AI 老黄特别强调了"Agentic AI"的概念,就是那种能进行更高层次推理的智能代理。他把2025年定义为智能代理模型激增的一年,这个趋势会延续到2026年及以后。这个可能是和我们最相关的了,可以看出来老黄也看好智能代理,能从侧面看得出来 26年肯定是智能代理大发展的一年,各位如果想搞事情,一定不要错过。 |

|

|

4、Physical AI 老黄在这块押注很大,特别是自动驾驶,还开源了端到端自动驾驶模型Alpamayo,这方面我不熟悉,而且我觉得目前限制还太多,我就不班门弄斧了。 |

|

|

总结 整体来说这次演讲清楚地展示了老黄从游戏显卡公司到AI基础设施核心供应商的转型的明确目标和路径。而且他的目标已经不再只是卖芯片,而是在提供完整的解决方案,从硬件到软件再到生态系统。 看来老黄是把自己的AI绑死了,在他眼里游戏玩家已经不重要了。 “表侄女”的信息汇总也整理完了,有兴趣的看看,做个对比 送礼物 还没有人送礼物,鼓励一下作者吧 |

|

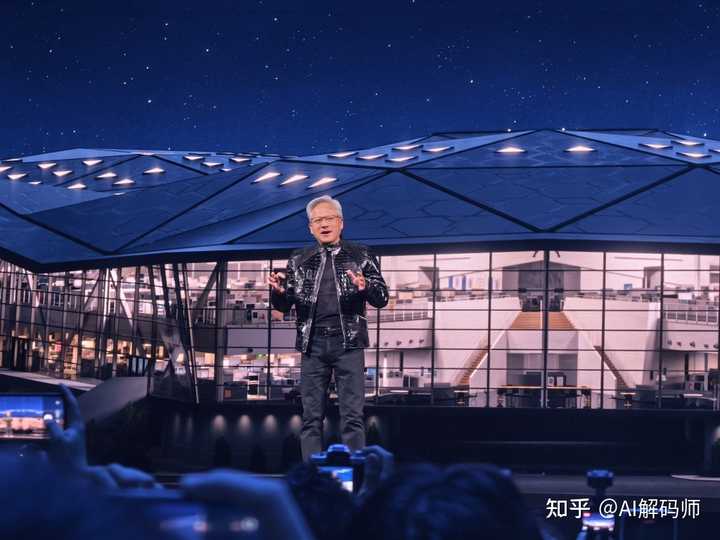

我来做一个应该是比较完整的记录。 先写在前边,对CES发表一点感受,说CES是科技风向标一点都不为过。十五年前吧,来CES,是移动互联网,五年前,CES是车展,现在则成了AI展。技术概念风水轮流转,但是CES地位一直不倒,原来我们总说苹果不来,但是以现在AI扛大旗的趋势,苹果来不来,其实都不那么重要了。 接下来,就是黄仁勋演讲的完整记录了。鉴于有回答贴了不少图片,我就贡献一个双语字幕的演讲视频吧。 |

|

|

108:38 CES2026黄仁勋演讲双语字幕版:同时有两种技术发生平台级迁移,这是历史上第一次! 我特别同意他说现在是两种平台同时转移,因为过去一年我和别人讲AI,大体也是这个思路,这是第一次,应用和平台融为一体,软件的开发方式和软件的呈现方式,都发生了变化,真的是技术历史上第一次。 所以,AI革命,真的和互联网、移动互联网、云计算不一样,本质性的不同! 1月5日,CES正式开幕前一天,英伟达CEO黄仁勋在拉斯维加斯枫丹白露酒店发表了长达90分钟的主题演讲。3000人挤满主会场,庭院里2000人通过大屏幕观看,四楼原本的展区临时改成了观众区。 虽然CES传统意义上是一个消费电子展,但是AI的到来,让后端业务和前端体验很难再区分。市值4.6万亿美元的英伟达,在2025财年Q3的数据中心业务收入达到512.5亿美元,同比增长66%。黄仁勋演讲所谈及的下一步棋,很多都涉及数据中心。 演讲中有一个细节。英伟达内部有一条规则:“任何新一代产品,都不应该有超过一两款芯片的改动。”常规迭代时,GPU更新了,其他芯片可以沿用或小改。但Vera Rubin打破了这个规则——Vera CPU、Rubin GPU、NVLink 6 Switch、ConnectX-9 SuperNIC、BlueField-4 DPU、Spectrum-X Ethernet Photonics Switch,六款芯片全部重新设计,投入了15000“工程师年”的工作量。 为什么?黄仁勋给出的解释是:摩尔定律已经放缓,Rubin的晶体管数量只比Blackwell多1.6倍,但我们面临着每年模型增大10倍、生成Token多5倍的压力,如果只是遵循常规的芯片迭代速度,根本不可能跟上。“所以在这一代产品上,我们别无选择,只能把每一块芯片都重新设计一遍。” 这场演讲的背景,是一个正在发生的产业大迁移:过去十年积累的10万亿美元计算基础设施正在被AI重塑,每年两千亿美元的风险投资涌入这个领域,100万亿美元的全球产业研发预算开始转向。“人们问,预算从哪里来?”黄仁勋说,“就是从那里来的。” 一、计算平台的重塑 黄仁勋将演讲的第一部分,用于描绘一幅产业图景。 每隔10到15年,计算机行业就会重置一次,即平台级的转变。从大型机到PC,从PC到互联网,从互联网到云,从云到移动时代。每一次平台转移,都意味着开发者会为新的计算平台编写新的应用程序,应用世界都会随着新平台重新构建。 “但这一次,与以往都不同。”黄仁勋停顿了一下,“事实上,我们正在同时经历两场平台级的变革。” 第一场变革是应用层面的,当世界转向AI时,应用程序将建立在AI之上。起初,人们认为AI本身就是一种应用,比如一个聊天机器人或一个图像生成器,这没错,但更重要的是,AI正在成为一个新的平台,未来的应用程序将构建在AI之上。 第二场变革,则更彻底:软件的运行方式和开发方式都在被重塑。计算机产业延续了几十年的“五层蛋糕”技术栈(从底层硬件到上层应用)正在被逐一重塑,这就包括: 开发方式的转变:我们不再是“编写”软件(Program the software),而是“训练”软件(Train the software)。运行平台的转变:软件不再主要运行在CPU上,而是运行在为并行计算而生的GPU上。交互模式的转变:过去的应用程序是预录制、预编译的,在设备上运行固定的逻辑。而现在的AI应用,能够理解上下文,每一次交互都是从零开始、即时生成每一个像素、每一个Token。 这意味着什么?黄仁勋进一步解释:“计算(Computing)已经被加速计算和人工智能从根本上重塑了。”这场变革的深远影响体现在经济层面。他估算,过去十年全球在传统计算领域积累的约10万亿美元的产业价值,如今都面临着向这种新型计算模式进行“现代化升级”的需求。 那么,钱从哪来?面对这个外界普遍关心的问题,黄仁勋指出,首先,每年数千亿美元的风险投资(VC)正涌入这个领域,用于资助创新和现代化进程。其次,是全球高达百万亿美元体量的各类产业,正在将其研发预算(通常占收入的几个百分点)从传统方法转向人工智能方法。 “人们问钱从哪里来?这就是钱的来源。将传统IT基础设施升级为AI基础设施,将传统研发方法转变为AI驱动的研发方法。巨额的投资正涌入这个行业,这也解释了为什么我们如此忙碌。” 二、2025年度盘点:五个突破改变游戏规则 在讲了宏观产业背景后,黄仁勋将演讲拉回刚刚过去的2025年,他说这一年“令人难以置信”,仿佛所有重要进展都在同一时间发生。他梳理了推动AI发展的五大关键技术突破,为后续的产品发布构建了基础逻辑。 第一个突破:扩展定律(Scaling Laws)持续有效。自2015年BERT模型崭露头角,到2017年Transformer架构的诞生,再到2022年引爆全球的ChatGPT时刻,AI的发展很大程度上遵循一个核心规律:投入越多的计算资源,模型就越智能。黄仁勋特别指出,在ChatGPT发布一年后,一个重要进展发生了——GPT o1作为首个真正意义上的推理模型,引入了“测试时扩展”(Test-time Scaling)的概念。 这使得AI的学习和应用过程被划分为三个阶段,每个阶段都需要巨大的算力,并且扩展定律在每个阶段都持续有效。上图最左侧方框,展示了AI的「智能」水平如何随着「计算」投入的增加而提升。这不是一条线,而是三条: 预训练(Pre-training):模型通过学习海量数据获得基础知识;后训练(Post-training):通过强化学习(Reinforcement Learning)等技术,让模型学习特定技能,使其行为与人类期望对齐。测试时扩展(Test-time Scaling):一种更通俗的说法,就是“思考”(Thinking)。在面对一个具体问题时,AI不再是瞬间给出一个答案,而是可以花更多时间进行实时推理,从而得到更优解。 这表明,无论是模型的初始学习、后续微调还是实际应用,更多的计算力都能带来更强的性能,扩展定律依然有效。 第二,AI走向智能体化 (AI BECOMES AGENTIC)。智能体的概念从2024年开始出现,并在2025年迅速普及的“智能体系统”(Agentic Systems),标志着AI角色的重大转变。AI不再仅仅是被动回答问题的工具,而是进化为能够主动执行复杂任务的“智能体”。这些智能体模型具备了推理、查阅信息、做研究、使用工具、规划未来、模拟结果的能力。黄仁勋特别提到了Cursor,称“Cursor彻底改变了英伟达内部做软件编程的方式”。 第三,物理AI实现飞跃 (PHYSICAL AI TAKES LEAP)。AI不仅在数字世界发展,也开始与物理世界深度融合。黄仁勋将这种能理解自然法则、与物理世界互动的AI称为「物理AI」。他进一步区分了两个相关但不同的概念: 物理AI(Physical AI):指AI能够与物理世界进行交互,例如控制机器人。AI物理学(AI Physics):指AI能够理解物理世界的规律,例如学习流体力学、材料科学等。 第四,AI学习自然法则 (AI LEARNS LAWS OF NATURE)。这是对“AI物理学”的进一步延伸。AI的应用正在深入基础科学领域,开始学习和理解物理世界的根本规律。 黄仁勋解释说:“宇宙中任何存在信息和结构的地方,我们都可以教一个模型去理解这些信息,理解其表征,并将其转化为AI。”这使得AI能够在生物学、化学、药物研发等领域,通过分析海量数据发现人类难以察觉的模式,加速科学发现。 第五,开源模型达到前沿水平(OPEN MODELS REACH FRONTIER)。这是去年发生的最重要事件之一。开源AI模型的能力正在迅速追赶,甚至在某些方面达到了最顶尖的闭源商业模型的水平。 黄仁勋特别提到了DeepSeek R1,称其为第一个具备推理能力的开源系统,“让世界大吃一惊,并真正激活了整个开源模型领域”。 他指出,尽管开源模型目前仍稳定落后于最前沿的闭源模型大约六个月,但每六个月都会有新的、更智能的开源模型涌现,这极大激发了全球的创新活力:初创公司、大企业、研究人员、学生,乃至每一个国家都希望参与到这场AI革命中。“智能,作为一种数字形式,怎么可能让任何人掉队呢?”他反问道。开源模型的蓬勃发展,使最先进的AI技术不再被少数公司垄断,整个行业生态因此将被重塑。Hugging Face等平台的模型下载量呈爆炸式增长,正是这一趋势的最好证明。 三、DGX Cloud与开源模型:英伟达的另一面 在梳理了年度五个突破,特别是开源模型的崛起之后,黄仁勋顺势将话题引向了英伟达自身的战略定位和贡献。他透露,英伟达在几年前就已经预见到这一趋势,并开始投入巨资建设和运营自己的AI超级计算机,即DGX Cloud。 “很多人问我们,是不是要进入云计算业务?答案是否定的。”黄仁勋澄清道,“我们建造这些价值数十亿美元的DGX超级计算机,是为了我们自己使用,为了开发我们自己的开源模型。” 他逐一介绍了英伟达的开源模型家族,在各个领域落地。数字生物学方面,La Proteina用于合成和生成蛋白质;OpenFold 3用于理解蛋白质结构;Evo 2用于理解和生成多种蛋白质的相互作用,是构建细胞级表征的开端。地球科学方面,Earth 2包含的ForecastNet和CorrDiff模型,改变了天气预测的方式;大语言模型方面,NemoTron是一个开创性的混合Transformer-SSM(状态空间模型)架构,速度极快,能够进行长时间或非常快速的思考,并产生高质量的回答,黄仁勋预告,近期将发布更多Nemotron-3的变体。世界模型方面,Cosmos能够理解世界是如何运作。人形机器人领域还有Groot模型,专注于关节运动、移动性和步态。自动驾驶领域还有Alpamayo,是英伟达在自动驾驶领域的最新成果,后文会详述。 黄仁勋特别强调了英伟达的开放精神不仅限于模型本身。“我们不仅开源模型,还开源我们用来训练这些模型的数据。因为只有这样,你才能真正信任这些模型是如何产生的。” 除了模型和数据,英伟达还推出了一整套库——NeMo库、Physics NeMo库、Clara NeMo库、Bio NeMo库等,这些库是针对特定领域的AI生命周期管理系统,覆盖了从数据处理、数据生成、模型训练、模型创建、评估、护栏设置、一直到最终部署的全流程。老黄坦言,这些库“极其复杂”,但全部都是开源的。 通过这一系列举措,英伟达将自己定位为“一个前沿AI模型的构建者”,并且是以一种完全开放的方式来构建,旨在“赋能每一家公司、每一个行业、每一个国家,让他们都能成为这场AI革命的一部分”。他展示了一张图,显示英伟达在PDF检索、语音识别、语义搜索等多个排行榜上名列前茅。 四、Agentic AI崛起 在介绍了英伟达的开源模型矩阵后,老黄将焦点集中在当前AI领域的最热潮——智能体AI(Agentic AI)。他认为,这是AI能力的一次根本性飞跃,也是构建未来应用的基本框架。 他首先回顾了ChatGPT刚问世时的普遍观感:结果很有趣,但“幻觉”(Hallucination)问题严重。黄仁勋解释了幻觉的根源:“模型可以记住过去的一切,但它无法记住未来或当前正在发生的事。”因此,AI的回答需要被“锚定”(Grounded)在事实中,在回答问题之前做基础研究。 这正是智能体系统(Agentic System)所要解决的核心问题。一个智能体在回答问题之前,会先进行基础研究。它具备一种元认知能力——“推理”(Reasoning)。它会思考:我需要做研究吗?我需要使用工具吗?我如何将问题分解成步骤?每一步,都是AI模型知道如何做的事情,它们能够组合成一系列步骤,执行从未被训练过的任务。 智能体能够将一个它从未被训练过来解决的复杂任务,分解为一系列它已知的、可以执行的子任务,然后将这些步骤组合起来完成最终目标。黄仁勋将此比作人类的能力:“我们遇到一个从未见过的情况,并将其分解为我们过去经历过的且懂得如何处理的子情境、知识和规则。”黄仁勋解释道,这就是推理的奇妙能力,强化学习、思维链、搜索、规划等技术的结合,使得这种基础的推理能力成为可能,并且这些技术现在也已完全开源。 紧接着,黄仁勋分享了一个让他觉得“完全是天才”的突破性想法——多模型架构,这个想法的灵感来自于AI搜索公司Perplexity创始人Aravind Srinivas。他第一次见到Perplexity在同时使用多个模型来解决问题时,深受启发。“当然了,我们人类会这么做,一个AI当然也应该能够调用世界上所有伟大的AI来解决它在推理链中任何一个环节遇到的问题。” 基于这一洞察,黄仁勋提到未来AI应用的宏观架构,这个架构具备几个关键特征: 多模态(Multi-modal):AI能够理解语音、图像、文本、视频、3D图形、蛋白质结构等多种类型的信息。多模型(Multi-model):AI能够根据任务的具体需求,调用最适合该任务的模型。多云(Multi-cloud):由于这些不同的AI模型可能部署在世界各地的不同云服务上,因此这种架构天然就是多云的。混合云(Hybrid-cloud):对于企业、机器人或边缘设备(如蜂窝基站、医院)等需要数据实时处理和隐私保护的场景,模型可以部署在本地。 这个由智能体驱动的,集多模态、多模型、多云/混合云于一体的框架,不仅为AI初创公司注入了强大的动力,也让企业能够定制化自己的AI。黄仁勋解释道:“你可以教你的AI一些别人没有教过的技能,让你的AI在某个特定领域变得智能。这正是我们通过Nemotron、Nemo和所有开源模型想要实现的目标。” 为了让大家理解这个抽象的框架,黄仁勋现场播放了一段演示视频:如何快速构建个人的AI助理。 视频中,一位开发者展示了如何利用这个框架,将一个名为“Reachy”的迷你机器人(由Hugging Face提供)变成一个功能强大的个人助理。这是该智能体的工作原理: 1、设定目标:开发者希望助理能帮他处理日历、邮件、待办事项,甚至照看家里。 2、本地化与隐私:他使用Brev工具将自己的DGX Spark(一台小型AI工作站)变成个人云。为了保护邮件隐私,他部署了一个在本地Spark上运行的开源模型。 3、智能路由:他设置了一个基于“意图”(Intent-based)的模型路由器。这个路由器就像一个管理者,当用户的指令(Prompt)涉及到邮件时,它会自动将任务分配给本地运行的开源模型处理;而其他通用任务,则可以调用外部更强大的前沿模型API。 4、连接物理世界:他将智能体与Reachy机器人的头部、耳朵和摄像头连接起来,通过工具调用(Tool Calls)来控制机器人。 5、赋予声音:他接入了11 Labs的API,让机器人拥有了自然流畅的语音。 演示中,这个名为Reachy的AI助理展现了惊人的能力: 查询信息。开发者问:“今天我的待办事项是什么?” Reachy回答:“买菜(鸡蛋、牛奶、黄油),以及把新脚本发给黄仁勋。”执行任务。开发者说:“好的,给Jensen发个更新,告诉他我们今天之内会搞定。” Reachy回应:“没问题。”多模态创作。开发者问:“这里有张草图,能把它变成建筑效果图吗?” Reachy迅速生成了一张精美的效果图,接着它还能根据指令生成一段展示房间的视频。远程协作与环境交互。开发者将Reachy的访问权限分享给了同事Anna。Anna远程问:“Potato(一只狗的名字)在干嘛?” Reachy通过摄像头看到狗在沙发上,并结合它记住的主人喜好,主动对狗发出指令:“Potato在沙发上。我记得你不喜欢这样,我会让它下去。Potato,下沙发!” 黄仁勋总结说,这个结合了前沿闭源模型和本地定制化模型的智能体框架,能够连接工具、文件甚至其他智能体,正是现代AI应用的基本架构。 更重要的是,这套框架正在被深度集成到企业平台中,例如:Palantir的整个AI和数据处理平台正在被英伟达加速;ServiceNow,世界领先的客户服务和员工服务平台;Snowflake,云端世界顶级数据平台;CodeRabbit,英伟达内部各处都在使用;CrowdStrike,创建AI来检测AI威胁;NetApp的数据平台现在有英伟达语义AI和Agentic系统用于客户服务。 黄仁勋强调,未来Agentic系统就是交互界面。这些交互界面不再是传统的Excel表格或命令行,而是像与人交谈一样自然、多模态的智能体界面。你与平台互动的方式更加简单,就像你在与人互动一样。" 五、物理AI的实现路径 从数字世界的智能体,黄仁勋将话题过渡到他最关注的领域之一:物理AI(Physical AI),他坦言英伟达已经投入物理AI八年之久。 核心问题是:如何让一个存在于计算机内部、通过屏幕和扬声器与人交互的智能,真正走向物理世界,理解并与之互动? 这意味着AI必须理解物理世界运作的“常识”:物体恒存性(Object Permanence):如果看向别处,再移回视线,那个物体依然在那里。因果关系(Causality):如果推一个东西,它会倒下。物理规律:AI需要理解摩擦力、重力、惯性,它要知道,一辆重型卡车需要更长的刹车距离,一个球会持续滚动。 这些对一个小孩来说都是常识,但对AI而言却是完全未知的。为了教会AI这些,英伟达构建了一个独特的系统,这个系统需要三种不同的计算机协同工作: 一台计算机用于训练AI模型,这是英伟达的传统强项;一台计算机用于推理,即机器人计算机,运行在汽车、机器人、工厂等边缘设备中,执行模型的推理;还有一台是仿真计算机,这是实现物理AI的基础,黄仁勋强调,“「仿真(Simulation)」是英伟达几乎所有工作的核心。”AI如何知道它执行的动作是否正确?它必须能够在一个虚拟环境中模拟物理世界对它动作的反馈。没有仿真,就无法评估AI的行为,因为现实世界的每一次互动都是不可复现的。 基于这“三大计算机”,英伟达构建了相应的软件栈: Omniverse:一个基于物理的、用于创建数字孪生(Digital Twin)的仿真世界。Cosmos:一个世界基础模型(World Foundation Model)。它不是语言模型,而是关于世界如何运作的模型,并且能与语言对齐。你可以问它“那个球怎么样了?”,它会告诉你“球正在街上滚动”。机器人模型:包括用于人形机器人的Groot和用于自动驾驶的Alpaca。 在物理AI的训练中,一个巨大的挑战是数据从何而来。语言模型可以从海量的文本中学习,但如何教AI物理世界的“基准真相”(Ground Truth)?现实世界的视频虽然很多,但远不足以覆盖所需的多样性和交互类型。 “这就是伟大思想汇聚的地方,”黄仁勋说,“我们将‘计算’转化为了‘数据’。” 这个核心思想就是合成数据生成(Synthetic Data Generation),通过使用基于物理定律和基准真相约束的仿真环境,可以有选择地、巧妙地生成海量、高质量的训练数据。 他展示了一个基于Cosmos世界模型的惊人演示,说明了“计算换数据”的过程: 1、输入:一个简单的交通模拟器生成的抽象轨迹数据,这些数据本身不足以让AI学习。 2、生成:将这些轨迹数据输入到Cosmos基础模型中。 3、输出:Cosmos能够生成基于物理的、逻辑上合理的、照片级的环绕视频。这些视频包含了丰富的细节,如光影、天气、车辆材质等,可以作为高质量的训练数据。 Cosmos的能力远不止于此。视频演示了它的多项“物理AI技能”: 从文本/场景生成视频:根据简单的场景描述或路况提示(如“一个危险的并线”),生成逼真的视频片段,将各种边缘案例(Edge Cases)生动地呈现出来。闭环仿真:开发者可以在Cosmos中进行交互式闭环模拟。当AI做出一个动作(如打方向盘),Cosmos会实时模拟出世界的响应。物理推理:Cosmos能够分析边缘场景,将其分解为熟悉的物理交互,并推理接下来可能发生什么。 “Cosmos是领先的世界基础模型,它的下载量已达数百万次,正在帮助全世界为物理AI的新时代做准备。”黄仁勋分享说,而英伟达自己,也正是利用Cosmos来生成场景、进行评估、从而打造其自动驾驶汽车AI。 六、Alpamayo诞生:全球首个具备思考与推理能力的自动驾驶AI 在讲了物理AI的实现路径和核心工具Cosmos之后,黄仁勋正式揭晓了这一理念下的集大成者——Alpamayo,并将其定义为“全球首个具备思考与推理能力的自动驾驶AI”。 Alpamayo的训练方式是端到端(End-to-End)的,即从摄像头输入直接到车辆的动作(转向、刹车、油门)输出。其训练数据来源是多样的,包括:大量由人类驾驶员操作产生的真实驾驶数据(Human Demonstration),以及大量由Cosmos模型生成的合成数据,还有数十万个经过精细标注的特定驾驶场景示例。 Alpamayo最与众不同之处在于,它在输出驾驶动作的同时,它还会“推理”它即将采取的行动并用“语言”表达出来。黄仁勋解释说,Alpaca会同时输出三样东西:第一,它将要采取的行动(Action);第二,它做出该行动的理由(Reason);第三,车辆的行驶轨迹(Trajectory)。这三者是紧密耦合、共同训练的。 这种“可解释性”之所以至关重要,是因为它解决了自动驾驶领域最大的挑战——长尾问题。我们不可能收集到世界上每个国家、每种情况下可能发生的所有驾驶场景。然而,任何一个罕见的复杂场景,都可以被分解为一系列AI已经理解和掌握的、相对正常的子场景。Alpamayo所具备的推理能力,正是为了处理这种分解和组合。 随后,黄仁勋播放了一段演示视频,视频中,一辆搭载Alpamayo的奔驰汽车在复杂的城市道路上行驶,UI界面实时显示Alpamayo的“内心独白”,可以做到绕过施工区域、避开紧急车辆、在十字路口无保护左转、为行人让行。整个驾驶过程流畅自然。 黄仁勋解释说,这种自然感正是因为它直接从人类驾驶演示中学习。而它在每个关键决策点都能清晰说出自己的意图和理由,这赋予了自动驾驶前所未有的透明度和信任感。 在演示之后,黄仁勋深入阐述了英伟达在自动驾驶领域的长远布局。他提到,英伟达八年前决定投身自动驾驶,正是因为预见到深度学习和AI将重塑整个计算栈,为了引领行业,他们必须亲身实践,构建从底层芯片到上层应用的全栈能力。 他再次用“五层蛋糕”模型来讲述自动驾驶技术栈: 最底层(车):汽车本身。第二层(芯片):GPU、CPU、网络芯片等,例如专为机器人系统设计的双Orin芯片和下一代双Thor芯片。第三层(基础设施):Omniverse和Cosmos,用于仿真和数据生成。第四层(模型):Alpamayo模型。第五层(应用):梅赛德斯-奔驰的整车产品。 黄仁勋透露,英伟达的自动驾驶团队规模已达数千人。五年前,他们与梅赛德斯-奔驰达成合作,共同开发这套系统。他透露,刚刚投产的、搭载该系统的奔驰CLA车型,被NCAP评为“世界最安全的汽车”,这是他所知的唯一一个从芯片、系统到每一行代码都经过安全认证的系统。 然而,Alpamayo虽然强大,但“长期驾驶它之前,没有人能保证它绝对安全”。因此,英伟达设计了一套独特的双软件栈冗余系统来作为安全护栏: 主驾驶栈:由端到端训练的Alpamayo模型驱动,具备强大的技能和推理能力。备用安全栈:一个完全可追溯的传统自动驾驶(AV)栈作为护栏。英伟达花了六七年时间来构建这个栈。 系统内部有一个“策略与安全评估器”(Policy and Safety Evaluator),在行驶过程中,评估器会实时判断:如果当前场景是Alpamayo非常有信心、能够安全推理并处理的,就由Alpamayo主导驾驶;如果遇到Alpamayo信心不足的场景,评估器会决定切换回更保守的传统AV栈来接管。 “这是世界上唯一一辆同时运行这两个AV栈的汽车,”黄仁勋强调,“所有的安全系统都应该具备多样性和冗余性。” 在商业模式上,黄仁勋展望,未来道路上数十亿辆汽车都将具备自动驾驶能力,它们可以是以Robotaxi,也可以是私家车。英伟达在自动驾驶领域的策略是,像做其他业务一样:构建完整的垂直整合堆栈,但将整个堆栈向生态系统开放。黄仁勋笑说:“无论你决定用多少,我唯一的请求是尽可能更多采用NVIDIA。” 对于梅赛德斯-奔驰这样的深度合作伙伴,英伟达将共同部署、运营和维护整个技术栈。但对于更广泛的汽车制造商和Robotaxi公司,他们可以根据自身需求,选择使用英伟达技术栈的任何一部分:可以只采购芯片,可以使用合成数据生成服务,也可以采用部分或完整的软件栈。 黄仁勋预计,自动驾驶将成为第一个大规模主流的物理AI市场,而这个拐点“可能就在此时此刻发生”:“在接下来的十年里,我相当确定,世界上非常大比例的汽车将是自动驾驶或高度自动驾驶的。” 七、机器人时代:当BDX走上舞台 自动驾驶的成果,为英伟达验证了一套可复制的方法论:即利用“三大计算机”(训练、推理、仿真)和合成数据生成,来解决任何形式的机器人系统问题。无论是机械臂、移动机器人,还是完全的人形机器人,都可以遵循这套范式。 “机器人技术的下一个时代,就是机器人本身。”黄仁勋说道。 为了活跃气氛,他邀请了几位“朋友”上台——两个星球大战BDX机器人缓慢走上舞台。“快点。我有很多东西要讲。快点。”黄仁勋催促道,引发观众笑声。这两个机器人都内置了小型Jetson计算机,并且它们的学习过程完全是在Omniverse中完成的。 随后,黄仁勋通过视频,向观众展示了这些机器人的仿真环境——Isaac Sim和Isaac Lab。在仿真世界里,机器人的数字孪生体可以进行无数次的试错和学习,然后将学到的技能部署到物理实体上。 舞台大屏幕上展示了英伟达的机器人合作伙伴生态系统,涵盖了从工业、物流到服务业的各种机器人形态:Neurabot、Adjubot、LG的新机器人、Caterpillar的巨型机器人、Serve Robotics的送餐机器人、Agility、Boston Dynamics、手术机器人、Franka的操纵机器人、Universal Robotics…… “没有人像你们这样可爱。”黄仁勋对着BDX机器人说。 工业设计行业的AI革命 但黄仁勋的视野并未止步于此,他指出,物理AI和AI物理学将要革命的下一个、也是对英伟达自身意义非凡的行业——工业设计与制造。 “如果没有我即将谈到的这些公司,英伟达就不可能存在。”老黄宣布了与三大EDA(电子设计自动化)和工业软件巨头的深化合作,包括:Cadence将NVIDIA CUDA-X、物理AI和AI物理学集成到其仿真和求解器中,Synopsys同样在系统设计和仿真领域与英伟达深度整合;西门子将NVIDIA CUDA-X、物理AI、智能体AI、Nemo、Nemotron等技术深度集成到其覆盖EDA、CAE和数字孪生工具的产品组合中。 黄仁勋描绘了一幅未来工业的蓝图:在设计阶段,芯片和系统将在Cadence和Synopsys的工具中被设计出来,这些工具由英伟达的GPU加速,并且会有“智能体芯片设计师”与人类工程师协同工作;在制造阶段,制造这些芯片和产品的工厂本身,也将首先在西门子的数字孪生平台中被完整地设计、模拟和优化,这些虚拟工厂将是“巨大的机器人”。 “你们将在计算机中被设计,你们将在计算机中被制造,你们将在计算机中被测试和评估,在你们必须花任何时间处理重力之前。”黄仁勋对着台上的BDX机器人说,“这是你们的未来。非常神奇,对吧?你们将在这些平台内部诞生。” “你们知道怎么处理重力吗?能跳吗?”机器人跳了一下。黄仁勋说:“好的,好的,别炫耀。” 八、Vera Rubin横空出世:以“极端协同设计”对抗摩尔定律放缓 在全场演讲的最高潮,黄仁勋将话题引向了驱动这一切的根本——算力。他首先解释了为什么AI算力需求正在以远超想象的速度爆炸式增长: 模型规模:模型参数量正以每年10倍的速度增长。后训练开销:为了教会AI“思考”,引入了强化学习等计算密集型技术,后训练阶段的算力消耗剧增。测试时扩展:“思考”过程取代了“一问一答”,导致生成的Token数量每年增加5倍。激烈的竞争:AI领域的军备竞赛异常激烈,所有人都想率先达到下一个前沿。这导致上一代AI模型的Token成本每年下降约10倍。而要维持这种成本下降,就必须依赖更快的计算来更快地达到下一个技术前沿。 “所有这一切,归根结底都是一个计算问题。”黄仁勋总结道。面对如此迅猛的需求增长,而摩尔定律早已放缓,半导体工艺能带来的晶体管数量增长(每年约1.6倍)已远远跟不上。 “如果我们不采取极端的措施,就不可能跟上这种速度。” 这个“极端的措施”,就是英伟达的“极端协同设计”(Extreme Co-design)理念——跨越整个技术栈,同时对所有关键芯片进行创新。这违背了英伟达内部“每一代产品只改变一到两款芯片”的常规准则。但黄仁勋表示,“这一代,我们别无选择,必须重新设计每一款芯片。” 于是,老黄正式发布了英伟达的下一代计算平台——Vera Rubin。 黄仁勋介绍了这个名字的由来:Vera Rubin是一位美国天文学家,她是第一个注意到星系尾部移动速度与中心差不多快的人,她发现了暗物质。 Vera Rubin平台是一个由六款全新设计的、协同工作的突破性芯片组成的系统: VeraCPU:88个定制Olympus核心,1.5TB系统内存,1.2 TB/s LPDDR5X,2270亿晶体管。这些核心使用一种叫做”空间多线程”的技术设计,多线程特性使每个176个线程都可以获得完整性能——本质上就像有176个核心,但只有88个物理核心。Rubin GPU:3360亿晶体管,5倍Blackwell NVFP4推理性能。黄仁勋特别强调,Rubin只有Blackwell晶体管数量的1.6倍。NVFP4 Tensor Core是其中的关键创新。这不是简单的四位浮点数,而是一个完整的处理单元,理解如何动态、自适应地调整精度和结构来处理Transformer的不同层次。“当有人说FP4或FP8时,这对我们来说几乎没有意义。”黄仁勋说,“是Tensor Core结构和所有算法使它工作。”ConnectX-9:英伟达收购的Mellanox团队出品的全球最佳网络接口卡(NIC),为每个GPU提供1.6Tb/s的横向扩展带宽。Bluefield-4 DPU:一款革命性的数据处理器,用于卸载存储、安全和虚拟化任务,让计算单元专注于AI工作负载。NVLink 6 Switch:其SerDes速率高达400Gb/s,使得机柜内所有GPU之间可以全互联通信。一个机柜背板的总带宽高达240TB/s,是全球互联网总带宽的两倍。Spectrum-X Ethernet Photonics Switch:全球首款集成硅光技术(Co-Packaged Optics)的以太网交换机,拥有512个200Gb/s端口,用于AI工厂的大规模横向扩展。 黄仁勋宣布,Vera Rubin目前“已全面投产”。 九、重塑数据中心 在介绍了Vera Rubin平台的六大核心芯片后,黄仁勋揭示了这一新架构将如何从根本上重塑数据中心的存储体系。 他解释说,当AI模型进行多轮对话或处理长上下文时,会产生一个巨大的“工作记忆”,称为KV缓存(KV Cache)。这个缓存最初存放在GPU自带的高带宽内存(HBM)中。但随着模型增大、对话变长,HBM很快就不够用了。上一代Grace Blackwell通过CPU的内存扩展了KV缓存,但即便如此也依然捉襟见肘。 传统的解决方案是将KV缓存卸载到外部存储网络中,但这会给数据中心的南北向网络带来巨大压力,成为性能瓶颈。 “答案显然是,用一种不同的方式来做。” 英伟达的解决方案是利用全新的Bluefield-4 DPU,在计算集群的机架内,创建一个专用的、超高速的KV缓存存储层。这个新平台被称为Dynamo KV Cache。 在新的Vera Rubin机架设计中,除了计算节点,还增加了一排专门的存储节点。每个存储节点由4个Bluefield-4 DPU驱动,每个DPU后面连接着150TB的存储。这使得机架内的每个GPU,在自身1TB内存的基础上,可以额外获得高达16TB的超高速KV缓存扩展。这些缓存通过与计算节点相同的、200Gb/s的横向网络(East-West Traffic)连接,实现了前所未有的低延迟访问。 这一创新解决了AI推理中最大的痛点之一,受到了AI实验室和云服务商的热烈欢迎。 最后,黄仁勋展示了Vera Rubin平台带来的惊人性能提升:在训练性能方面,对于一个10万亿参数的前沿模型,使用Vera Rubin系统所需的机架数量仅为Blackwell系统的四分之一。在推理吞吐量(工厂效率)方面,在功耗相同的情况下,Vera Rubin的推理吞吐量大约是Blackwell的10倍。在Token成本方面,Vera Rubin将生成Token的成本再次降低了一个数量级,大约是Blackwell的十分之一。 此外,Vera Rubin平台还实现了全链路的机密计算(Confidential Computing),所有在途、静止和计算中的数据都经过加密,确保了模型的安全性。同时,通过电源平滑(Power Smoothing)技术,解决了AI负载瞬时功耗尖峰的问题,使得数据中心可以更充分地利用其电力预算。 “这就是今天的英伟达。”黄仁勋在演讲的尾声总结道,“我们曾被认为是一家芯片公司,但如你所见,我们现在构建整个系统。AI是全栈的,我们正在从芯片、基础设施、模型到应用,全方位地重塑它。我们的工作,就是创造完整的技术栈,让你们所有人都能为世界创造出不可思议的应用。” 十、一个彩蛋 演讲结束前,黄仁勋卖了个关子,他说:“在结束之前,我们留下了一大堆PPT,所以这里有一些花絮。” 屏幕上播放了一系列搞笑片段:老黄这场演讲的PPT,上面的文字出现一系列动效,扩展定律上的曲线掉落、自动驾驶汽车挡风玻璃误入一只松鼠 ?、人形机器人洗澡时刻、最后所有元素亮相、谢幕之后留下茫然的机器人问“大家都去哪了”……一个NG片段,相当于回顾了这场keynote的所有内容。 有趣的是,我记得黄仁勋很多年前接受采访,说如果他有一部传记电影,希望是成龙来演自己。现在黄仁勋把素材NG作为彩蛋,真是和成龙电影很像了。 |

|

老黄每年CES都发一堆东西,RTX新显卡、AI芯片、各种合作,媒体报道铺天盖地。今年他反复聊到了一个词:物理AI(Physical AI),物理AI的ChatGPT时刻已经到来”。 什么意思? 过去几年我们见证的AI进步,主要发生在数字世界里。ChatGPT能聊天,Midjourney能画图,Sora能生成视频。它们处理的是文字、图像、声音这些数字信息。但物理AI不一样。它要让机器在真实世界里理解环境、做出判断、执行动作。这俩是完全不同的技术路径,难度要高出好几个量级。 |

|

|

NVIDIA这次发布了几个东西,放在一起看: 1. 专为自动驾驶设计的新AI模型和芯片 不是通用芯片,是专门针对物理世界任务优化的。这说明NVIDIA认为物理AI的算力需求和数字AI有本质区别,需要专门的硬件架构。 2. 2027年测试机器人出租车服务 注意,不是”展望未来”,是给出了具体时间表。NVIDIA计划在2027年和行业伙伴一起测试robotaxi。这意味着他们内部评估,物理AI的成熟度已经接近商业化门槛。 3. 与Groq达成技术授权协议 Groq这家公司专门做实时推理芯片,强项是低延迟。物理AI对延迟极其敏感——自动驾驶汽车做决策的时间窗口是毫秒级的。NVIDIA选择和Groq合作,说明他们在补齐实时响应这块的短板。 4. Isaac GR00T N1和Cosmos模型 这两个是给机器人开发者用的。Isaac GR00T N1是人形机器人的开源基础模型,Cosmos是用来生成训练数据的。物理AI最大的瓶颈之一是训练数据稀缺——你不可能让真实的自动驾驶汽车撞几万次来收集数据。Cosmos的思路是用模拟生成合成数据,这是解决数据瓶颈的关键一步。 |

|

|

看了这么多年CES,老黄的演讲有一个规律:他很少在台上讲还没准备好的东西。 当他开始密集输出某个概念,通常意味着底层技术已经跑通了,只是需要时间让产业链跟上。2016年他在台上讲AI训练,后来深度学习爆发了。2022年他讲生成式AI,后来ChatGPT出来了。 这次他把物理AI提到”ChatGPT时刻”的高度。机器人、自动驾驶、智能制造这些领域,可能会在未来2-3年迎来一波技术突破。不是那种”实验室里跑通了”的突破,而是”可以开始商业化部署”的突破。 当然,物理AI的落地比数字AI复杂得多。涉及到法规、安全、伦理等一堆问题。但技术端的信号已经很明确了。 |

|

|

如果你只有10分钟看这场演讲,建议快进到老黄讲物理AI的部分。那才是这场发布会真正的重点,也是NVIDIA未来5年的战略方向。 RTX显卡什么的,发布会结束后看评测就行了。 视频链接:https://www.youtube.com/watch?v=M8fL0RUmbP0 |

|

这次CES 2026的亮点之一应该是新的芯片架构Rubin。 美国政府前段时间之所以愿意开放H200禁售的一个原因就是新一代架构Rubin即将到来,而且不会开放,美国也是寄希望新架构的AI芯片能让美国保持在人工智能的绝对领先地位。 这次老黄终于把Rubin搬出来了。 |

|

|

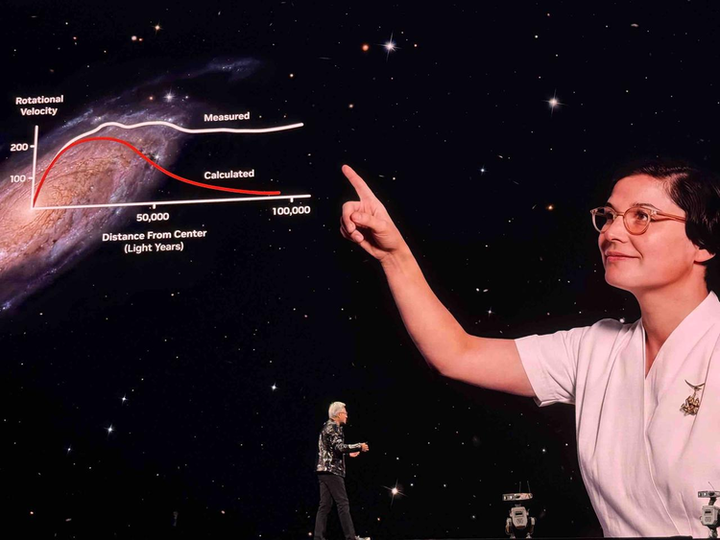

Rubin 平台以美国天文学家 Vera Florence Cooper Rubin 命名,她的发现改变了人类对宇宙的理解。 严格意义来说,Rubin不单单是一个全新的GPU,而是一个全新的计算平台,或者说是一款 AI 超级计算机。 |

|

|

Rubin 平台通过六款芯片的极致协同设计: NVIDIA Vera CPU、NVIDIA Rubin GPU、NVIDIA NVLink? 6 交换机、NVIDIA ConnectX?-9 SuperNIC、NVIDIA BlueField?-4 DPU 和 NVIDIA Spectrum?-6 以太网交换机 |

|

|

|

|

|

来大幅缩短训练时间并降低推理 token 成本。具体来说,Rubin 平台相比 NVIDIA Blackwell 平台,推理 token 成本最高可降低 10 倍,训练 MoE 模型所需的 GPU 数量减少 4 倍。 |

|

|

|

|

|

00:04 此外,NVIDIA Spectrum-X 以太网光子交换系统可将能效和运行时间提升 5 倍。而且,全新的 NVIDIA 推理上下文内存存储平台搭载了 NVIDIA BlueField-4 存储处理器,可以用于加速 agentic AI 推理。 |

|

|

从技术突破角度来说,Rubin平台带来的新东西是: 第六代NVLink:单GPU带宽达3.6TB/s,整机架带宽260TB/s(超整个互联网!)首款Vera CPU:专为AI工厂设计,88个定制核心,极致能效第三代Transformer Engine:Rubin GPU提供50 petaflops NVFP4算力第三代保密计算:全栈数据安全,保护核心AI资产第二代RAS Engine:模块化设计,维护速度提升18倍 英伟达给 Rubin 提供了两种配置方案:NVIDIA Vera Rubin NVL72机架级解决方案与NVIDIA HGX Rubin NVL8系统。 NVIDIA Vera Rubin NVL72将72个Rubin GPU与36个Vera CPU通过NVLink 6互联,使整个机架能够作为统一的计算单元运行。上面说的加速效果,就是指的NVIDIA Vera Rubin NVL72。 |

|

|

|

|

|

更进一步,NVIDIA Vera Rubin计算集群则通过连接16个NVL72机架,整合了1,152个Vera Rubin GPU。 而NVIDIA HGX Rubin NVL8集成八颗NVIDIA Rubin GPU,并搭载第六代高速NVLink互连技术,专为基于x86架构的生成式AI平台提供支持。其NVFP4计算性能较HGX B200提升5.5倍: |

|

|

老黄说: “NVIDIA Rubin 的问世恰逢其时,因为 AI 对计算的需求(无论是训练还是推理)正急剧飙升,凭借我们每年推出一代新 AI 超级计算机的节奏,以及六款新芯片的极致协同设计,Rubin 向 AI 的下一前沿领域迈出了一大步。” 各家大模型公司负责人来纷纷站台,OpenAI CEO 奥特曼表示: “智能随算力扩展。增加算力能让模型能力更强、解决更复杂的问题,并为人类创造更大影响。NVIDIA Rubin平台将助力我们持续扩展这一进程,使先进智能惠及所有人。” xAI CEO马斯克表示: “ NVIDIA Rubin将成为AI的火箭引擎。 若想大规模训练和部署前沿模型,这正是你所需的基础设施—— Rubin将向世界再次证明,NVIDIA就是行业黄金标准。 ” 什么时候能用上? 全线产品已经投入生产,预计 2026年下半年就会正式进入各大云平台(微软、谷歌、AWS等)。 |

|

|

00:27 总结: 老黄再次证明了,在AI这条路上,能超越英伟达的只有英伟达自己![笑哭R] 果然,最大的赢家还是老黄,还是英伟达。 送礼物 还没有人送礼物,鼓励一下作者吧 |

|

|

| [收藏本文] 【下载本文】 |

| 科技 最新文章 |

| 为什么有些人不敢使用微信? |

| 作业帮 iOS 版应用被曝存在假卸载按钮设计, |

| 你认为稀土是中国手里的终极王牌吗? |

| 如何看soul这个软件? |

| 如何看待FARS批量制造100篇论文? |

| 为什么有些用户宁愿看盗版,也不愿为正版视 |

| 英政府拟强制中资桥接芯片巨头FTDI出售80%股 |

| 如何看待姚班大神陈立杰官宣入职 OpenAI? |

| 微信有多傻逼? |

| 如何看待「斩杀线」概念的出现及其影响? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

|

娱乐生活:

电影票房

娱乐圈

娱乐

弱智

火研

中华城市

印度

仙家

六爻

佛门

风水

古钱币交流专用

钓鱼

双色球

航空母舰

网球

乒乓球

中国女排

足球

nba

中超

跑步

象棋

体操

戒色

上海男科

80后

足球: 曼城 利物浦队 托特纳姆热刺 皇家马德里 尤文图斯 罗马 拉齐奥 米兰 里昂 巴黎圣日尔曼 曼联 |

| 网站联系: qq:121756557 email:121756557@qq.com 知识库 |